MobileCLIP2:多模态强化训练革新移动端图像-文本模型性能

本文将深入解析MobileCLIP2的核心技术突破,重点探讨其在移动端图像-文本模型领域的性能提升与架构创新,帮助开发者快速理解其技术价值与应用场景。

MobileCLIP2是什么?

本文欲回答的核心问题:MobileCLIP2相比前代模型有哪些关键改进?

MobileCLIP2是苹果公司推出的新一代低延迟图像-文本模型家族,通过改进多模态强化训练方法,在ImageNet-1k零样本分类任务中实现了2.2%的准确率提升,同时保持更小的模型体积和更快的推理速度。其核心改进包括:

-

采用更高质量的DFN训练数据集 -

引入更强的CLIP教师模型集成 -

优化CoCa标题生成器的微调策略 -

提出新型五阶段架构设计

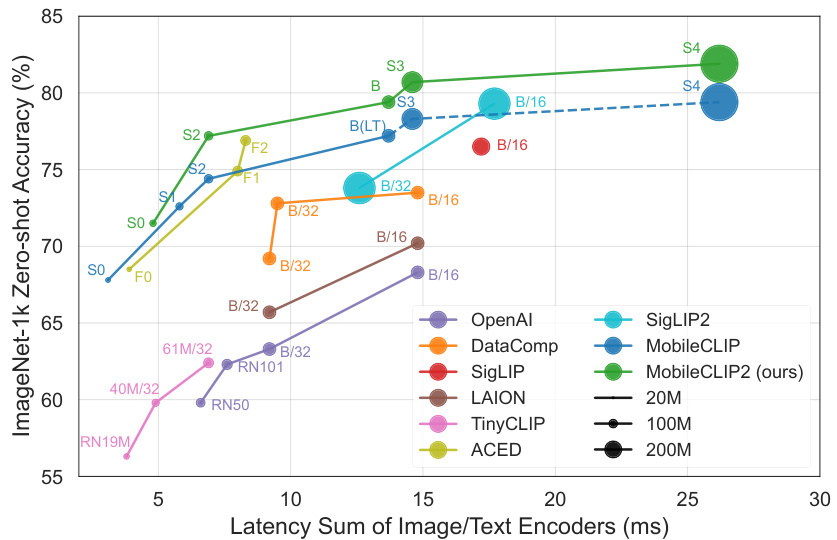

图1:MobileCLIP2-S4在iPhone12 Pro Max上以2.5倍更低延迟超越DFN ViT-L/14(图片来源:论文原图)

多模态强化训练的关键改进

本文欲回答的核心问题:多模态强化训练如何提升模型性能?

多模态强化训练通过结合真实数据与合成数据增强模型学习能力,MobileCLIP2在此基础上进行了三项关键改进:

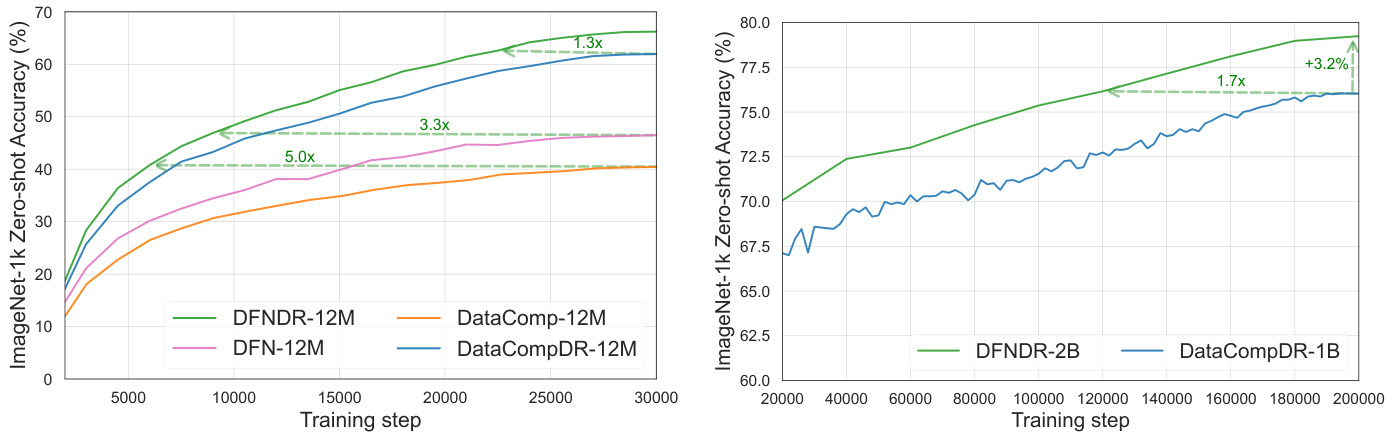

1. DFN数据集优化

-

数据质量提升:采用基于DFN-5B过滤的高质量12M子集,相比DataComp-1B12M在无蒸馏情况下提升6%准确率 -

效率验证:训练30M样本时,DFNDR-2B12M的数据效率是DataComp-1B12M的5倍

| 数据集 | 蒸馏 | 合成标题 | IN-val | Flickr30k | Avg.38 |

|---|---|---|---|---|---|

| DataComp-1B12M | × | × | 44.6 | 42.4 | 40.1 |

| DFN-5B12M | × | × | 49.9 | 48.5 | 43.5 |

表1:DFN数据集在无增强情况下的性能提升(单位:%)

2. CLIP教师模型升级

-

教师模型选择:采用DFN2B-CLIP-ViT-L-14-s39b与DFN2B-CLIP-ViT-L-14的集成 -

温度参数调优:不同教师模型需要独立优化logit scale参数(DFN2B模型最优值70 vs 原始模型50)

| 教师模型组合 | IN-val提升 |

|---|---|

| 原始OpenAI+DataCompXL组合 | 63.1% |

| DFN2B+DFN2B-s39b组合 | 65.9% |

表2:教师模型集成效果对比(单位:%)

3. 标题生成器改进

-

领域自适应微调:在DFN-2B预训练基础上,使用MSCOCO-38k进行微调 -

长文本支持:尝试255长度的上下文长度但未发现显著增益

图2:不同微调数据集对模型性能的影响(图片来源:论文原图)

MobileCLIP2架构设计

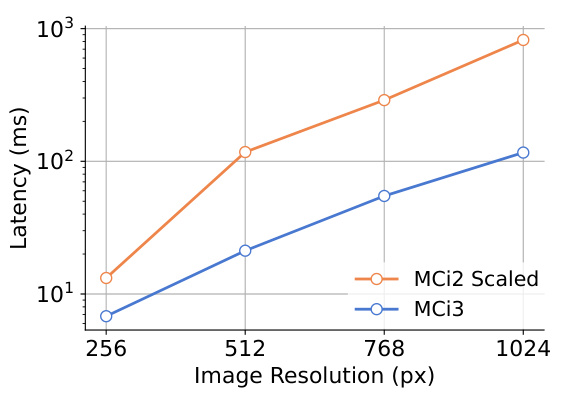

本文欲回答的核心问题:新型架构如何实现低延迟?

MobileCLIP2提出五阶段架构设计(MCi3/MCi4),相比传统四阶段设计具有两大优势:

-

参数分布优化:最大层级的参数在1/4分辨率特征图上运行 -

高分辨率扩展性:在1024×1024分辨率下推理速度提升7.1倍

图3:五阶段架构在256×256分辨率下快1.9倍(图片来源:论文原图)

实验结果与性能对比

本文欲回答的核心问题:MobileCLIP2的实际表现如何?

在ImageNet-1k验证集上,MobileCLIP2-S4达到与SigLIP-SO400M/14相当的准确率,但参数减少50%,延迟降低60%。典型模型对比如下:

| 模型名称 | 参数规模 | 延迟(ms) | IN-val准确率 |

|---|---|---|---|

| MobileCLIP2-S4 | 125M+123.6M | 19.6+6.6 | 83.2% |

| SigLIP-SO400M/14 | 427.7M+449.7M | 38.2+19.1 | 83.9% |

| DFN ViT-L/14 | 304.3M+123.6M | 57.9+6.6 | 82.8% |

表3:模型性能对比(数据来源:论文Table 8)

实际应用场景分析

1. 移动端图像分类

典型场景:手机相册自动分类

技术优势:

-

3-15ms的推理延迟支持实时处理 -

零样本分类能力无需针对相册场景微调 -

50-150M参数规模适配手机内存限制

2. 视觉-语言预训练

典型场景:多模态对话系统

技术价值:

-

在LLaVA-1.5框架下,DFNDR预训练模型比DataComp模型提升3.5%准确率 -

冻结视觉编码器即可实现高质量特征提取

常见问题解答 (FAQ)

Q1: MobileCLIP2适合哪些硬件平台?

A: 设计目标为移动设备,iPhone12 Pro Max实测显示MobileCLIP2-S4延迟仅19.6ms。

Q2: 合成标题生成器的改进对性能有多大影响?

A: 使用MSCOCO-38k微调的CoCa模型相比原始LAION-2B预训练模型,在IN-val上提升0.5%。

Q3: 五阶段架构相比传统设计有哪些优势?

A: 在1024×1024分辨率下,MCi3比同规模四阶段模型快7.1倍。

Q4: 如何选择适合的模型版本?

A: 根据延迟需求选择:S0(3ms) < S2(8ms) < S3 < S4(19ms)。

Q5: 在视觉-语言任务中表现如何?

A: 在8个VLM评测任务中,DFNDR预训练模型平均领先DataComp模型1.6%。

总结

MobileCLIP2通过系统性的训练方法改进与架构创新,在保持移动端友好体积和延迟的前提下,显著提升了零样本分类性能。其核心价值在于:

-

数据质量驱动:DFN数据集带来基础性能提升 -

教师模型优化:CLIP集成与标题器微调形成双重增强 -

架构创新:五阶段设计突破传统Transformer的扩展瓶颈

开发者可根据具体场景选择S0到S4不同规格模型,在移动端图像理解、跨模态检索等场景实现高效部署。