CodeMixBench:如何评估大语言模型在多语言代码生成中的表现?

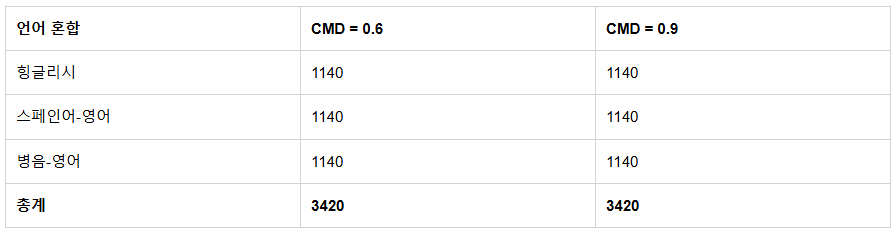

▲ CodeMixBench 的测试数据集结构示例

为什么我们需要关注代码混合的代码生成?

在印度班加罗尔的科技园区,开发者们习惯用”Hinglish”(印地语-英语混合)编写代码注释;墨西哥城的程序员会在文档中交替使用西班牙语和英语术语。这种**代码混合(Code-Mixing)**现象在全球软件开发中非常普遍,但现有的大语言模型(LLM)评估体系却忽视了这一点。CodeMixBench 的诞生,正是为了填补这一空白。

一、代码混合:被忽视的真实开发场景

1.1 什么是代码混合?

当开发者用两种及以上语言组合编写代码相关文本时(如注释、文档、报错信息),就形成了代码混合。例如:

# 用户 ka input validate karo(印地语-英语)

def validate_input(user_input):

if not user_input:

raise ValueError("Khali input nahi chalega!") # 印地语+英语报错

1.2 现有评估体系的局限

传统代码生成基准测试如 HumanEval、MBPP 存在三大问题:

-

单一语言依赖:仅测试纯英语提示 -

现实脱节:未反映多语言开发者的真实工作场景 -

模型偏差:可能高估英语中心化训练的模型性能

二、CodeMixBench 的突破性设计

2.1 核心创新点

| 特征 | 说明 |

|---|---|

| 多语言覆盖 | 支持 Hinglish(印地-英)、西班牙语-英语、汉语拼音-英语三种组合 |

| 混合程度控制 | 通过 CMD(Controllable Code-Mixing Degree)参数精确调控混合比例 |

| 语义保真 | 使用 GAME 评分确保混合后的提示保留原始语义(平均 90% 以上) |

2.2 数据生成四步法

-

基础翻译:保留编程术语,翻译自然语言部分 -

词性标注:识别可替换的名词/动词/形容词 -

混合注入:根据真实语料库的词汇频率控制替换比例 -

罗马化处理:确保非英语字符与编程语法兼容

三、17 个模型的性能大比拼

3.1 测试结果速览

| 模型类型 | CMD=0.6 性能保留率 | CMD=0.9 性能保留率 |

|---|---|---|

| 大型指令调优模型(7B+) | 85-92% | 70-78% |

| 中型蒸馏模型(3-7B) | 72-80% | 55-65% |

| 小型基础模型(1-3B) | 50-60% | 30-40% |

3.2 明星模型解析

-

OpenCoder-8B-Instruct

在 CMD=0.9 时仍保持 39% 的 Pass@1 准确率,秘诀在于其训练数据包含 13% 的代码混合自然语料。 -

Qwen2.5-Coder-1.5B

小体量却表现稳健,得益于 5.5 万亿 token 的多语言代码训练数据。 -

DeepSeek-R1-Distill-Llama-8B

采用代码蒸馏技术,在中等混合程度下性能下降仅 8%。

四、给开发者的实战建议

4.1 模型选择指南

▲ 根据团队需求选择模型的决策流程

4.2 性能优化三要素

-

数据多样性:在训练数据中加入代码混合样本 -

分词器改造:优化对罗马化文本的处理能力 -

指令调优:专门针对混合提示进行微调

五、常见问题解答(FAQ)

Q1:代码混合会影响代码安全性吗?

测试显示,代码混合主要影响自然语言理解部分,生成代码的语法正确性未受显著影响。但需要关注混合提示可能导致的语义误解。

Q2:如何判断团队是否需要关注这个问题?

如果符合以下任一情况:

-

开发团队包含多语言成员 -

产品需要支持区域化特色功能 -

使用开源模型进行二次开发

Q3:现有模型如何快速适配?

分阶段实施方案:

-

在提示工程中加入混合示例 -

对文档注释进行罗马化预处理 -

使用 CodeMixBench 进行兼容性测试

六、未来发展方向

6.1 技术演进路线

| 阶段 | 目标 | 关键技术 |

|---|---|---|

| 短期(1-2年) | 支持更多语言对 | 低资源语言处理技术 |

| 中期 | 混合变量名支持 | 符号-语言联合建模 |

| 长期 | 动态混合适应 | 上下文感知代码生成 |

6.2 行业影响预测

-

开发工具:IDE 插件将集成混合提示自动补全 -

教育领域:编程教学可支持母语-英语混合模式 -

开源社区:多语言代码贡献将更加规范化

结语

CodeMixBench 的测试结果表明:大语言模型需要像开发者一样具备”多语言思维”。当我们在东京用日语-英语调试算法,在圣保罗用葡萄牙语-英语编写文档时,代码生成工具应该成为真正的全球化协作者,而不仅仅是英语世界的”特权工具”。

这项研究为构建真正包容性的编程智能开辟了新方向。下一步,开发者社区需要共同推进:

-

建立多语言代码质量标准 -

完善混合代码的版本管理规范 -

开发自适应混合程度的推理框架

正如 Linux 之父 Linus Torvalds 所说:”好的软件应该适应人的习惯,而不是让人适应软件。” CodeMixBench 的出现,正是这个理念在AI时代的重要实践。

相关资源

#代码生成 #多语言处理 #大语言模型 #软件开发 #人工智能