RLVMR框架:提升长程代理效率的新方法

在人工智能领域,构建能够自主完成复杂长程任务(如家庭环境操作、科学实验)的智能体一直是核心挑战。本文将深入解析腾讯团队提出的RLVMR框架,通过案例和实验数据揭示其如何解决传统强化学习中的低效探索问题。

一、传统方法的困境:为何智能体会”迷路”?

1.1 真实场景中的低效问题

观察一个典型案例:Qwen-7B模型在ALFWorld benchmark中完成”将两个钥匙链放入保险箱”任务时的执行轨迹:

| 步骤 | 观察内容 | 智能体行动 | 问题分析 |

|---|---|---|---|

| 7 | 在梳妆台1发现钥匙链1和2 | 拿起钥匙链1 | 合理 |

| 8 | 已持有钥匙链1 | 再次前往梳妆台1 | 重复无效移动 |

| 9 | 梳妆台1无新发现 | 继续重复动作 | 陷入无效循环 |

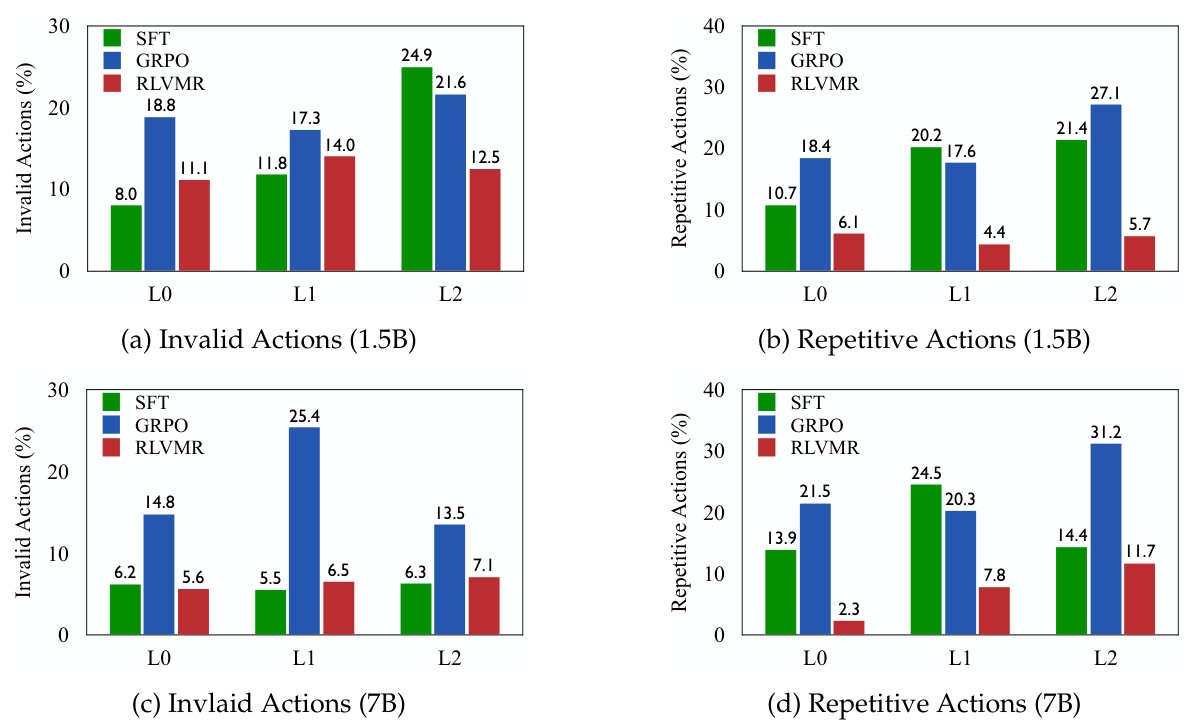

关键问题:传统强化学习(GRPO)虽然能提升任务成功率,但会导致:

-

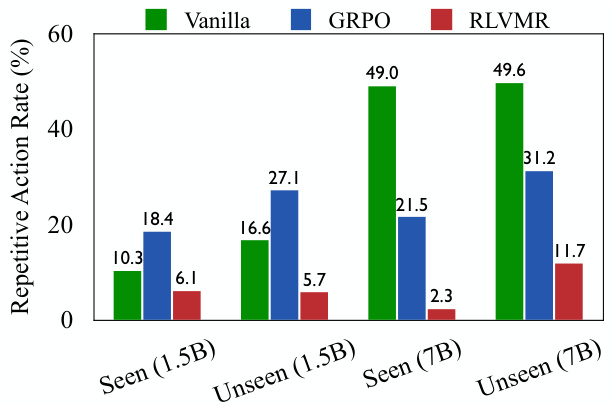

无效动作比例高达31.2%(图1b) -

平均完成步骤增加40%(表2) -

在新任务中表现显著下降

图1b:不同训练方法的重复动作率对比,RLVMR显著降低冗余操作

1.2 根本原因分析

现有训练范式存在根本性矛盾:

-

监督微调(SFT):在已知任务上高效但泛化能力差 -

结果导向强化学习(GRPO):探索能力强但路径低效

就像人类学习时只关注考试分数而忽视解题思路,最终导致知识体系脆弱。

二、RLVMR核心创新:给智能体装上”思维指南针”

2.1 元推理标签系统

RLVMR引入四类结构化思维标签:

| 标签类型 | 作用 | 触发场景示例 |

|---|---|---|

| 任务分解 | 初始阶段制定”先找钥匙再开锁”策略 | |

| 主动探索 | 发现新区域时记录”检查所有抽屉” | |

| 错误反思 | 重复动作后触发”检查已执行步骤” | |

| 进度跟踪 | 常规执行时确认”当前子目标进度” |

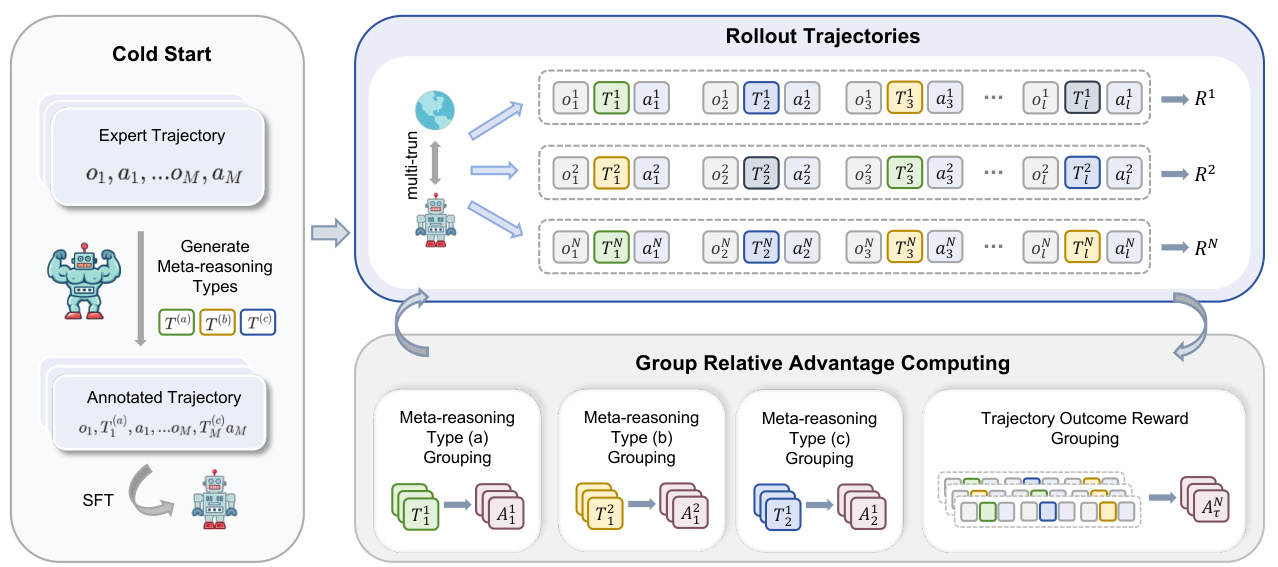

图4:RLVMR框架示意图,展示标签在推理过程中的应用

2.2 双阶段训练流程

冷启动阶段(200条轨迹)

-

使用GPT-4对专家轨迹进行元推理标注 -

监督训练使模型掌握标签语法 # 示例训练数据格式 { "observation": "在梳妆台1发现钥匙链", "meta_reasoning": "<explore>检查其他可能存放钥匙的位置</explore>", "action": "go to drawer 2" }

强化学习阶段

创新性采用**组相对策略优化(GRPO-MR)**算法:

-

同时优化任务完成度(全局奖励)和推理质量(过程奖励) -

通过归一化处理消除不同任务奖励尺度差异

三、实验验证:数据背后的性能飞跃

3.1 核心指标对比

| 模型规模 | 训练方法 | ALFWorld-L2成功率 | ScienceWorld-L2成功率 |

|---|---|---|---|

| Qwen-7B | GRPO | 52.3% | 26.6% |

| Qwen-7B | RLVMR | 83.6% | 32.2% |

| GPT-4o | ReAct | 68.8% | 41.0% |

数据来源:论文Table 1

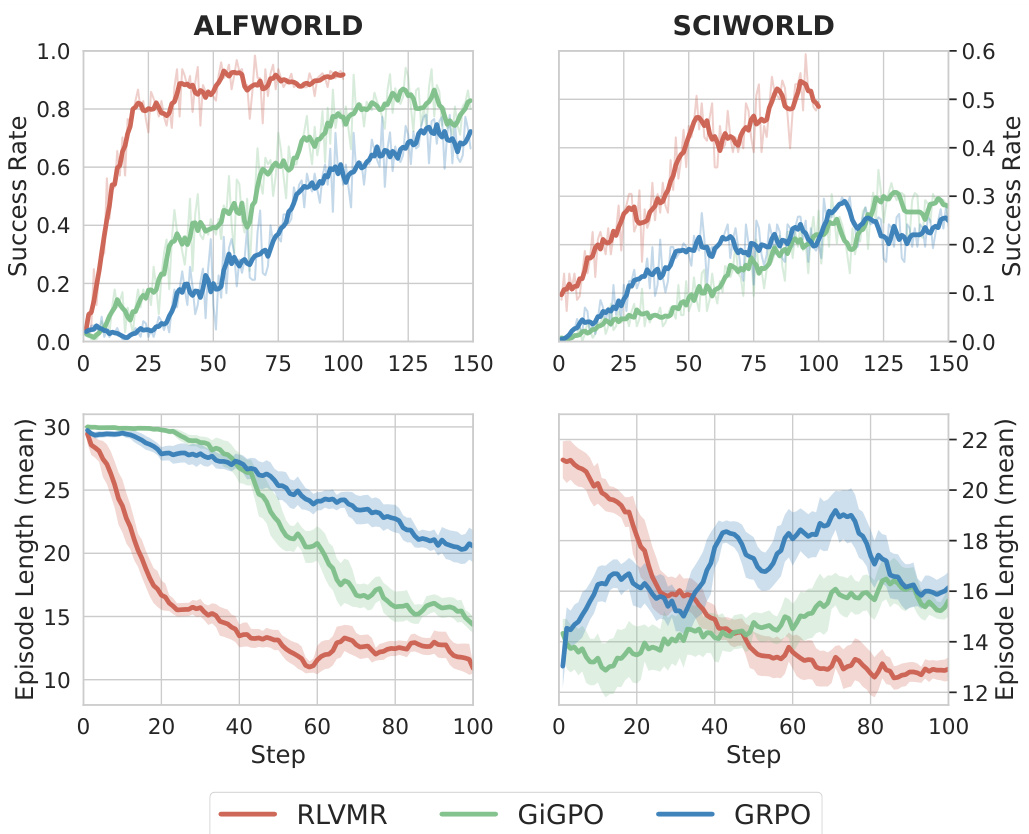

图6:不同方法在训练过程中动作序列长度变化,RLVMR收敛更快

3.2 关键发现

-

小模型超越大模型:1.5B参数模型通过RLVMR训练,在ALFWorld-L2任务上达到56.3%成功率,超越GPT-4o的68.8%基准

-

泛化能力提升:

-

新任务类别(Unseen-L2)成功率提升16.4个百分点 -

重复动作率从31.2%降至2.3%(表2)

-

-

训练稳定性:

-

动作序列长度标准差降低62% -

收敛速度加快40%(图6)

-

四、典型案例解析

4.1 肥皂盒寻找任务

传统GRPO智能体:

Step 13: 在水槽2未发现肥皂 → 重复前往梳妆台1

Step 14: 无效观察 → 继续重复动作

...

陷入6步无效循环

RLVMR智能体:

Step 13: <explore>检查其他可能位置</explore> → 前往厕所

Step 14: <monitor>追踪子目标</monitor> → 检查库存

Step 15: <reflection>反思错误</reflection> → 重新规划路径

...

通过5步有效探索找到目标

图5:RLVMR(左)与GRPO(右)轨迹对比,展示更高效的路径规划

五、技术实现细节

5.1 奖励机制设计

| 奖励类型 | 计算方式 | 示例场景 |

|---|---|---|

| 规划奖励 | 任务成功时触发 | 制定完整计划后+0.5分 |

| 探索奖励 | 访问新状态时触发 | 发现新抽屉+0.3分 |

| 反思奖励 | 修正错误后触发 | 纠正无效动作+0.4分 |

| 格式惩罚 | 输出不符合标签规范时 | 无效标签-0.1分 |

5.2 训练参数

# 关键超参数配置

batch_size: 16

learning_rate: 1e-5

kl_penalty: 0.01

advantage_weight: 0.5

max_steps_per_episode: 30

六、未来展望

RLVMR框架为智能体发展开辟新方向:

-

多模态扩展:结合视觉-语言-动作(VLA)模型 -

自适应奖励机制:根据任务类型动态调整奖励权重 -

现实世界应用:机器人控制、工业流程优化等场景

常见问题解答(FAQ)

Q1: RLVMR需要多少训练数据?

仅需200条专家轨迹进行冷启动,后续通过环境交互学习。

Q2: 是否适用于其他大模型?

验证了Qwen和GPT系列兼容性,理论上支持任何支持ReAct框架的模型。

Q3: 部署复杂度如何?

使用veRL框架实现,代码已开源在GitHub/Tencent/DigitalHuman。

Q4: 如何验证推理质量?

通过无效动作率、路径长度等客观指标量化。

Q5: 是否支持多任务学习?

论文实验涵盖30+类科学实验和家居任务,证明良好泛化性。

总结

RLVMR通过结构化元推理标签和过程导向奖励机制,显著提升了长程智能体的鲁棒性和效率。这种”授人以渔”的方法论,为AI系统从”知其然”到”知其所以然”的进化提供了可行路径。