GLM-5 与 Kimi K2.5 深度对比:中国开源大模型的双重路径与硬件突围

本文欲回答的核心问题:在同样源自中国、同样开源且发布时间相近的背景下,GLM-5 与 Kimi K2.5 在架构设计、智能体能力、成本效益及硬件独立性上究竟有何本质不同,开发者与企业应如何抉择?

仅仅两周的时间差,两款开源前沿大模型相继问世。它们都来自中国,都采用 MIT 协议,却在技术路径上做出了截然不同的选择。这不仅仅是一次产品的发布,更像是一场关于 AI 未来走向的对照实验:一条路通向深度推理与硬件主权,另一条路则指向多模态协作与智能体集群。

我花了一整天时间,深入研究了它们的规格、基准测试、架构细节以及定价策略。如果你正在为下一个项目选择基座模型,或者关注全球 AI 算力格局的变化,这篇文章将为你提供详实的决策依据。

基础规格:参数背后的博弈

核心问题:两款模型在基础参数配置上有何差异,这如何影响了它们的第一印象?

首先,我们需要建立一个基本的认知框架。GLM-5 由智谱 AI 推出,这是一家从清华大学分拆出来的企业,最近在香港上市并筹集了 5.58 亿美元。其模型拥有 7450 亿参数,每个 token 激活 440 亿参数,上下文窗口为 200K。

相比之下,Kimi K2.5 来自北京的月之暗面。它的参数量达到了 1 万亿,每个 token 激活 320 亿参数,上下文窗口略大,为 256K。最显著的区别在于,Kimi K2.5 是原生的多模态模型,它不仅能处理文本,还能直接理解图像和视频。

为了更直观地对比,我们可以参考以下“记分卡”概览:

两者都采用了混合专家架构,且都是开放权重。乍看之下相似度极高,但这只是表面现象。正如我们将要看到的,它们在专家数量的选择、激活参数的比例以及多模态处理方式上,埋下了完全不同的伏笔。

架构选择:手术刀与瑞士军刀

核心问题:不同的 MoE 架构设计决策,如何决定了模型擅长的任务类型?

深入底层架构,我们发现两者虽然都采用了混合专家模型技术,但设计哲学迥异。这直接决定了它们在实际应用中的“手感”。

GLM-5 选择了一条“少而精”的路线。它激活的参数量更多(440 亿 vs 320 亿),专家数量较少,但每一位“专家”都承担了更重的负荷。这种设计带来的直接收益是处理结构化、序列化任务时的稳健性。具体来说,它在代码生成、逐步推理以及需要长程一致性的智能体会话中表现出色。想象一下,你正在进行一场长达数小时的编程结对,GLM-5 就像一把锋利的手术刀,精准且不手抖。

反观 Kimi K2.5,它将智能分散到了 384 位专家手中(GLM-5 为 256 位)。为了弥补单次激活参数较少可能带来的感知缺失,它配备了一个专用的 4 亿参数视觉编码器——MoonViT。值得注意的是,Kimi 并非在后期“缝合”了视觉能力,而是从第一天起就用 15 万亿个混合视觉和文本 token 进行训练。视觉对它而言,是母语而非第二语言。

这种差异在实际落地时表现得尤为明显。如果你在构建一个需要深度逻辑推理的代码助手,GLM-5 的架构优势会让它更加可靠;但如果你需要一个能看懂 UI 设计图并生成代码,或者分析视频内容的全能助手,Kimi K2.5 这把“瑞士军刀”显然更合适。

基准测试:理性看待数据

核心问题:在缺乏完全独立验证的情况下,我们如何解读两款模型的性能数据?

这里需要插入一个巨大的星号。GLM-5 是今天刚发布的,独立的第三方基准测试还在路上,目前的数据多来自智谱 AI 的新闻材料或基于前代模型 GLM-4.7 的推算。而 Kimi K2.5 已经有了两周的社区测试期,数据相对扎实。

即便如此,我们依然可以梳理出一些关键线索:

-

SWE-bench Verified(编程能力): Kimi 达到了 76.8%,表现优异。GLM-5 基于前代 73.8% 的轨迹,预计在 76% 左右。两者在代码能力上可谓旗鼓相当。 -

HLE with tools(推理能力): Kimi 得分 50.2%,而 GLM-4.7 为 42.8%。GLM-5 预计会有所提升,但目前具体数据仍是空白。 -

BrowseComp(网络智能体): Kimi 得分 74.9%,这主要归功于其“智能体集群”技术。GLM-5 的相关数据尚待公布。 -

AIME 2025(数学能力): 两者基本持平。Kimi 为 96.1%,GLM-4.7 为 95.7%,预计 GLM-5 会匹配或略微胜出。

路透社报道称,GLM-5 在编程基准测试中接近 Claude Opus 4.5,并在部分测试中超越了 Gemini 3 Pro。虽然这些说法听起来令人振奋,但我建议大家等待未来一两周内社区发布的独立测评结果。在这个数据即真理的领域,保持谨慎的乐观总是没错的。

智能体分流:广度与深度的抉择

核心问题:两款模型在智能体构建上的不同策略,如何影响复杂任务的执行效率?

这是两款模型最本质的分野所在,也是开发者在选型时最需要斟酌的地方。

Kimi K2.5 的杀手锏是“智能体集群”。它可以协调多达 100 个 AI 子智能体并行工作,支持高达 1500 次工具调用。这种能力源于其“并行智能体强化学习”训练机制。在实际测试中,这种并行处理将执行时间缩短了 4.5 倍。

应用场景示例:

想象你有一个复杂的市场调研任务。你只需给 Kimi 一个指令,它会瞬间启动一个专家组:一个研究员负责搜集数据,一个核查员负责验证事实,一个分析师负责整理报表。它们同时工作,互不干扰。这种模式非常适合广度搜索和批量内容生成。不过,早期测试者也发现,由于多个智能体并行工作,有时在组装电子表格列时会使用略微不同的定义,协调机制仍有进化空间。

GLM-5 则选择了另一条路:“深度优先”。它继承了 GLM-4.7 的“保留思考”技术。简单来说,它能在多轮对话中保留推理块,而不是每次都从头推导。

应用场景示例:

如果你曾经历过在长程编程会话的第 50 轮对话时,AI 突然“失忆”或逻辑崩塌,你就会明白 GLM-5 的价值。它专门为解决长程一致性而生。它不追求启动百个分身,而是追求本体在超长交互中保持清醒。

总结来说:如果你需要构建大规模的智能体集群来并行处理复杂任务,Kimi 是首选;如果你需要构建一个能在长交互中保持逻辑连贯的单一智能体,GLM-5 则是更稳妥的选择。

成本分析:不仅是单价问题

核心问题:除了每百万 token 的标价,还有哪些隐性成本因素影响了模型的性价比?

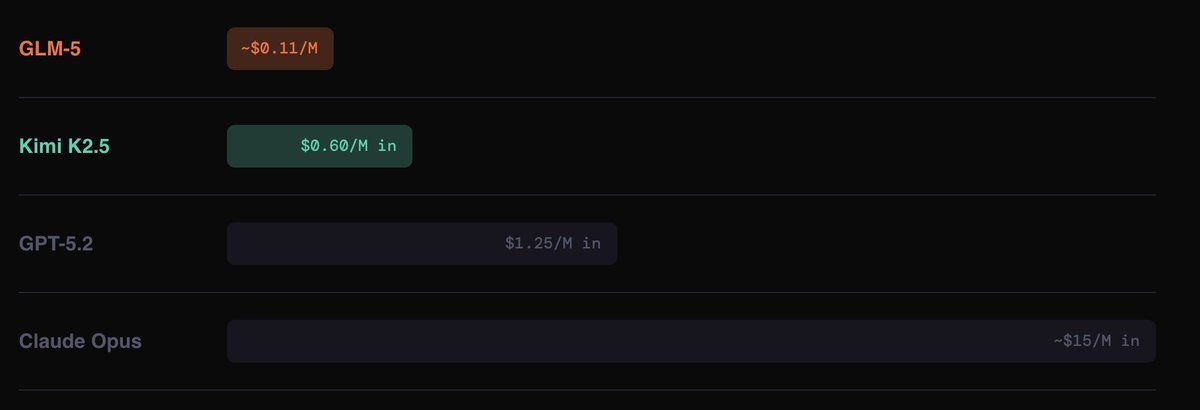

这一部分的数据令人咋舌。GLM-5 的定价约为每百万 token 0.11 美元;Kimi K2.5 为输入 0.60 美元/M,输出 2.50-3.00 美元/M。作为对比,GPT-5.2 输入约 1.25 美元/M,Claude Opus 高达约 15 美元/M。

乍一看,GLM-5 在输入端比 Kimi 便宜 5 倍,比 GPT-5 便宜 11 倍,比 Opus 便宜 100 多倍。这简直是降维打击。但作为技术决策者,我们不能只看标价,还要看“总拥有成本”。

这里有两个关键变量需要权衡:

-

速度与迭代成本: GLM-5 虽然单价低,但速度较慢(17-19 tok/sec),而 Kimi 速度较快(39 tok/sec)。在多步骤编码任务的迭代循环中,Kimi 往往能更快收敛。这意味着虽然 Kimi 单次 token 贵,但因为迭代次数少、速度快,实际完成任务的总时间成本可能更低。 -

输出冗余度: Kimi 的输出风格较为冗长。独立分析显示,在其智能指数评估中,Kimi 消耗了 8900 万 token,是同类模型的 2.5 倍。这意味着如果任务涉及大量的单次生成(如长报告、长草稿),Kimi 的冗长特性会推高实际成本,此时 GLM-5 的低价优势将得到最大化释放。

因此,结论很清晰:对于高体量 API 调用和单次生成任务,GLM-5 赢在成本;对于需要快速迭代、追求时效性的智能体循环,Kimi 的高效推理可能抵消其单价劣势。

芯片突围:地缘政治下的技术主权

核心问题:GLM-5 的训练过程证明了什么关于硬件独立性的关键事实?

这一部分的意义远远超出了 AI 基准测试的范畴,触及了全球科技竞争的核心。

GLM-5 完全在华为昇腾芯片上训练,使用的是 MindSpore 框架。动用了 10 万张芯片,其中没有任何 NVIDIA 硬件的参与。这一点至关重要,因为智谱 AI 在 2025 年 1 月被列入美国实体清单,被切断了获取 NVIDIA H100 和 H200 芯片以及美国云推理服务的途径。

出口管制的初衷是遏制,但结果却催生了另一种可能:智谱 AI 建立了一个 10 万张芯片的国产集群,并在其上训练出了 7450 亿参数的前沿模型。路透社评价其代码能力接近 Claude Opus。无论你对出口管制持何种政治立场,这一数据点都是不可否认的:大规模前沿模型的硬件独立性与可行性,已从理论假设转变为既定事实。

相比之下,Kimi K2.5 很可能是在标准的 NVIDIA 硬件上训练的。月之暗面的赌注押在了模型架构创新和智能体能力上,而非硬件主权。这代表了两种不同的优先级:一种寻求全栈可控,另一种则追求在现有算力基础上最大化算法红利。

选型指南:谁该用什么?

核心问题:针对不同的业务需求和技术栈,开发者应如何在两者间做出选择?

基于以上分析,我们可以画出清晰的决策边界。

选择 GLM-5,如果:

-

你对成本极度敏感,需要进行大规模 API 调用。 -

你的任务涉及结构化编码和深度推理,特别是需要长输出(其最大输出达 131K,行业领先)。 -

你关注硬件独立性,或者你的项目对供应链安全有特殊要求(如需规避美国供应链风险)。 -

你需要构建一个在长程对话中保持高度一致性的单一智能体。

选择 Kimi K2.5,如果:

-

你需要多智能体并行执行复杂任务(如大规模调研、批量内容生产)。 -

你的应用场景涉及视觉输入,如截图生成代码、视频理解等。 -

你更看重推理速度,且迭代效率比单 token 成本更重要。 -

你需要目前最大的上下文窗口(256K),且希望使用经过两周社区验证的、更成熟的模型。

两者都是开源权重,都可以本地运行,也都支持与主流编码环境集成。这并非优劣之分,而是场景之别。

作者反思:技术分岔路口的思考

在整理这些数据时,我最深刻的感受是“殊途同归”的多元化。过去我们评价模型,往往只看一个维度的“智能程度”。但 GLM-5 和 Kimi K2.5 展示了行业成熟的标志:工具开始分化。

GLM-5 给我留下了“硬核”的印象。在没有任何 NVIDIA 高端芯片支持的情况下,利用国产算力底座跑通了前沿大模型的全流程,这本身就是一个巨大的工程奇迹。它证明了算力封锁或许能延缓购买,但无法阻止创造。对于关注基础设施自主化的开发者来说,这是一个极其重要的信号。

而 Kimi K2.5 则展示了另一种未来图景——AI 不再是单打独斗的超级大脑,而是像蜂群一样协作的系统。虽然目前的协作还有瑕疵(如定义不一致),但它指明了从“模型”到“系统”的进化方向。

这让我意识到,未来的模型选型,不再只是选一个“最聪明的大脑”,而是在选一种“工作方式”。是选一个能独当一面的深度思考者,还是选一个能调兵遣将的项目经理?这取决于你要解决的问题是单一的深井,还是复杂的网络。

实用摘要与操作清单

为了方便快速落地,我总结了以下核心要点:

操作清单:

-

成本测试: 不要只看标价。用你的典型任务跑一次 GLM-5 和 Kimi,计算达到满意结果所需的总 token 消耗和时间成本。 -

长程测试: 如果你的应用涉及多轮对话,务必测试 GLM-5 的“保留思考”功能,看其在第 20 轮对话后的逻辑保持能力。 -

视觉验证: 如果涉及图像处理,直接选用 Kimi K2.5,测试其 MoonViT 编码器对你特定领域图片的理解力。 -

合规审查: 如果你的业务涉及敏感数据或特定合规要求,GLM-5 的国产算力背景可能是一个加分项。

一页速览

-

两大路径: GLM-5 侧重深度推理与成本控制(手术刀),Kimi K2.5 侧重多模态与集群协作(瑞士军刀)。 -

算力突围: GLM-5 证明了完全脱离 NVIDIA 硬件训练前沿大模型的可行性。 -

智能体差异: Kimi 主打多智能体并行,GLM-5 主打单体长程一致性。 -

成本真相: GLM-5 单价极低,适合生成;Kimi 速度快,适合迭代,但需注意冗长带来的隐形成本。 -

选型建议: 关注成本与供应链选 GLM-5;关注视觉与复杂任务调度选 Kimi K2.5。

常见问答 (FAQ)

1. GLM-5 和 Kimi K2.5 哪个更便宜?

从单价看,GLM-5 远低于 Kimi K2.5。但如果考虑到 Kimi 推理速度快、可能减少迭代次数,而 GLM-5 生成速度较慢,实际任务总成本需根据具体场景测试计算。

2. 这两款模型都能处理图像吗?

Kimi K2.5 具备原生多模态能力,能自然处理图像和视频。GLM-5 主要侧重于文本和代码,其架构设计并未将视觉作为原生核心。

3. GLM-5 完全不使用 NVIDIA 芯片吗?

根据文档,GLM-5 完全在华为昇腾芯片上训练,未使用任何 NVIDIA 硬件,展示了硬件独立性。

4. 哪个模型更适合写代码?

两者在编程基准测试中表现接近。GLM-5 擅长长会话中的代码推理,不易“失忆”;Kimi K2.5 则在多文件并行处理和快速迭代上可能有优势。

5. 什么是 Kimi 的“智能体集群”?

指 Kimi 能同时调度多达 100 个子智能体并行工作,如同一个团队协作,适合处理复杂的调研和生成任务。

6. GLM-5 的“保留思考”有什么用?

它能让模型在多轮对话中记住之前的推理过程,避免重复推导,非常适合需要长期记忆和连贯逻辑的长任务。

7. 这两款模型是开源的吗?

是的,两者都采用了 MIT 协议,开放权重,支持本地部署。

8. 目前 GLM-5 的基准测试数据可靠吗?

目前 GLM-5 的部分数据来自厂商宣传或前代模型推算,独立的第三方社区测试结果预计在未来 1-2 周内发布,建议关注后续验证。