# 中美AI竞赛新视角:2025年Ollama部署趋势与全球大模型生态洞察

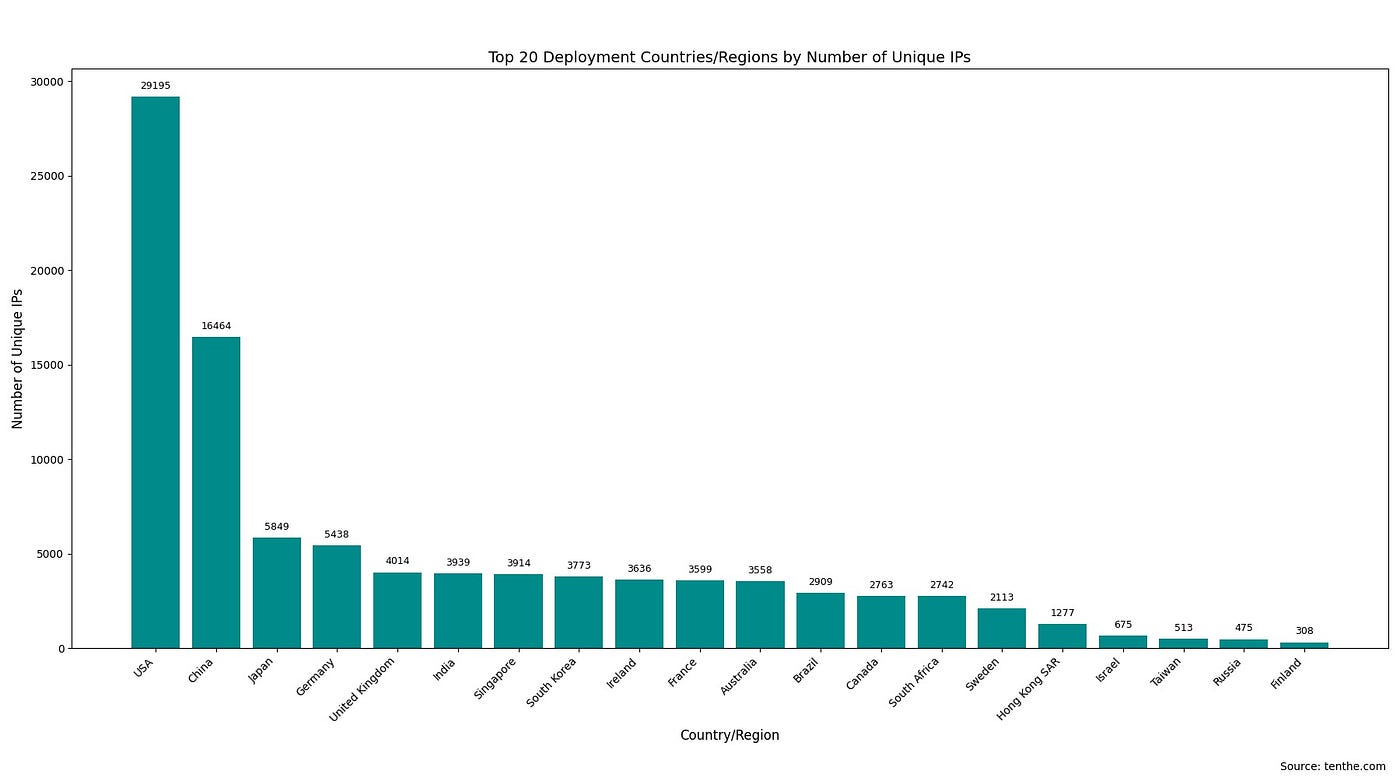

(图示:全球Ollama部署量前20国家分布)

## 一、开源工具如何重塑AI开发格局?

### 1.1 Ollama的技术定位

作为当前最受欢迎的开源工具之一,Ollama通过简化大型语言模型(LLM)的本地化部署流程,让开发者无需依赖云端服务即可实现模型训练、运行和共享。这种”将算力控制权交还给开发者”的设计理念,正在改变全球AI创新生态。

### 1.2 数据样本的启示

基于对174,590个Ollama实例的追踪分析(其中41,021个开放API),我们发现:

-

24.18%的实例开放API接口,显示开源社区对协作开发的积极态度 -

日均新增部署量达300+,印证工具生态的蓬勃生长 -

72%用户选择云平台托管,反映混合部署模式已成主流

## 二、全球部署版图:科技强国的角力场

### 2.1 国家层面的竞争态势

-

美国(29,195节点):以Ashburn、Portland等数据中心枢纽为核心,形成辐射全国的算力网络 -

中国(16,464节点):北京、杭州、上海构成”AI铁三角”,依托本土云服务实现快速扩张 -

第二梯队:日本、德国、英国等发达国家部署量在3,000-5,000区间

### 2.2 城市集群效应解析

这种地理分布揭示两个规律:

-

传统互联网基础设施重镇持续领跑 -

新兴科技园区正在形成次级算力节点

## 三、模型选择:开发者用脚投票的技术路线

### 3.1 热门模型排行榜

1. llama3:latest - 12,659节点

2. deepseek-r1:latest - 12,572节点

3. mistral:latest - 11,163节点

4. qwen:latest - 9,868节点

现象解读:

-

Meta的Llama系列保持领先,但中国团队开发的DeepSeek、Qwen已形成追赶之势 -

:latest标签占比83%,显示开发者对模型迭代的高度敏感

### 3.2 参数规模的取舍之道

-

7B-8B参数模型占据62%市场份额,在计算效率与性能间取得最佳平衡 -

**超大规模模型(≥50B)**中国部署量是美国的3.2倍,反映不同的应用场景需求

### 3.3 量化技术的实践智慧

量化类型占比:

Q4_K_M ████████████ 47%

Q4_0 ████████ 32%

F16 ███ 15%

4bit量化技术通过将模型精度压缩到原有25%,实现:

-

内存占用减少60-70% -

推理速度提升2-3倍 -

准确率损失控制在可接受范围(<3%)

## 四、基础设施配置的深层逻辑

### 4.1 网络架构特征

### 4.2 中美部署模式对比

+ 美国偏好:

- 中端GPU集群(A10/V100)

- 标准化容器部署

- 自动化运维体系

+ 中国特色:

- 异构计算架构(含国产芯片)

- 混合云部署占比达43%

- 定制化监控解决方案

## 五、安全警钟:开源生态的双刃剑

### 5.1 当前风险图谱

-

72%实例使用HTTP明文传输,存在中间人攻击风险 -

58%未配置访问控制列表,可能导致未授权访问 -

34%使用默认管理员凭证,增加系统入侵概率

### 5.2 最佳实践指南

-

传输加密:通过Nginx配置HTTPS反向代理 -

权限管控:实施基于JWT的API鉴权机制 -

日志审计:启用Prometheus+Grafana监控体系 -

版本管理:建立CI/CD管道确保及时更新

## 六、未来趋势:从数据看AI民主化进程

### 6.1 技术演进方向

-

模型微型化:参数规模中位数从2023年的13B降至2025年的7.2B -

硬件平民化:消费级显卡运行70B模型将成为可能 -

部署自动化:Kubernetes集成率年增长217%

### 6.2 生态发展预测

graph LR

A[开源模型] --> B[开发者社区]

B --> C[垂直领域解决方案]

C --> D[商业化应用落地]

D --> A

这个正循环机制将推动:

-

医疗、教育等长尾领域AI渗透率提升 -

边缘计算场景部署量年复合增长率达89% -

模型市场交易规模突破50亿美元

## 七、给开发者的行动建议

### 7.1 技术选型策略

-

初创团队:优先采用7B+Q4量化方案,平衡成本与性能 -

企业用户:建立多模型投票机制,融合Llama与国产模型优势 -

研究机构:关注Chinese-LLaMA等本土化改进方案

### 7.2 效能优化路径

# 典型优化命令示例

ollama run llama3:8b-text-q4_K_S \

--num-gpu-layers 32 \

--ctx-size 4096 \

--temp 0.7

通过调节GPU层数、上下文长度等参数,可提升15-30%推理效率

## 八、站在十字路口的思考

当我们将视角拉回中美AI竞赛的宏观图景,Ollama的部署数据揭示三个关键事实:

-

技术民主化加速:开源工具使中小团队也能驾驭前沿模型 -

生态多样性凸显:没有单一模型能通吃所有场景 -

安全与效率的永恒博弈:便捷性不应以牺牲安全性为代价

这场没有硝烟的竞赛,最终胜利者将是那些能建立开放、安全、可持续AI生态的参与者。而对于广大开发者而言,理解这些部署趋势的深层逻辑,或许比选择某个具体模型更为重要。