Yan 框架:重新定义实时交互式视频生成的未来

一、什么是 Yan 框架?

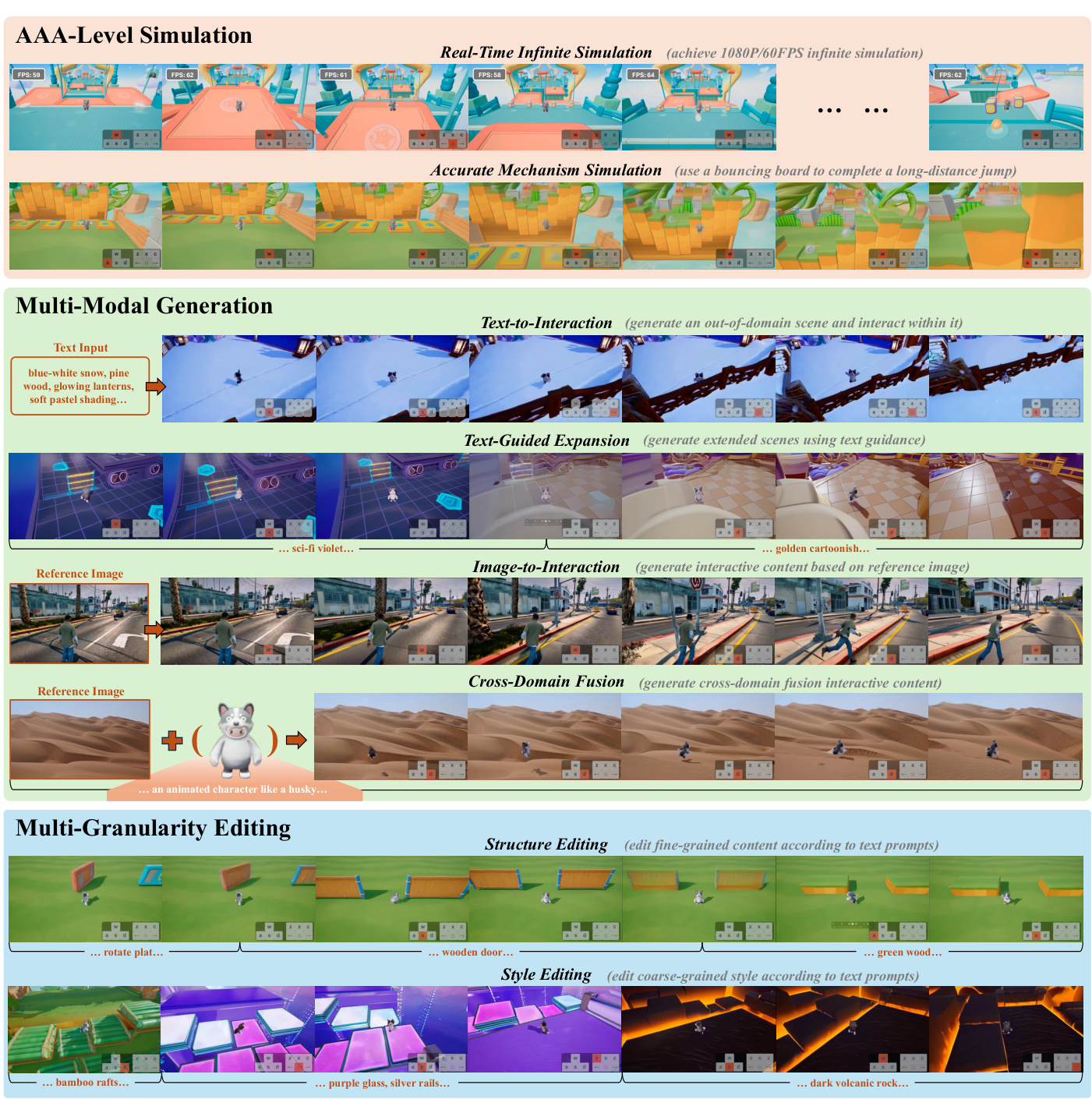

Yan 是由腾讯团队开发的交互式视频生成基础框架,它突破了传统视频生成技术的局限,将 AAA 级游戏画质、实时物理模拟与多模态内容创作融为一体。通过整合三大核心模块(高保真模拟、多模态生成、多粒度编辑),Yan 首次实现了「输入指令→实时生成→动态编辑」的完整交互式视频创作流程。

关键突破:在 1080P/60FPS 条件下实现实时互动生成,支持跨域风格融合与物理机制精确模拟。

二、为什么需要这样的技术?

传统视频生成面临三大痛点:

| 痛点 | 传统方案局限 | Yan 的解决方案 |

|---|---|---|

| 实时性 | 20-30FPS 低帧率,交互延迟高 | 1080P/60FPS 实时渲染 |

| 内容可控性 | 固定内容生成,难以动态修改 | 支持帧级动作控制与实时提示词修改 |

| 物理真实性 | 简化物理引擎,难以模拟复杂机制 | 精确复现游戏级物理交互(如惯性、碰撞) |

三、Yan 的三大核心模块

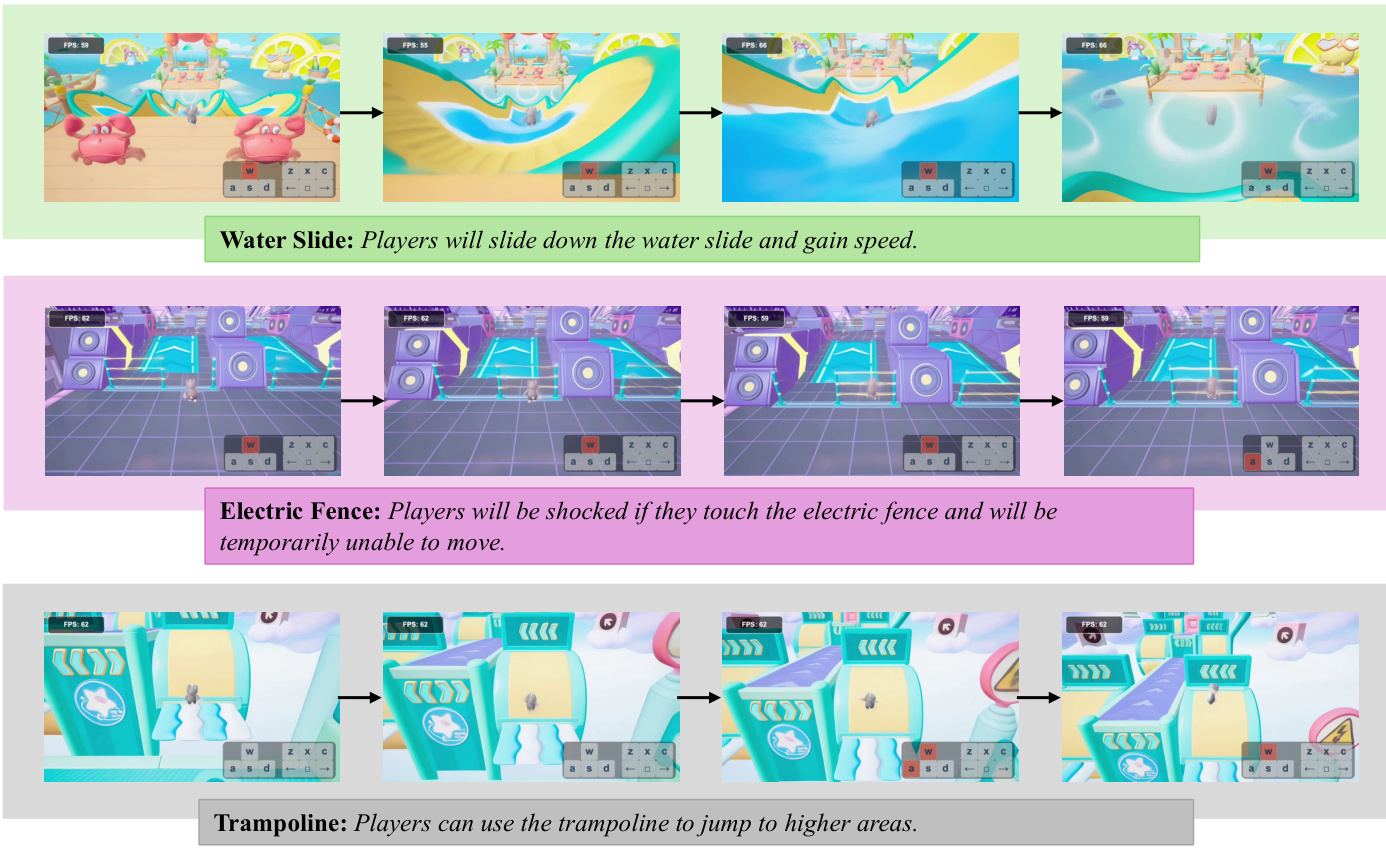

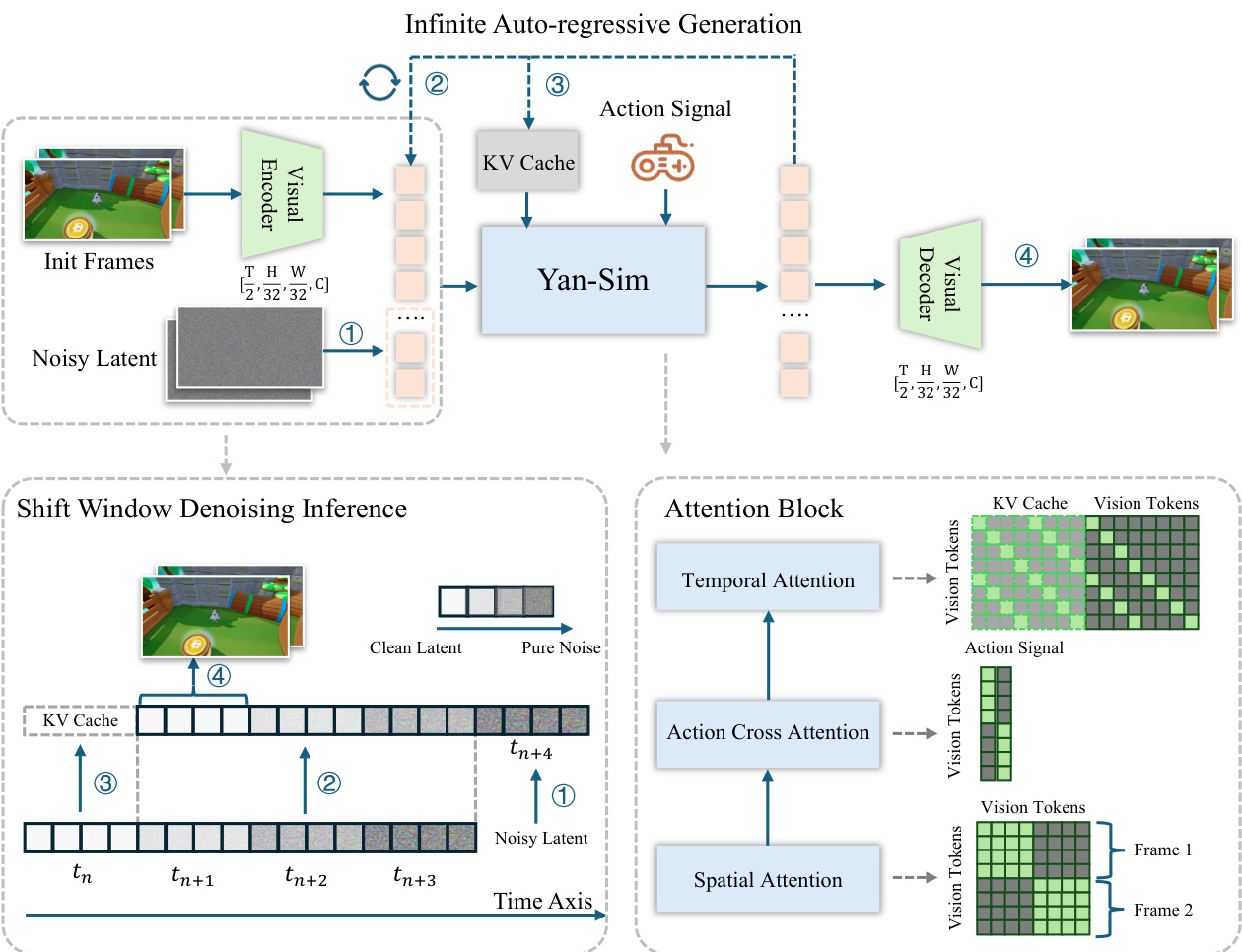

1. AAA 级模拟模块(Yan-Sim)

技术亮点

-

超压缩 VAE 编码器

将图像空间分辨率压缩 32 倍(传统方案仅 8 倍),配合通道维度扩展(16 通道→256 通道),实现高保真隐空间表达。 -

移窗去噪推理

通过滑动窗口机制并行处理多帧数据,结合 KV 缓存技术减少重复计算,单帧生成延迟低至 0.07 秒。

效果对比

| 指标 | The Matrix | PlayGen | Yan-Sim |

|---|---|---|---|

| 分辨率 | 720P | 128P | 1080P |

| 帧率 | 16FPS | 20FPS | 60FPS |

| 物理模拟精度 | 低 | 中 | 高 |

2. 多模态生成模块(Yan-Gen)

创新设计

-

分层式视频描述系统

-

全局描述:定义静态世界观(如” medieval castle with Gothic architecture”) -

局部描述:动态事件细节(如” character jumps over wooden fence with momentum”)

-

-

动作控制交叉注意力

动作指令通过专用编码器注入每个扩散块,实现帧级动作响应(如按左键→角色左转)。

生成效果

案例:输入”奔跑穿过雪地并跳过栏杆”,模型生成包含:

✅ 角色惯性运动 ✅ 雪地材质反馈 ✅ 栏杆碰撞检测

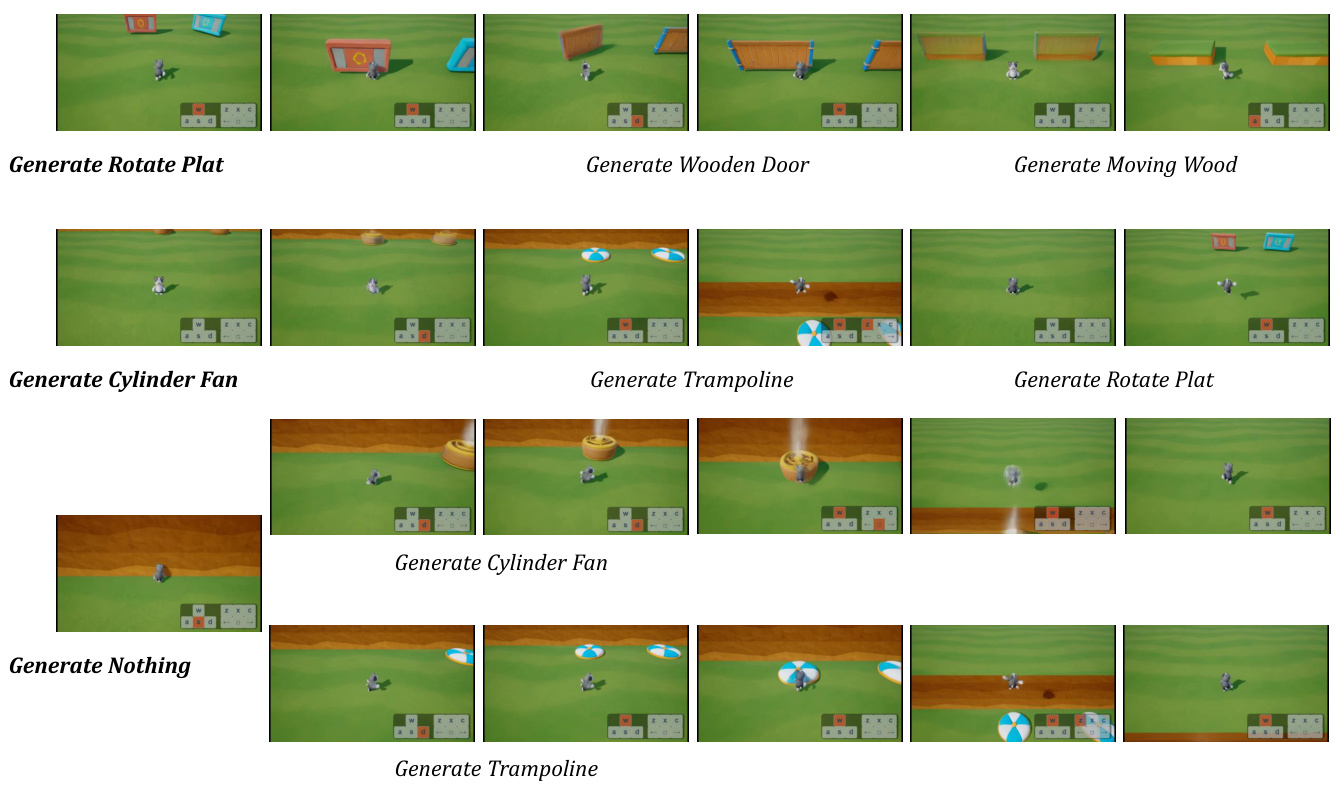

3. 多粒度编辑模块(Yan-Edit)

核心思想

将交互机制模拟与视觉渲染解耦:

-

机制模拟层

基于深度图学习结构依赖的物理规则(如门需要钥匙才能打开) -

视觉渲染层

通过 ControlNet 将深度图渲染为任意风格(如下午茶风格→赛博朋克风格)

编辑类型

| 编辑粒度 | 可修改内容 | 典型应用场景 |

|---|---|---|

| 粗粒度 | 添加/删除场景元素(如门、梯子) | 快速关卡设计 |

| 细粒度 | 修改材质/光照/纹理 | 美术风格迭代 |

案例:将”旋转平台”改为”木门”,角色可正常与新物体交互

四、如何构建训练数据?

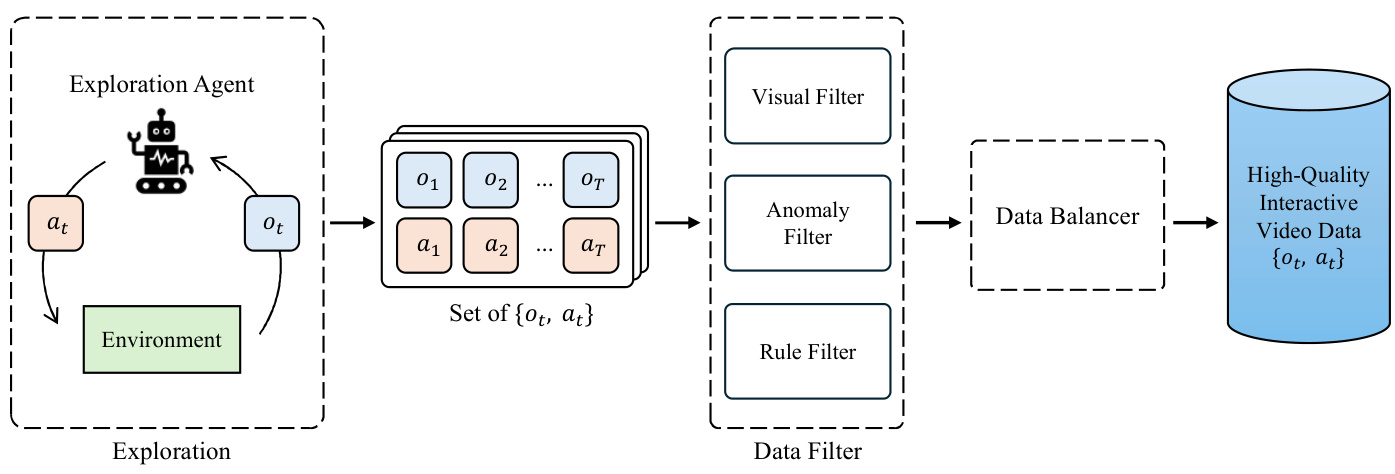

数据收集流程

-

智能体探索

-

随机动作 + PPO 强化学习结合 -

覆盖 90+ 不同场景

-

-

数据清洗

-

视觉过滤器:剔除低方差图像(遮挡/渲染失败) -

异常过滤器:移除卡顿视频段 -

规则过滤器:排除违反游戏机制的数据

-

-

平衡采样

按坐标分布、碰撞状态等属性均衡采样

数据规模

| 指标 | 数值 |

|---|---|

| 总帧数 | 4亿帧 |

| 分辨率 | 1080P |

| 帧率 | 30FPS |

| 场景类型 | 90+种 |

五、技术实现细节

1. 模型训练流程

阶段 1:VAE 训练

# 输入:连续两帧拼接 (H=1024, W=1792, C=6)

# 输出:隐空间表示 (h=32, w=56, C=16)

encoder = nn.Sequential(

DownBlock1(),

DownBlock2(), # 空间压缩比从8→32

ChannelExpand() # 通道维度扩展

)

阶段 2:扩散模型训练

-

扩散强制策略:对每个帧独立加噪,模拟推理过程 -

因果注意力机制:仅允许当前帧关注历史帧

2. 实时推理优化

| 优化技术 | 效果 |

|---|---|

| FP8 量化 | 1.5-2倍速度提升 |

| CUDA图捕获 | 消除内核启动开销 |

| 模型并行部署 | 跨GPU流水线处理 |

六、典型应用场景

1. 游戏开发

-

快速原型验证:设计师输入文本描述→实时生成可交互场景 -

动态内容生成:玩家输入”火山爆发”,场景即时响应

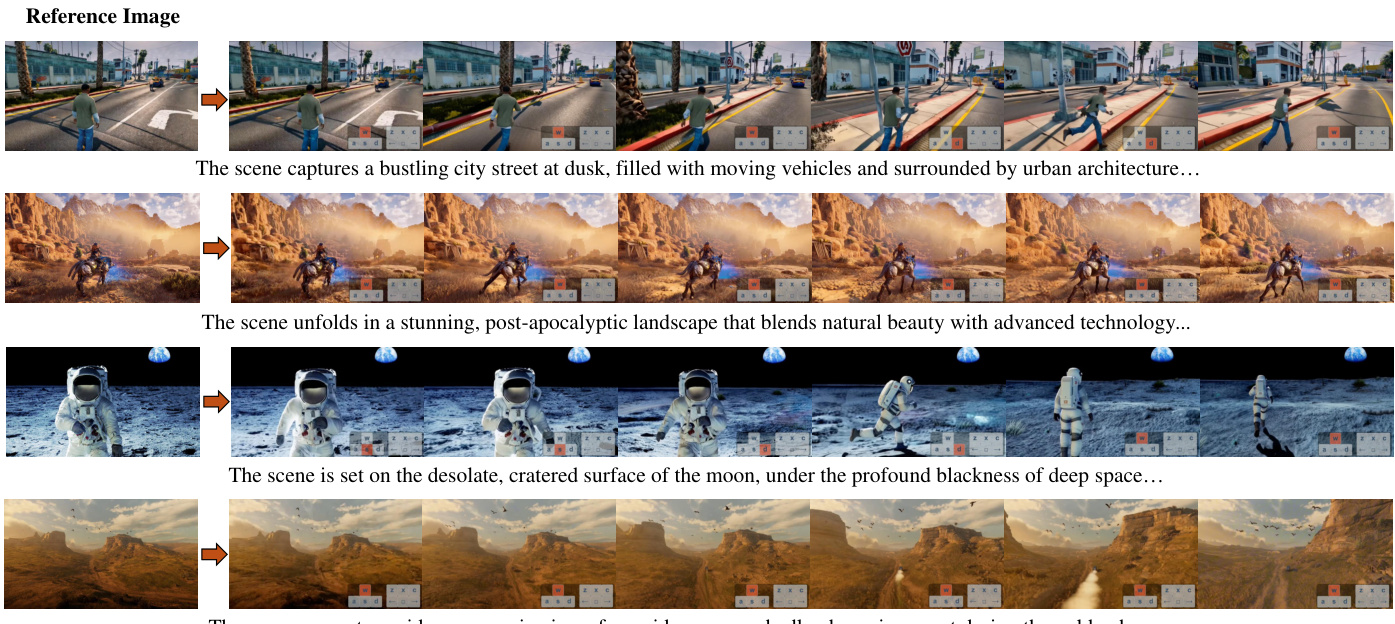

2. 虚拟制片

-

虚拟场景扩展:输入参考图→生成连续可探索环境 -

跨域融合:将现实场景照片与游戏角色实时合成

七、常见问题解答

Q1: Yan 与传统游戏引擎的区别?

A: Yan 是生成式模拟系统,区别于传统引擎的预制逻辑:

-

不需要手动编写碰撞检测代码 -

支持自由修改场景元素并保持物理一致性 -

可生成训练数据反哺强化学习

Q2: 如何保证长视频一致性?

A: 采用分层式描述系统:

-

全局描述锚定世界观(不变) -

局部描述动态更新(可变)

Q3: 需要哪些硬件支持?

A: 推理配置:

-

单卡 NVIDIA H20:12-17FPS -

4卡 NVIDIA H20:30FPS

八、技术局限性

-

长时一致性挑战:复杂交互场景易出现时空不一致 -

硬件依赖性强:需高端 GPU 实现实时性能 -

动作空间限制:当前基于游戏引擎动作集 -

编辑依赖文本描述:需改进自然语言接口

九、未来展望

-

模型轻量化:开发边缘设备友好版本 -

跨域扩展:将游戏场景生成能力迁移到现实世界 -

多模态输入增强:支持语音、手势等控制方式

“Yan 为下一代 AI 内容引擎指明了方向” —— 腾讯研究院

十、延伸阅读

-

项目官网 -

Qwen2.5-VL 技术报告 -

[Rectified Flows 原理](https:// proceedings.neurips.cc/paper/2024/hash/…)