RecGPT:基于大语言模型的新一代推荐系统技术解析

一、传统推荐系统的困境与LLM带来的变革

在电商平台每天数亿级的用户行为日志中,推荐系统需要从点击、加购、收藏等碎片化行为中,精准捕捉用户真实意图。传统推荐系统主要依赖历史行为统计规律,存在两大核心痛点:

-

行为过拟合:过度依赖历史点击模式,导致推荐内容同质化

-

用户A浏览过3次咖啡机→持续推荐同类咖啡机 -

忽视用户潜在需求(如咖啡豆、磨豆器等关联商品)

-

-

长尾效应:头部商品占据80%曝光,尾部商品难以突围

-

小众设计师品牌商品曝光率不足0.3% -

新品上架后7天平均曝光量仅为成熟商品的1/5

-

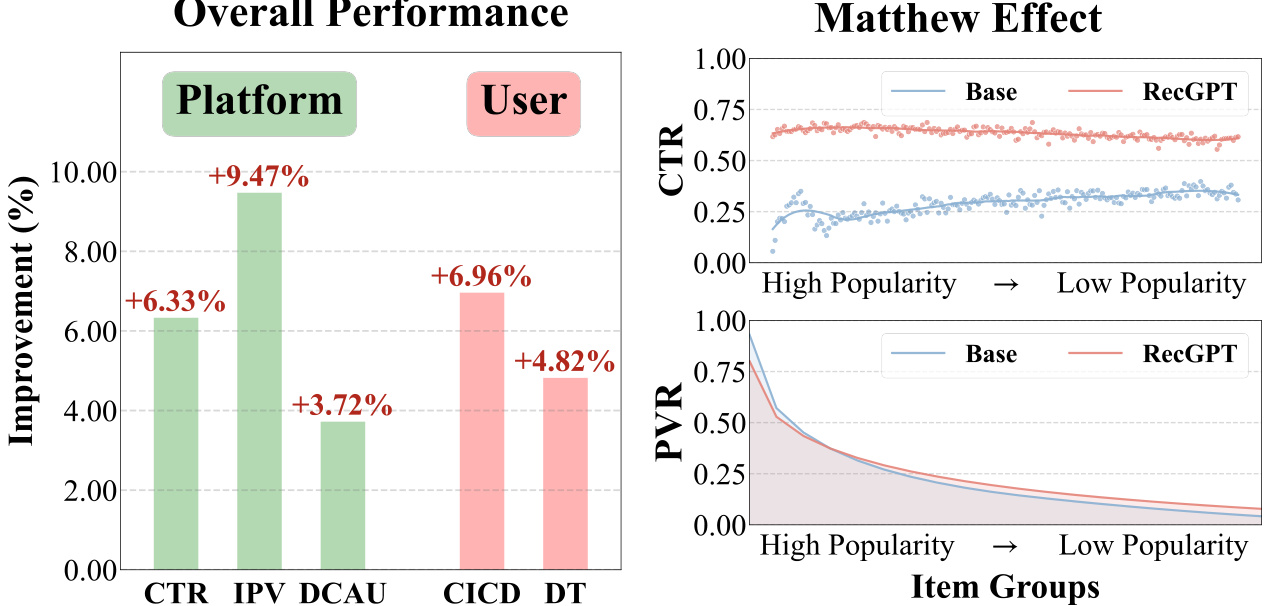

RecGPT通过大语言模型(LLM)的语义理解能力,将推荐系统从”行为拟合”升级为”意图理解”。在淘宝”猜你喜欢”场景的线上测试显示:

-

用户点击商品类目多样性(CICD)提升6.96% -

商家曝光公平性提升9.47% -

用户日均停留时长(DT)增加4.82%

二、RecGPT技术架构深度解析

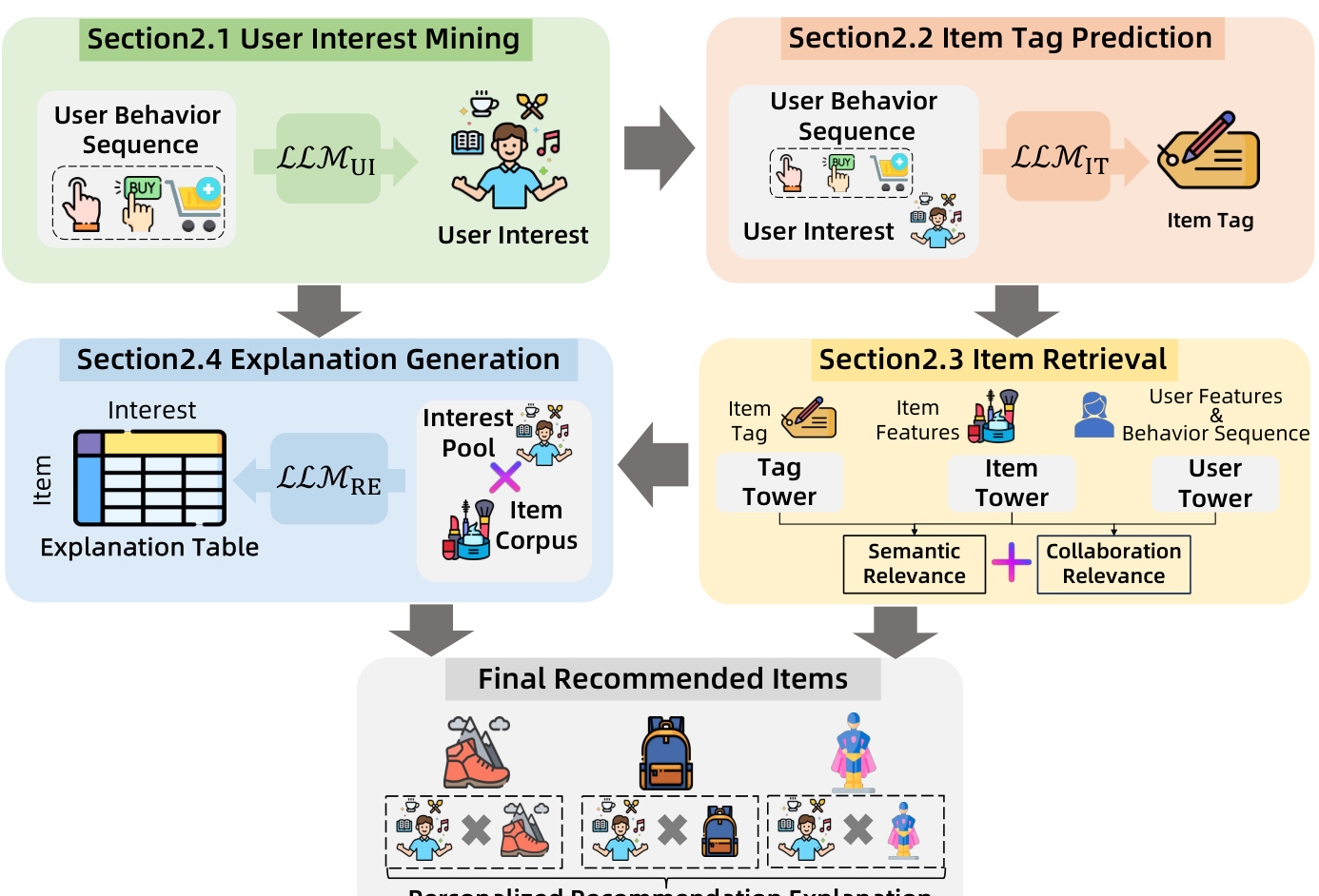

2.1 用户意图挖掘模块

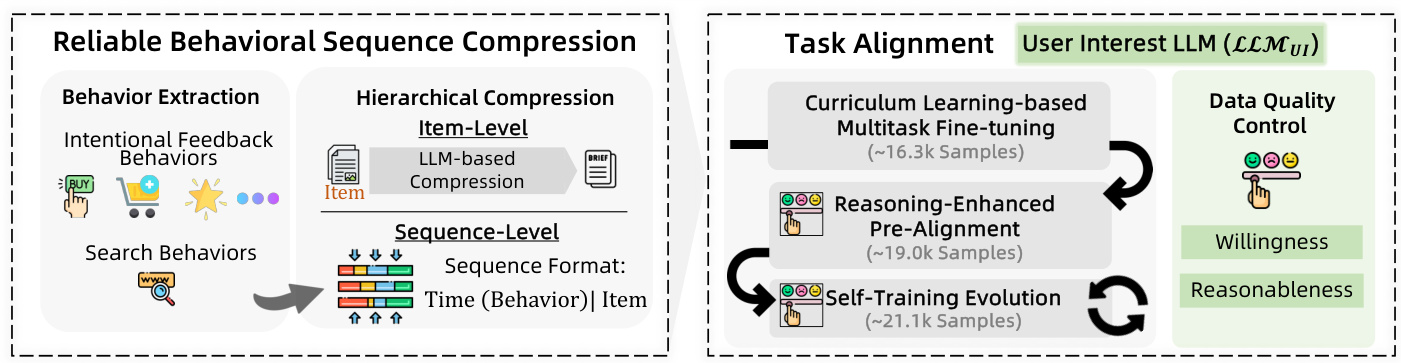

2.1.1 超长行为序列处理

挑战:淘宝用户平均行为序列长度超过37,000条,远超LLM的128K token限制

解决方案:分层行为压缩技术

| 压缩层级 | 处理方法 | 效果提升 |

|---|---|---|

| 行为级压缩 | 提取高置信度行为(收藏/加购/搜索) | 输入长度减少40% |

| 序列级压缩 | 时序-行为类型聚合+商品反向聚合 | 输入长度再减少58% |

示例压缩结果:

时间1(搜索:跑鞋,点击:运动袜),时间2(加购:运动水壶)|商品A,商品B,商品C

2.1.2 多阶段任务对齐

采用三阶段训练策略提升意图理解能力:

-

课程学习预训练(16.3k样本)

-

基础层:查询分类、查询-商品相关性判断 -

中间层:电商场景问答、商品卖点提取 -

高级层:因果推理、关键词提取

-

-

推理增强预训练(19.0k样本)

-

使用DeepSeek-R1生成高质量训练数据 -

重点训练:跨行为类型意图识别、隐性需求推理

-

-

自训练进化(21.1k样本)

-

模型自我生成训练数据 -

通过LLM裁判系统自动评估数据质量

-

2.2 物品标签预测模块

2.2.1 标签生成规范

要求输出格式为”修饰词+核心词”,例如:

户外防水防滑徒步鞋

2.2.2 多约束提示工程

生成提示包含5项核心约束:

| 约束类型 | 具体要求 | 示例 |

|---|---|---|

| 兴趣一致性 | 标签必须与用户兴趣强相关 | 拒绝:刺绣鸟花卉丝绸枕套(护肤兴趣) |

| 多样性增强 | 每用户至少生成50个标签 | 覆盖:服装/美妆/家居等8个类目 |

| 语义精准度 | 避免模糊描述 | 拒绝:时尚运动器材 |

| 时效新鲜度 | 优先推荐新品类 | 夏季重点推荐:防晒衣/凉鞋 |

| 季节相关性 | 结合当前时间生成 | 冬季推荐:羽绒服/保暖内衣 |

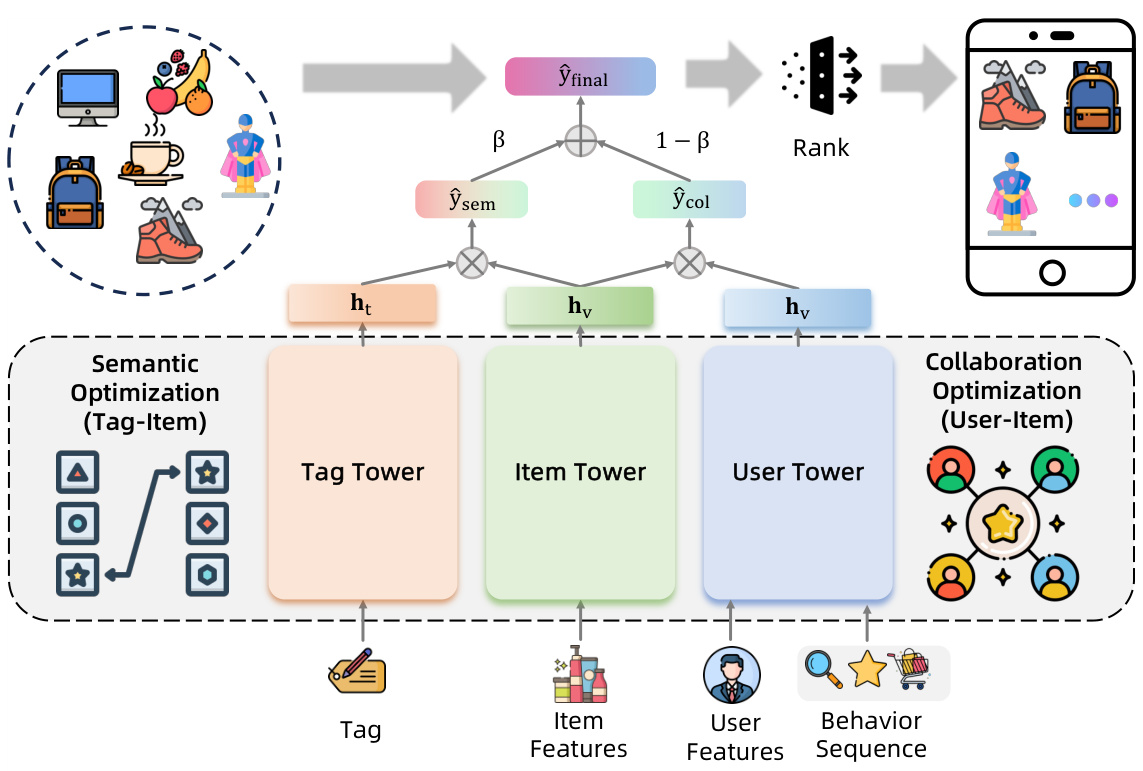

2.3 三塔检索架构

创新性采用”用户-物品-标签”三塔架构:

| 塔结构 | 输入特征 | 输出维度 | 作用 |

|---|---|---|---|

| 用户塔 | 用户ID+多行为序列 | 256维 | 捕捉协同过滤信号 |

| 物品塔 | 商品属性+统计特征 | 256维 | 基础商品表示 |

| 标签塔 | LLM生成的标签文本 | 256维 | 注入语义理解 |

融合公式:

最终得分 = β×用户塔得分 + (1-β)×标签塔得分

(β=0.6时效果最佳)

三、RecGPT部署效果分析

3.1 线上A/B测试结果

在淘宝”猜你喜欢”场景的线上实验(2025.6.17-6.20)显示:

| 指标 | 提升幅度 | 说明 |

|---|---|---|

| 用户停留时长(DT) | +4.82% | 内容吸引力增强 |

| 点击商品类目多样性(CICD) | +6.96% | 突破信息茧房 |

| 曝光商品类目多样性(EICD) | +0.11% | 展示更丰富 |

| 商品详情页访问量(IPV) | +9.47% | 用户探索意愿提升 |

| 点击率(CTR) | +6.33% | 推荐精准度提高 |

| 日均点击活跃用户(DCAU) | +3.72% | 用户粘性增强 |

3.2 商家生态改善

通过分析不同商品组的CTR/PVR分布:

-

头部商品(Top 1%)CTR下降1.2%,避免过度集中 -

腰部商品(Top 10%-30%)CTR提升8.7% -

尾部商品(排名>50%)曝光量增加23%

四、技术挑战与未来方向

4.1 当前挑战

-

超长序列建模

-

仍有2%的用户行为序列超过128K token限制 -

需优化上下文窗口管理策略

-

-

多目标联合学习

-

当前采用定期模型更新方式 -

缺乏实时适应用户偏好变化的机制

-

4.2 未来规划

-

强化学习多目标优化

-

引入ROLL框架进行在线反馈优化 -

同时优化:用户参与度/转化率/平台健康度

-

-

端到端LLM裁判系统

-

开发基于人类反馈的强化学习(RLHF) -

构建统一的多任务评估体系

-

五、常见问题解答(FAQ)

Q1: RecGPT如何解决传统推荐系统的信息茧房问题?

A: 通过三层语义理解机制:

-

用户意图挖掘模块识别跨类目潜在兴趣 -

标签预测模块强制生成50+多样化标签 -

检索阶段平衡协同过滤与语义匹配得分

Q2: 部署RecGPT需要哪些硬件资源?

A:

-

训练阶段:8×A100 GPU(用于模型对齐) -

在线服务:采用FP8量化+KV缓存技术 -

推理速度提升57%,适合大规模部署

Q3: RecGPT对中小商家有什么影响?

A:

-

尾部商品曝光量提升23% -

商家广告分布更均衡 -

打破”强者恒强”的马太效应

Q4: 标签生成过程中如何保证质量?

A:

-

4维数据质量控制:相关性/一致性/特异性/有效性 -

人工+LLM双重评估机制 -

拒绝率控制在15%以内