Rubrics as Rewards (RaR):用评分表教AI更懂人类偏好

引言:为什么需要新的奖励机制?

在强化学习领域,模型需要通过奖励信号来判断自己的输出质量。传统方法依赖偏好排序(如人类对多个答案打分),但存在两个核心问题:

-

不可解释性:黑盒奖励函数难以分析问题根源 -

过拟合风险:模型可能学会迎合评分者的表面偏好,而非真正理解内容质量

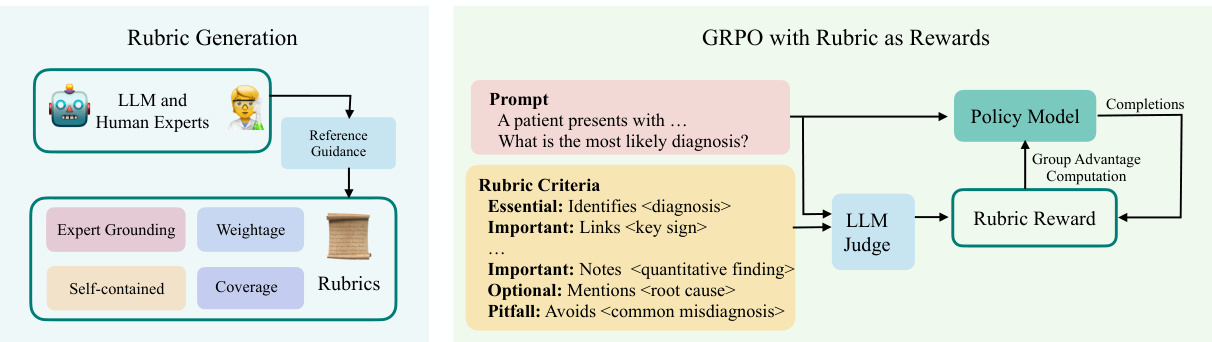

本文提出的Rubrics as Rewards (RaR)框架,通过将评分规则拆解为结构化检查清单,让AI训练过程更透明、更可靠。实验显示,该方法在医疗和科学推理任务中表现优异,甚至超过依赖专家答案的传统方法。

图1:RaR通过生成检查清单(Rubric)作为奖励信号,替代传统偏好排序

RaR核心原理:把评分标准变成可计算的检查项

1. 什么是Rubric?

一组结构化的评分标准,包含多个独立评估维度。例如对医疗回答的评分可能包含:

[

{

"标题": "诊断准确性",

"描述": "必须准确识别非对比螺旋CT作为检测输尿管结石的最佳手段",

"权重": 5

},

{

"标题": "安全提示",

"描述": "必须提及检查前无需禁食",

"权重": 3

}

]

2. 奖励计算方式

每个回答的最终得分由各维度满足情况加权计算:

总得分 = Σ(维度权重 × 是否满足该维度) / 总权重

3. 两种聚合方式对比

| 聚合方式 | 原理 | 优势 |

|---|---|---|

| 显式聚合 | 独立计算每个维度的0/1得分,再加权求和 | 可解释性强,便于调试 |

| 隐式聚合 | 将所有维度描述输入大模型,让模型自行判断整体质量 | 更适应复杂场景,实验效果更好 |

Rubric生成三原则:专家思维结构化

研究者使用大模型自动生成Rubric时遵循以下原则:

| 生成原则 | 具体要求 | 示例 |

|---|---|---|

| 基于专家答案 | 使用领域专家答案作为生成参考 | 医疗领域参考临床指南,科学领域参考教科书 |

| 全面覆盖质量维度 | 包含事实准确性、逻辑结构、完整性、常见误区等维度 | 既检查关键事实,也评估表达清晰度 |

| 语义权重标注 | 为每个维度标注重要性等级(必须、重要、可选、禁忌) | “必须”类维度权重最高,”禁忌”为负权重 |

| 自包含可评估 | 每个维度描述独立完整,非专业人士也能直接判断 | 避免依赖外部知识背景 |

实验验证:医疗科学领域表现亮眼

1. 数据集与基线方法

| 数据集 | 规模 | 内容领域 |

|---|---|---|

| RaR-Medical-20k | 2万条 | 医疗诊断治疗 |

| RaR-Science-20k | 2万条 | 物理化学生物 |

对比基线:

-

Simple-Likert:直接对回答进行1-10分打分 -

Reference-Likert:对比专家答案进行打分 -

预定义通用Rubric:使用固定检查项

2. 核心结果

| 方法 | 医疗领域得分 | 科学领域得分 |

|---|---|---|

| Simple-Likert | 0.2489 | 0.3409 |

| Reference-Likert | 0.3155 | 0.3775 |

| RaR-Implicit | 0.3194 | 0.3864 |

注:RaR-Implicit在两个领域均超过传统偏好排序方法

3. 关键发现

(1) 隐式聚合优于显式加权

-

显式方法需人工设定维度权重,而隐式方法让模型自动平衡各维度 -

医疗领域隐式方法得分0.3194,显式方法0.2979

(2) Rubric质量决定效果

-

使用专家答案生成的Rubric效果最佳 -

纯合成Rubric(无专家参考)表现下降15%

(3) 小模型受益显著

-

使用7B参数模型作为评分器时: -

Rubric指导使准确率提升4.7% -

与32B参数模型效果接近

-

技术实现关键点

1. Rubric生成Prompt示例(医疗领域)

你是一位评分表生成专家,请根据以下输入生成结构化评估标准:

问题:{医疗问题文本}

参考回答:{专家答案}

要求:

- 7-20个检查项

- 包含"必须/重要/可选/禁忌"四类维度

- 每个项独立可评估

- 输出JSON格式

2. 训练流程

graph TD

A[初始模型] --> B{生成16个回答}

B --> C[使用gpt-4o-mini进行Rubric评分]

C --> D[计算加权得分]

D --> E[GRPO算法更新模型参数]

E --> A

实际应用建议

1. 领域适配指南

-

医疗场景:重点检查事实准确性、安全提示、治疗方案完整性 -

科学场景:强调公式推导步骤、实验条件说明、结论验证

2. 常见误区

-

❌ 过度追求检查项数量(建议7-15项) -

❌ 权重设置过于复杂(保持3-4个等级即可) -

❌ 忽视负向检查项(”禁忌”类项可有效避免常见错误)

3. 未来改进方向

-

动态权重学习:根据训练反馈自动调整维度重要性 -

多模态扩展:支持图表、代码等非文本内容的评估 -

领域迁移:研究如何将医疗领域训练的Rubric迁移到其他专业领域

总结

RaR框架通过将人类评估逻辑结构化为可计算的检查项,在保持高精度的同时提升了奖励机制的可解释性。这种方法特别适合需要专业知识判断的领域,为AI在医疗、科研等关键领域的应用提供了新的优化路径。

下一步行动建议:

-

尝试用现成LLM为你的专业领域生成基础Rubric -

从隐式聚合开始实验,逐步优化检查项设计 -

关注模型在长尾问题上的表现差异