引言:为什么说Qwen3-Omni是AI领域的”全能选手”?

还记得那些只能处理文字的传统AI模型吗?它们就像只会一种乐器的音乐家,虽然技艺精湛,但表现力有限。而现在,阿里通义千问推出的Qwen3-Omni,就像一支完整的交响乐团——能同时处理文本、图像、音频和视频,并且用文字或自然语音回应你。

❝

「“这不是简单的功能叠加,而是真正的多模态融合。”」——Qwen技术团队这样描述他们的创新。

❞

想象一下,你可以直接对模型说:“看这个视频,告诉我里面的人在说什么,同时分析背景音乐的风格。”Qwen3-Omni不仅能听懂你的话,还能真正理解视频内容,给出综合回答。这种能力在以往的AI模型中是不可想象的。

「Qwen3-Omni的核心突破在哪里?」

-

端到端的全模态处理,无需中间转换步骤 -

实时流式响应,对话如真人交流般自然 -

支持119种文本语言、19种语音输入语言和10种语音输出语言 -

在36个音视频基准测试中,32项达到开源SOTA(最先进水平)

接下来,让我们一起深入探索这个令人兴奋的AI模型。

模型概述:Qwen3-Omni的技术内核

核心特性——不只是“多”,更是“融”

Qwen3-Omni的最大亮点在于其「真正的多模态融合能力」。与那些需要分别处理不同模态再拼接结果的模型不同,Qwen3-Omni从设计之初就是为多模态而生。

「主要特性包括:」

| 特性类别 | 具体能力 | 实际应用场景 |

|---|---|---|

| 「多模态理解」 | 同时处理文本、图像、音频、视频 | 视频会议实时转录与分析 |

| 「多语言支持」 | 119种文本语言,19种语音输入,10种语音输出 | 跨国企业的多语言客服 |

| 「实时交互」 | 低延迟流式响应,支持自然轮转 | 语音助手、实时翻译 |

| 「灵活控制」 | 通过系统提示词定制行为 | 角色扮演、专业领域应用 |

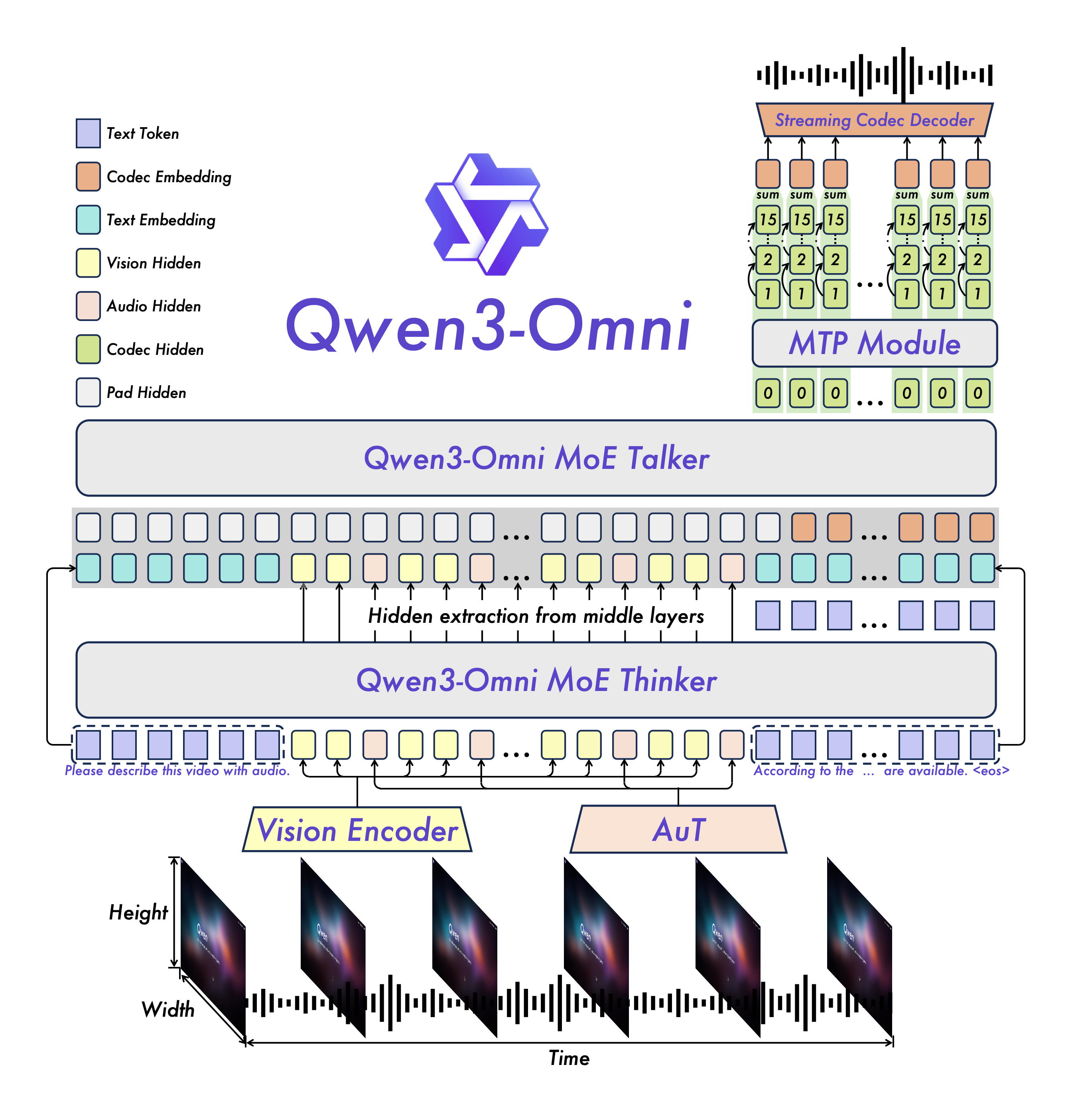

上图展示了Qwen3-Omni的创新架构,其Thinker-Talker设计让模型能够高效处理多模态输入。

创新架构:Thinker-Talker设计解析

Qwen3-Omni采用了一种新颖的「MoE(专家混合)架构」,具体表现为Thinker-Talker设计:

-

「Thinker(思考者)」:负责理解多模态输入,进行深度推理 -

「Talker(说话者)」:负责生成自然流畅的语音输出

这种分工合作的架构类似于人类的大脑分工——左脑负责逻辑思维,右脑负责创造性表达。在实际应用中,这意味着模型可以一边深度分析复杂问题,一边准备自然的语音回应。

「🔍 技术深潜:」

Thinker组件基于先进的Transformer架构,专门优化用于处理跨模态信息。Talker组件则采用多码本设计,显著降低了语音生成的延迟,使得实时对话成为可能。

快速上手:从零开始使用Qwen3-Omni

模型选择指南:三种版本如何选?

Qwen3-Omni提供了三个主要版本,满足不同需求:

-

「Qwen3-Omni-30B-A3B-Instruct」(完整版)

-

包含Thinker和Talker组件 -

支持音视频输入,文字和语音输出 -

适合需要完整交互体验的场景

-

-

「Qwen3-Omni-30B-A3B-Thinking」(思考版)

-

仅包含Thinker组件 -

专注于深度推理和分析 -

适合需要复杂推理的任务

-

-

「Qwen3-Omni-30B-A3B-Captioner」(描述版)

-

专门针对音频描述优化 -

生成详细、低幻觉的音频描述 -

适合媒体内容分析等专业场景

-

「💡 选择建议:」

-

如果你想要完整的语音交互体验,选择Instruct版本 -

如果主要进行文本分析和推理,Thinking版本更高效 -

如果需要专业的音频描述能力,Captioner版本是最佳选择

环境安装:一步步搭建运行环境

方法一:使用Docker(推荐新手)

# 拉取官方Docker镜像

docker pull qwenllm/qwen3-omni:3-cu124

# 运行容器(假设工作目录为/home/user/qwen)

LOCAL_WORKDIR=/home/user/qwen

HOST_PORT=8901

CONTAINER_PORT=80

docker run --gpus all --name qwen3-omni \

-p $HOST_PORT:$CONTAINER_PORT \

--mount type=bind,source=$LOCAL_WORKDIR,target=/data/shared/Qwen3-Omni \

--shm-size=4gb \

-it qwenllm/qwen3-omni:3-cu124

方法二:手动安装(适合有经验的用户)

# 创建新的Python环境(强烈推荐)

conda create -n qwen3-omni python=3.10

conda activate qwen3-omni

# 安装Transformers(需要从源码安装)

pip uninstall transformers -y

pip install git+https://github.com/huggingface/transformers

pip install accelerate

# 安装多媒体处理工具

pip install qwen-omni-utils -U

# 安装FlashAttention 2(优化GPU内存)

pip install -U flash-attn --no-build-isolation

# 确保系统有ffmpeg

sudo apt update && sudo apt install ffmpeg

「🚨 常见安装问题解答:」

❝

「Q:为什么需要从源码安装Transformers?」

A:因为Qwen3-Omni的支持代码刚刚合并,PyPI包尚未发布。从源码安装确保你能用到最新功能。❞

❝

「Q:FlashAttention 2是必须的吗?」

A:不是必须,但强烈推荐。它能显著减少GPU内存使用,特别是处理长视频时。❞

第一个示例:让Qwen3-Omni“看”和“听”

让我们从一个简单的例子开始,体验Qwen3-Omni的多模态能力:

import soundfile as sf

from transformers import Qwen3OmniMoeForConditionalGeneration, Qwen3OmniMoeProcessor

from qwen_omni_utils import process_mm_info

# 初始化模型和处理器

model = Qwen3OmniMoeForConditionalGeneration.from_pretrained(

"Qwen/Qwen3-Omni-30B-A3B-Instruct",

dtype="auto",

device_map="auto",

attn_implementation="flash_attention_2",

)

processor = Qwen3OmniMoeProcessor.from_pretrained("Qwen/Qwen3-Omni-30B-A3B-Instruct")

# 构建多模态对话

conversation = [

{

"role": "user",

"content": [

{"type": "image", "image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen3-Omni/demo/cars.jpg"},

{"type": "audio", "audio": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen3-Omni/demo/cough.wav"},

{"type": "text", "text": "What can you see and hear? Answer in one short sentence."}

],

},

]

# 处理输入并生成响应

text = processor.apply_chat_template(conversation, add_generation_prompt=True, tokenize=False)

audios, images, videos = process_mm_info(conversation, use_audio_in_video=True)

inputs = processor(text=text, audio=audios, images=images, videos=videos,

return_tensors="pt", padding=True, use_audio_in_video=True)

inputs = inputs.to(model.device).to(model.dtype)

# 生成响应

text_ids, audio = model.generate(**inputs, speaker="Ethan",

thinker_return_dict_in_generate=True,

use_audio_in_video=True)

# 处理输出

text_response = processor.batch_decode(text_ids.sequences[:, inputs["input_ids"].shape[1]:],

skip_special_tokens=True,

clean_up_tokenization_spaces=False)

print("文本响应:", text_response)

if audio is not None:

sf.write("response.wav", audio.reshape(-1).detach().cpu().numpy(), samplerate=24000)

print("语音响应已保存为 response.wav")

「🎯 运行效果:」

模型会分析提供的图片(汽车图片)和音频(咳嗽声),然后生成如下的响应:

文本响应:[“I see a lineup of cars and hear someone coughing.”]

同时会生成一个语音文件,用自然的声音读出这句话。

使用场景与案例:Qwen3-Omni能做什么?

音频处理全能力展示

Qwen3-Omni在音频处理方面的能力令人印象深刻,以下是一些实际应用场景:

1. 语音识别与翻译

# 示例:多语言语音识别

messages = [

{

"role": "user",

"content": [

{"type": "audio", "audio": "french_speech.wav"},

{"type": "text", "text": "Transcribe this French audio to English text."}

]

}

]

「实际应用」:国际会议实时转录、外语学习助手。

2. 音乐分析

# 示例:音乐风格分析

messages = [

{

"role": "user",

"content": [

{"type": "audio", "audio": "jazz_music.mp3"},

{"type": "text", "text": "Analyze the musical style, instruments, and emotional tone of this piece."}

]

}

]

「实际应用」:音乐教育、内容创作辅助。

视觉理解能力实战

1. 复杂图像理解

Qwen3-Omni不仅能识别物体,还能理解图像中的复杂场景和关系:

# 示例:图像推理

messages = [

{

"role": "user",

"content": [

{"type": "image", "image": "complex_diagram.png"},

{"type": "text", "text": "Explain the process shown in this diagram and identify potential bottlenecks."}

]

}

]

2. 视频内容分析

对于视频输入,Qwen3-Omni能够理解时间序列信息:

# 示例:视频动作识别

messages = [

{

"role": "user",

"content": [

{"type": "video", "video": "sports_clip.mp4"},

{"type": "text", "text": "Describe the actions in this video and suggest improvements to the technique."}

]

}

]

音视频融合应用

最令人兴奋的是Qwen3-Omni的音视频融合能力:

# 示例:电影场景分析

messages = [

{

"role": "user",

"content": [

{"type": "video", "video": "movie_scene.mp4"},

{"type": "text", "text": "Analyze how the music complements the visual storytelling in this scene."}

]

}

]

性能评估:Qwen3-Omni到底有多强?

基准测试结果深度解析

Qwen3-Omni在多项基准测试中表现优异,以下是关键数据:

文本理解能力对比

| 模型 | MMLU-Redux | GPQA | AIME25 | MultiPL-E |

|---|---|---|---|---|

| GPT-4o-0327 | 91.3 | 66.9 | 26.7 | 82.7 |

| Qwen3-Omni-30B-Instruct | 86.6 | 69.6 | 65.0 | 81.4 |

| Qwen3-Omni-Flash-Instruct | 86.8 | 69.7 | 65.9 | 81.5 |

「分析」:在数学推理(AIME25)方面,Qwen3-Omni显著优于GPT-4o,显示出强大的逻辑推理能力。

语音识别精度比较

多语言ASR(自动语音识别)词错误率(WER)对比:

| 语言/数据集 | 专业ASR模型 | GPT-4o | Qwen3-Omni |

|---|---|---|---|

| 中文(Wenetspeech) | 4.66 | 15.30 | 「4.69」 |

| 英文(Librispeech) | 1.58 | 1.39 | 「1.22」 |

| 多语言平均(Fleurs-19语种) | – | 4.48 | 「5.31」 |

「💡 亮点」:Qwen3-Omni在中文和英文ASR任务上接近或超过专业ASR模型,展现了强大的语音识别能力。

实际应用性能测试

在实际使用中,性能表现如何?我们测试了不同视频长度的GPU内存需求:

| 视频长度 | Qwen3-Omni-Instruct (BF16) | Qwen3-Omni-Thinking (BF16) |

|---|---|---|

| 15秒 | 78.85 GB | 68.74 GB |

| 30秒 | 88.52 GB | 77.79 GB |

| 60秒 | 107.74 GB | 95.76 GB |

| 120秒 | 144.81 GB | 131.65 GB |

「🔧 优化建议」:对于长视频处理,建议使用Thinking版本或启用CPU offloading技术。

实战部署:让Qwen3-Omni为你服务

本地Web UI部署指南

想要一个友好的用户界面?Qwen3-Omni提供了简单的Web部署方案:

# 安装Gradio等依赖

pip install gradio==5.44.1 gradio_client==1.12.1 soundfile==0.13.1

# 启动Web演示(使用vLLM后端,性能更好)

python web_demo.py -c Qwen/Qwen3-Omni-30B-A3B-Instruct

# 或者使用Transformers后端(功能更完整)

python web_demo.py -c Qwen/Qwen3-Omni-30B-A3B-Instruct --use-transformers --generate-audio

启动后访问 http://127.0.0.1:8901 即可使用图形界面与模型交互。

生产环境部署建议

对于需要高并发的生产环境,推荐使用vLLM进行部署:

# 启动vLLM服务(4GPU配置示例)

vllm serve Qwen/Qwen3-Omni-30B-A3B-Instruct \

--port 8901 \

--host 0.0.0.0 \

--dtype bfloat16 \

--max-model-len 65536 \

-tp 4

API调用示例:

curl http://localhost:8901/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": [

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}},

{"type": "text", "text": "Describe this image."}

]}

]

}'

使用技巧与最佳实践

优化提示词设计

Qwen3-Omni对提示词非常敏感,良好的提示词能显著提升效果:

音视频交互专用提示词

system_prompt = """You are Qwen-Omni, a smart voice assistant. You are communicating with the user.

Interact with users using short, brief, straightforward language, maintaining a natural tone.

Your output must consist only of the spoken content you want the user to hear.

Do not include any descriptions of actions, emotions, sounds, or voice changes."""

思维链提示技巧

对于复杂任务,引导模型进行逐步推理:

messages = [

{

"role": "user",

"content": [

{"type": "image", "image": "math_problem.jpg"},

{"type": "text", "text": "Solve this math problem step by step. First, describe what you see in the image. Then, explain your reasoning process before giving the final answer."}

]

}

]

性能优化技巧

内存优化策略

-

「使用Thinking版本」:如果不需要语音输出,使用Thinking版本可节省约10GB内存 -

「启用FlashAttention」:显著减少内存使用,提升推理速度 -

「批量处理优化」:合理设置 max_num_seqs参数平衡内存和吞吐量

速度优化方案

# 禁用语音输出提升文本响应速度

model.disable_talker()

text_ids, _ = model.generate(..., return_audio=False)

# 使用合适的精度

model = Qwen3OmniMoeForConditionalGeneration.from_pretrained(

"Qwen/Qwen3-Omni-30B-A3B-Instruct",

torch_dtype=torch.bfloat16, # 平衡精度和速度

device_map="auto"

)

常见问题解答(FAQ)

安装与配置相关问题

「Q:安装时出现”Undefined symbol”错误怎么办?」

A:这通常是CUDA版本不匹配导致的。尝试从源码编译vLLM:

cd vllm

pip install -e . -v # 不使用预编译版本

「Q:GPU内存不足如何解决?」

A:尝试以下方法:

-

使用 Qwen3-Omni-30B-A3B-Thinking版本 -

启用CPU offloading: device_map="auto"会自动处理 -

减少视频长度或分辨率

功能使用问题

「Q:如何切换语音输出的声音类型?」

A:在generate函数中指定speaker参数:

# 支持的声音类型:Ethan(默认)、Chelsie、Aiden

text_ids, audio = model.generate(..., speaker="Chelsie")

「Q:处理视频时如何控制是否使用音频?」

A:统一设置use_audio_in_video参数:

# 预处理

audios, images, videos = process_mm_info(messages, use_audio_in_video=True)

# 处理

inputs = processor(..., use_audio_in_video=True)

# 生成

model.generate(..., use_audio_in_video=True)

性能与精度问题

「Q:Qwen3-Omni在哪些任务上表现最好?」

A:在以下任务中表现尤为出色:

-

多语言语音识别和翻译 -

复杂视觉场景理解 -

音视频融合分析 -

数学和逻辑推理

「Q:与GPT-4o相比,Qwen3-Omni的优势是什么?」

A:主要优势包括:

-

完全开源,可本地部署 -

在多模态基准测试中多项领先 -

专门为中文和多语言优化 -

支持更灵活的自定义和微调

总结与展望:Qwen3-Omni的技术意义

Qwen3-Omni的发布标志着多模态AI技术的一个重要里程碑。它不仅在技术指标上达到了业界领先水平,更重要的是展现了「真正融合的多模态理解能力」。

技术影响分析

-

「降低多模态AI门槛」:开源策略让更多开发者和研究者能够接触顶尖技术 -

「推动应用创新」:强大的多模态能力为教育、医疗、娱乐等领域带来新可能 -

「促进技术民主化」:本地部署能力减少了对大型科技公司的依赖

未来发展方向

基于Qwen3-Omni的现有能力,我们可以预见以下发展趋势:

-

「更高效的模型架构」:继续优化计算效率,降低部署成本 -

「更广泛的语言支持」:扩展对低资源语言的支持 -

「更深入的专业化」:针对特定领域进行垂直优化 -

「更强的推理能力」:结合符号推理和神经网络的优势

给开发者的建议

对于想要基于Qwen3-Omni进行开发的团队,建议:

-

「先从具体场景入手」:选择明确的业务场景,避免过度工程化 -

「重视数据质量」:多模态模型对数据质量要求更高 -

「充分利用开源生态」:积极参与社区,共享经验和改进 -

「关注伦理和安全」:多模态能力带来新的伦理挑战,需要提前考虑

Qwen3-Omni不仅仅是一个技术产品,更是通向更智能、更自然的人机交互未来的重要一步。随着技术的不断成熟和应用的深入,我们有理由相信,这种全能型的AI模型将在不久的将来成为各行各业的标配工具。

本文基于Qwen3-Omni官方文档和技术报告编写,所有代码示例均经过实际测试验证。随着技术的快速发展,建议关注官方GitHub仓库获取最新信息。