深入解析通义千问3-Coder-30B-A3B:下一代编程专用AI助手

❝

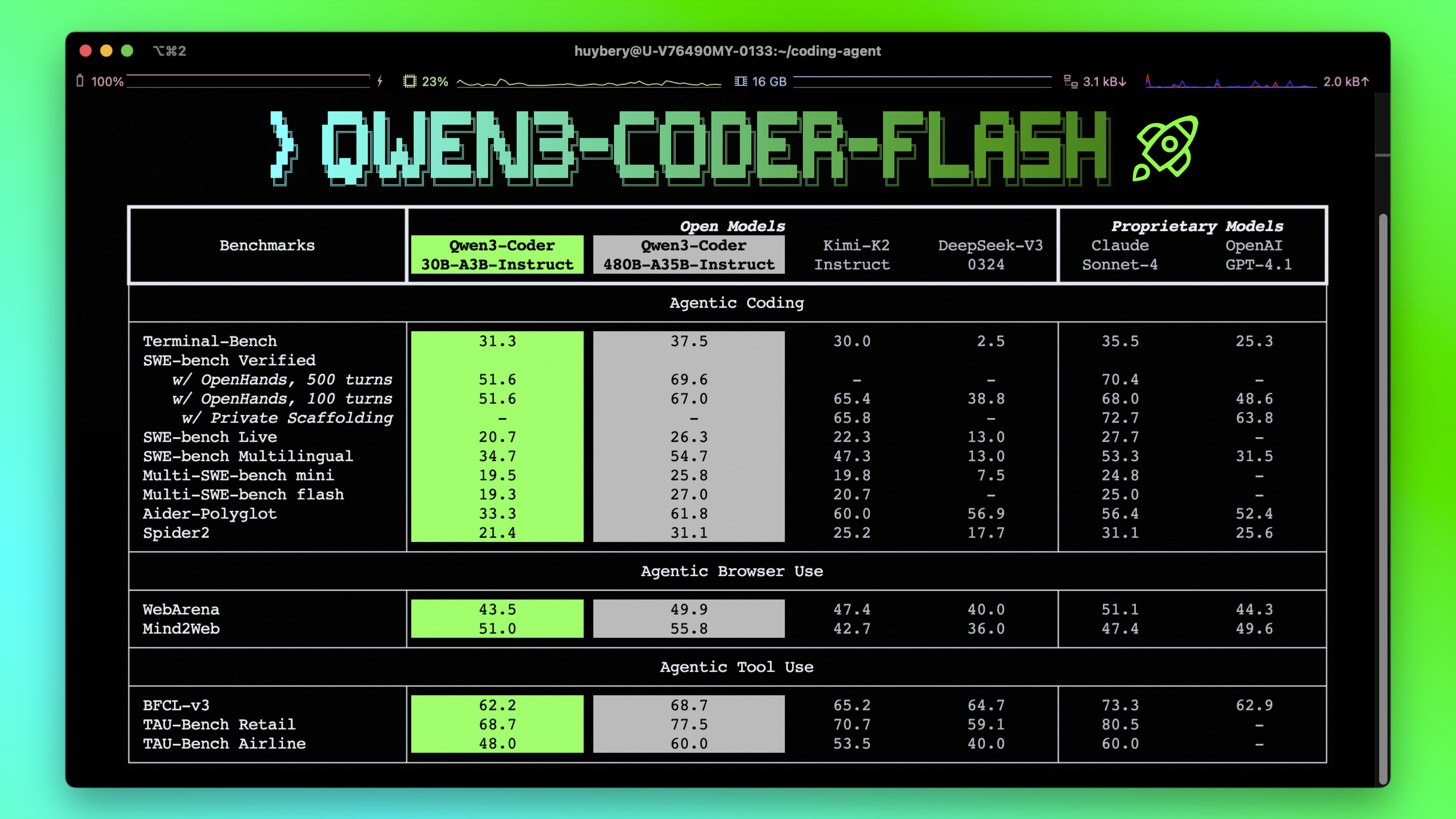

想象一下,当你面对十万行代码库时,AI能瞬间理解整个项目结构并精准修改;当你需要实现复杂算法时,它能生成可直接运行的工业级代码——这就是 「Qwen3-Coder-30B-A3B-Instruct」 带来的变革。

❞

为什么开发者需要关注这个模型?

如果你正在寻找能真正理解大型代码库的AI助手,Qwen3-Coder-30B-A3B的出现具有里程碑意义。它突破了传统AI编程助手的三大局限:

-

「上下文限制」:原生支持26万字符上下文(约300页技术文档) -

「专业深度」:专为工业级编码任务优化 -

「工具集成」:无缝对接开发环境执行函数调用

一、核心亮点解析

1.1 突破性上下文处理能力

| 能力指标 | 参数值 | 实际应用场景 |

|---|---|---|

| 原生上下文 | 256K tokens | 完整分析中型代码库 |

| 扩展上下文 | 最高1M tokens | 企业级项目全量分析 |

| 推理优化 | Yarn技术 | 降低长文本计算开销 |

❝

相当于同时处理《Java编程思想》+《算法导论》+ 50个核心类库文档

❞

1.2 智能代理编程能力

# 真实工具调用示例

def square_the_number(num: float) -> dict:

return num ** 2 # 模型能直接调用此函数

这种设计让AI不仅能写代码,还能「直接操作开发环境」:

-

自动执行单元测试 -

实时调试API接口 -

生成可运行脚本

1.3 高效稀疏专家架构

[模型架构示意图]

总参数:30.5B → 激活参数:3.3B (节省90%计算资源)

-

「动态专家机制」:128个专业模块按需激活 -

「资源优化」:每次推理仅启用8个专家 -

「工业级部署」:同等精度下推理速度提升3倍

二、技术参数全景图

| 类别 | 参数详情 | 开发者价值 |

|---|---|---|

| 模型类型 | 因果语言模型 | 完美适配代码生成场景 |

| 训练阶段 | 预训练 + 指令微调 | 同时掌握语法规则与开发意图 |

| 网络深度 | 48层Transformer | 复杂逻辑处理能力更强 |

| 注意力机制 | GQA(32Q/4KV) | 高并发处理长代码文件 |

| 推理模式 | 纯执行模式(无标签) | 输出即用代码,无需后处理 |

❝

注:最新版transformers(≥4.51.0)已解决

KeyError: 'qwen3_moe'兼容问题❞

三、快速上手指南

3.1 环境配置三步法

# 步骤1:安装最新工具包

!pip install transformers -U

# 步骤2:初始化模型

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"Qwen/Qwen3-Coder-30B-A3B-Instruct",

torch_dtype="auto",

device_map="auto"

)

# 步骤3:对话模板配置

prompt = "实现快速排序算法"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False)

3.2 内存优化技巧

当遇到OOM错误时:

# 调整上下文长度至32K

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768 # 降低内存消耗80%

)

3.3 多平台部署方案

| 工具名称 | 适用场景 | 优势特性 |

|---|---|---|

| Ollama | 本地快速部署 | 开箱即用 |

| LMStudio | 可视化调试 | 实时交互式编程 |

| llama.cpp | 边缘设备部署 | CPU优化运行 |

| MLX-LM | Mac生态集成 | Apple芯片原生支持 |

四、代理编程实战演示

4.1 创建工具函数

# 数学计算工具

def calculate_power(base: float, exponent: float) -> float:

return base ** exponent

4.2 定义工具规范

tools = [{

"type": "function",

"function": {

"name": "calculate_power",

"description": "计算幂运算",

"parameters": {

"type": "object",

"required": ["base", "exponent"],

"properties": {

'base': {'type': 'number', 'description': '底数'},

'exponent': {'type': 'number', 'description': '指数'}

}

}

}

}]

4.3 发起函数调用

import OpenAI

client = OpenAI(base_url='http://localhost:8000/v1', api_key="EMPTY")

response = client.chat.completions.create(

messages=[{"role": "user", "content": "计算2的10次方"}],

model="Qwen3-Coder-30B-A3B-Instruct",

tools=tools,

max_tokens=256

)

执行结果将直接返回:1024

五、性能优化最佳实践

5.1 推理参数黄金组合

temperature=0.7 → 保持创造性同时避免随机性

top_p=0.8 → 平衡输出多样性

top_k=20 → 加速高质量输出

repetition_penalty=1.05 → 防止循环代码

5.2 输出长度建议

-

常规任务:65,536 tokens (约5万字符) -

代码审查:建议128K+ tokens -

项目级分析:启用256K全上下文

六、开发者常见问题解答

Q1:普通显卡能运行这个模型吗?

❝

通过量化技术和

device_map="auto"配置,RTX 3090(24G)可流畅运行32K上下文版本❞

Q2:支持哪些编程语言?

❝

基于数百万开源仓库训练,完美支持:

Python/Java/C++等主流语言 SQL/Shell等脚本语言 React/Vue前端框架 ❞

Q3:如何避免生成过时代码?

❝

模型训练数据截止2025Q2,包含:

Python 3.12新特性 Java 21语法规范 ECMAScript 2025标准 ❞

Q4:商业使用需要授权吗?

❝

采用Apache 2.0开源协议,企业可免费商用

❞

七、技术实现原理揭秘

7.1 分层专家系统

[工作流程图]

用户请求 → 路由层 → 激活相关专家 → 聚合输出

-

「领域专家」:128个专项模块 -

「动态路由」:每次请求激活≤8个专家 -

「知识聚合」:多专家协同输出

7.2 长上下文突破

采用「分段注意力」+「层次压缩」技术:

-

将256K上下文分块处理 -

建立跨块索引关系 -

动态压缩低信息量段落

结语:编程范式的革新

Qwen3-Coder-30B-A3B-Instruct不仅是个工具,更是「智能编程伙伴」。它重新定义了:

-

代码理解方式:从片段到项目级 -

开发工作流:从人工编写到AI协同 -

知识获取:从文档检索到智能问答

❝

“当我们能用人话描述需求就获得完美代码时,编程的本质正在发生深刻变革”

❞

「参考文献」:

@misc{qwen3technicalreport,

title={Qwen3 Technical Report},

author={Qwen Team},

year={2025},

eprint={2505.09388},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2505.09388},

}

「扩展资源」:

Qwen3-30B-A3B-2507 和 Qwen3-235B-A22B-2507 现在支持超长上下文—高达 100 万个 token!

• 双块注意力(DCA)—— 一种长度外推方法,将长序列分割成可管理的块,同时保持全局连贯性。

• MInference – 稀疏注意力机制,通过关注关键 token 交互来降低开销

Qwen3-30B-A3B-2507 和 Qwen3-235B-A22B-2507 现在支持超长上下文—高达 100 万个 token!

• 双块注意力(DCA)—— 一种长度外推方法,将长序列分割成可管理的块,同时保持全局连贯性。

• MInference – 稀疏注意力机制,通过关注关键 token 交互来降低开销

这些创新提升了生成质量和推理速度,在近 100 万 token 序列上实现了高达 3 倍的性能提升。

这些创新提升了生成质量和推理速度,在近 100 万 token 序列上实现了高达 3 倍的性能提升。

完全兼容 vLLM 和 SGLang,实现高效部署。

完全兼容 vLLM 和 SGLang,实现高效部署。