深度解析 Qwen3-4B-Instruct-2507:新一代高效能大语言模型实战指南

全面剖析阿里巴巴最新开源大模型 Qwen3-4B-Instruct-2507 的核心特性与应用实践

一、模型核心升级解析

革命性技术突破

-

智能交互增强:显著提升指令跟随能力与逻辑推理精度 -

多语言知识扩展:全面优化中英文等长尾知识覆盖 -

256K上下文支持:原生支持 262,144 tokens 超长文本理解 -

用户偏好对齐:在开放式任务中生成更符合人类预期的内容

技术参数详解

| 特性 | 参数值 |

|---|---|

| 模型类型 | 因果语言模型 |

| 参数量 | 40亿 |

| 非嵌入参数量 | 36亿 |

| 网络层数 | 36层 |

| 注意力机制 | 分组查询注意力(GQA) |

| 上下文长度 | 262,144 tokens |

重要提示:此版本为纯非思考模式,不再生成

<think></think>中间推理步骤

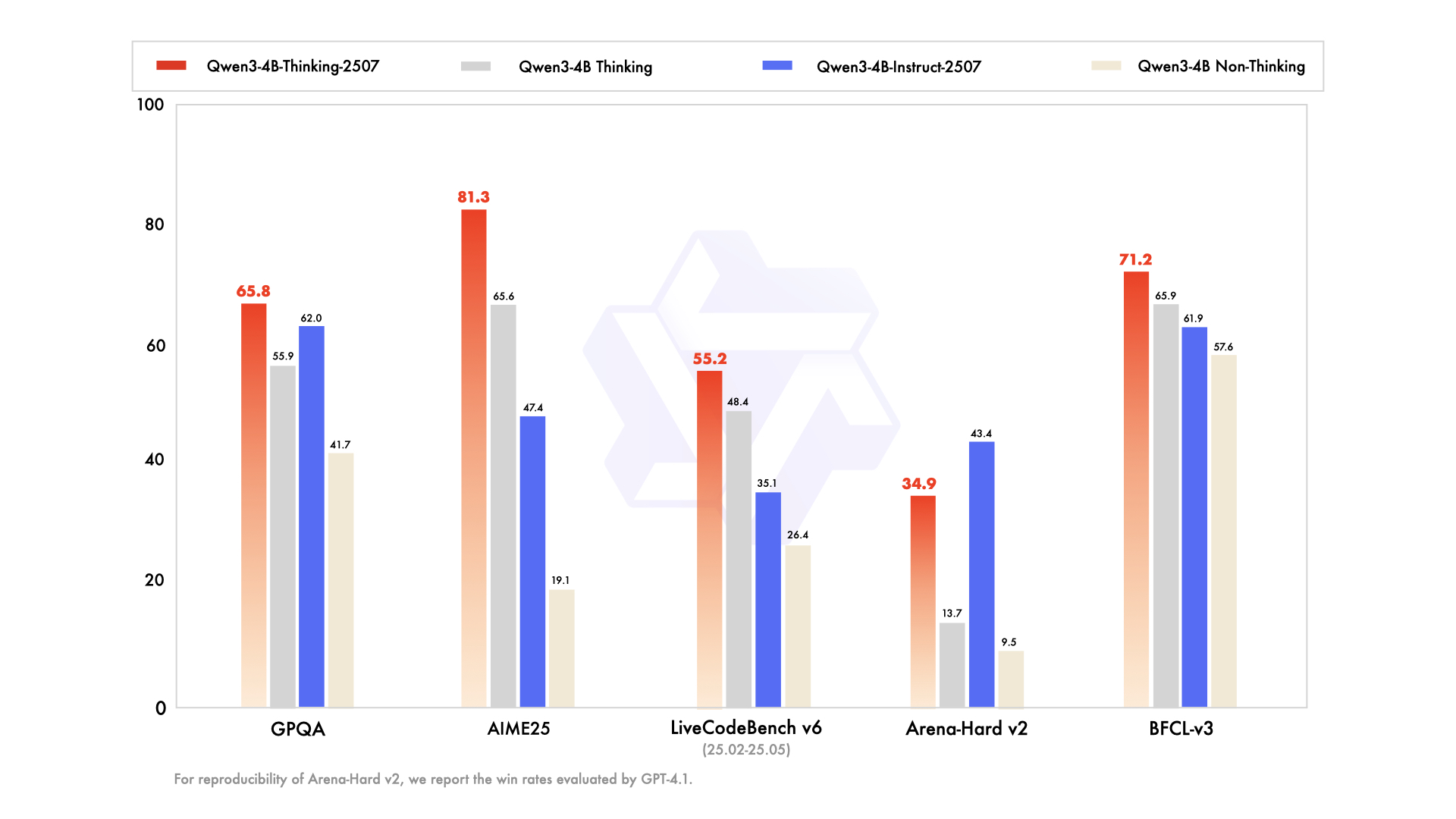

二、性能实测对比

综合能力评测表

| 能力维度 | GPT-4.1-nano | Qwen3-30B | Qwen3-4B原版 | Qwen3-4B-2507 |

|---|---|---|---|---|

| 知识掌握 | ||||

| MMLU-Pro | 62.8 | 69.1 | 58.0 | 69.6 |

| GPQA | 50.3 | 54.8 | 41.7 | 62.0 |

| 逻辑推理 | ||||

| AIME25 | 22.7 | 21.6 | 19.1 | 47.4 |

| ZebraLogic | 14.8 | 33.2 | 35.2 | 80.2 |

| 代码能力 | ||||

| LiveCodeBench | 31.5 | 29.0 | 26.4 | 35.1 |

| MultiPL-E | 76.3 | 74.6 | 66.6 | 76.8 |

| 创作能力 | ||||

| Creative Writing | 72.7 | 68.1 | 53.6 | 83.5 |

| WritingBench | 66.9 | 72.2 | 68.5 | 83.4 |

数据来源:Hugging Face 官方评测报告,基于 GPT-4.1 验证

关键性能亮点

-

科学能力飞跃:GPQA 科学测试得分提升 48.7% -

数学推理突破:AIME25 数学竞赛题性能翻倍 -

创作质量优化:创意写作评分达历史新高 83.5 -

多语言处理:支持 20+ 语言专业术语理解

三、实战部署指南

基础调用代码示例

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载模型与分词器

model = AutoModelForCausalLM.from_pretrained(

"Qwen/Qwen3-4B-Instruct-2507",

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-4B-Instruct-2507")

# 构建对话输入

prompt = "解释量子计算的基本原理"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

# 生成文本

inputs = tokenizer([text], return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=1024)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

生产环境部署方案

方案一:SGLang 服务部署

python -m sglang.launch_server \

--model-path Qwen/Qwen3-4B-Instruct-2507 \

--context-length 262144

方案二:vLLM 高性能引擎

vllm serve Qwen/Qwen3-4B-Instruct-2507 \

--max-model-len 262144

内存优化提示:若遇内存不足,可将上下文长度调整为 32,768

工具集成方案

from qwen_agent.agents import Assistant

# 配置工具型AI助手

agent = Assistant(

llm={'model': 'Qwen3-4B-Instruct-2507'},

tools=['code_interpreter', 'web_search']

)

# 执行任务

response = agent.run([{'role':'user', 'content':'分析今日股市行情'}])

print(response[-1]['content'])

四、优化调参策略

推荐参数配置

| 参数 | 推荐值 | 作用说明 |

|---|---|---|

| Temperature | 0.7 | 控制输出随机性 |

| Top-p | 0.8 | 核心词采样范围 |

| Top-k | 20 | 候选词数量 |

| Min-p | 0 | 最小概率阈值 |

| Presence Penalty | 0-2 | 防重复参数 |

输出规范化技巧

-

数学问题:在提示词中添加

"请逐步推理,并将最终答案放在 \\boxed{} 中" -

选择题:要求输出标准化 JSON {"answer": "C"}

五、常见问题解答(FAQ)

Q1:如何避免内存溢出?

A:通过调整上下文长度参数解决:

model.generate(max_new_tokens=8192) # 根据显存调整

Q2:支持哪些本地运行方案?

A:兼容主流推理框架:

-

Ollama -

LMStudio -

llama.cpp -

MLX-LM (Apple芯片优化)

Q3:多语言处理能力如何?

A:在权威多语言测试中:

-

MultiIF 多语言理解:69.0 -

PolyMATH 多语种数学:31.1

Q4:是否支持工具调用?

A:通过 Qwen-Agent 框架可实现:

tools = [{'name': 'stock_analysis', 'params': {...}}]

agent = Assistant(tools=tools)

六、学术引用规范

@misc{qwen3technicalreport,

title={Qwen3 Technical Report},

author={Qwen Team},

year={2025},

eprint={2505.09388},

primaryClass={cs.CL}

}

本文内容严格基于 Qwen 官方技术文档,最新信息请访问:

GitHub 项目主页 |

技术文档中心 |

Hugging Face 模型页