当多模态遇上闪电猫:深入解读美团 LongCat-Flash-Omni

核心问题:

一款能同时理解文字、图像、音频、视频,并实现实时交互的模型,究竟是怎样被构建出来的?美团的 LongCat-Flash-Omni 给出了一个令人惊叹的答案。

一、从单一模态到全模态:LongCat-Flash-Omni 的诞生

在过去几年里,人工智能经历了从语言模型(LLM)到多模态模型的跃迁。

但“多模态”并不只是把图像、语音和文字拼在一起,而是要让模型真正理解世界的多维信息,并能在不同模态间实时对话。

LongCat-Flash-Omni 正是这种愿景的产物。

它由美团 LongCat 团队研发,参数规模高达 5600 亿(560B),其中 激活参数为 270 亿(27B)。

这意味着它不仅强大,而且能高效运行。

模型的最大亮点在于:

-

具备**全模态(Omni-modal)**能力,覆盖文本、语音、图像、视频四大领域; -

支持实时音视频交互,能听、能看、能说; -

采用Shortcut-connected MoE(专家混合)架构,做到性能与速度兼得。

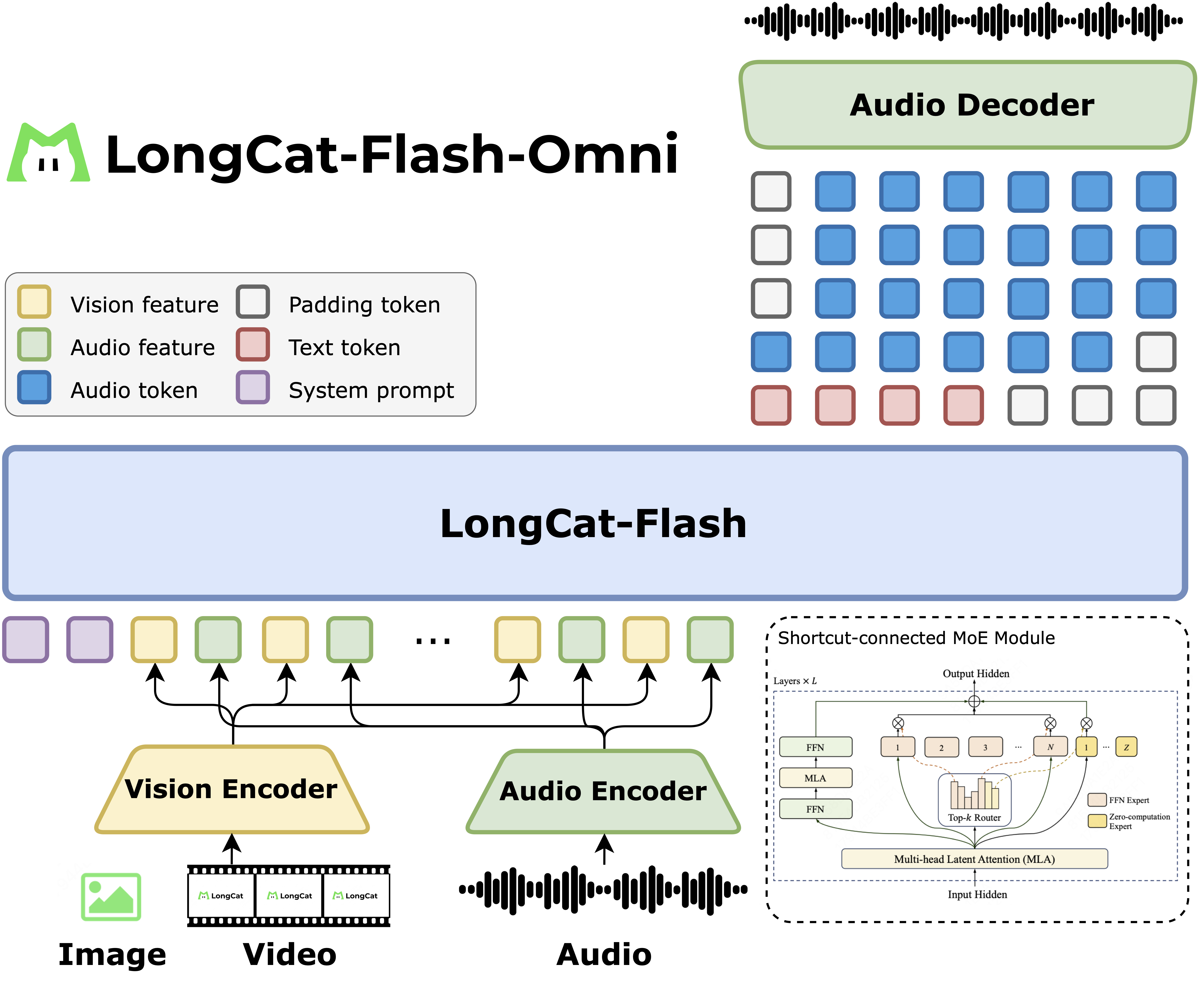

二、模型架构:一张图看懂 LongCat-Flash-Omni

图片来源:Meituan LongCat 团队

LongCat-Flash-Omni 的设计思路是:一个统一的智能体,处理所有模态输入。

核心结构基于 LongCat-Flash 的 Mixture-of-Experts(MoE) 架构,并引入零计算专家(Zero-Computation Experts)提升计算效率。

主要组成模块:

| 模块 | 功能说明 |

|---|---|

| 文本编码器(Text Encoder) | 负责语言理解与生成,是模型思考的核心。 |

| 视觉编码器(Vision Encoder) | 解析图像和视频帧,实现场景理解、图文匹配、图表识别等功能。 |

| 音频模块(Audio Encoder / Speech Reconstruction) | 提供语音识别与语音合成能力,支持实时语音聊天。 |

| 跨模态融合层(Fusion Layer) | 将多种模态嵌入特征融合,形成统一的认知表示。 |

| 专家混合层(MoE Layer) | 不同任务调用不同专家模块,大幅降低计算量。 |

反思:

传统多模态模型往往在“通用性”与“性能”之间取舍。

LongCat-Flash-Omni 通过模块解耦与专家路由机制,实现了“既全能又高效”的平衡。

三、四大核心技术特性

🌟 1. 统一的全模态智能(Unified Omni-Modal Intelligence)

LongCat-Flash-Omni 不只是“能看图”“能听音”,而是真正实现了跨模态理解与推理。

模型能在图像、语音、文本等多种输入中寻找逻辑关联,完成复杂的多模态问答。

举例来说,它能:

-

看懂一段视频并回答人物行为; -

听完语音后用自然语言总结; -

对图表截图进行内容提取并生成文字解释。

这让它在“全模态交互”任务中表现领先,例如在 OmniBench、DailyOmni 等基准中取得高分。

🌟 2. 大规模、低延迟的音视频交互

核心问题: 模型如何做到在多模态输入下保持低延迟?

答案在于其分块特征交错机制(Chunk-wise Feature Interleaving)。

它将音频与视觉特征分块处理,在保持流式处理的同时减少延迟。

结果:

-

支持最长 128K Token 上下文窗口; -

可实现多轮对话与长时记忆; -

在实时语音对话、视频描述等任务上流畅自然。

这使得它不仅适用于实验研究,更能直接落地在语音助手、AI 视频剪辑、在线教育等场景中。

🌟 3. 早期融合训练策略(Early-Fusion Training)

传统多模态模型往往后期再进行模态融合,而 LongCat-Flash-Omni 采用了多阶段、早期融合的预训练策略:

-

先独立训练单模态(文本 / 语音 / 图像); -

然后逐步混合不同模态样本; -

最终以统一任务目标进行联合训练。

这种“课程式学习”保证了:

-

各模态性能不退化; -

融合后模型表现稳定; -

数据分布更均衡。

🌟 4. 高效的训练基础设施

团队提出了新的训练框架:模态解耦并行(Modality-Decoupled Parallelism)。

这是一种适配多模态大模型的分布式策略,使不同模态模块在多机多卡环境下独立并行训练,大幅提升吞吐量。

作者见解:

这一创新不仅优化了算力利用,还为未来的“多智能体协同训练”提供了启发。

模型不再是一个单体,而是一个可扩展的多模态生态。

四、多模态评测结果:实力数据说话

LongCat-Flash-Omni 在多模态任务中表现稳健,以下节选部分核心基准结果(来自官方报告)。

1. 全模态基准(Omni-Modality)

| Benchmark | LongCat-Flash-Omni | Gemini-2.5-Pro | Qwen3-Omni |

|---|---|---|---|

| OmniBench | 61.38 | 66.80 | 58.41 |

| WorldSense | 60.89 | 63.96 | 52.01 |

| DailyOmni | 82.38 | 80.61 | 69.33 |

在 DailyOmni(日常多模态推理)中,LongCat-Flash-Omni 超越其他开源模型,展现了强大的跨模态理解力。

2. 视觉理解(Image / Video)

在 MMBench、RealWorldQA、ChartQA 等任务上,模型展现了接近商业模型(如 Gemini、GPT-4o)的表现。

| 类型 | LongCat-Flash-Omni | GPT-4o | Qwen3-Omni |

|---|---|---|---|

| MMBench-ZH | 88.7 | 82.8 | 86.4 |

| ChartQA | 87.6 | 74.5 | 86.8 |

| VideoMME(含音频) | 78.2 | – | 73.0 |

总结:

在视频与图像结合的复杂场景中,LongCat-Flash-Omni 拥有稳定的视觉语义理解与时间推理能力。

3. 音频理解与语音生成

在 语音识别(ASR) 与 语音理解(Audio Understanding) 任务中,模型表现突出。

| Benchmark | LongCat-Flash-Omni | GPT-4o-Audio | Qwen3-Omni |

|---|---|---|---|

| AISHELL-1 | 0.63 | 34.81 | 0.84 |

| ClothoAQA | 72.83 | 61.87 | 75.16 |

| VocalSound | 92.76 | 82.37 | 91.60 |

在中文语音识别任务(AISHELL)上,误差率仅 0.63%,达到业界顶级水准。

4. 语言与代码任务表现

LongCat-Flash-Omni 在语言、推理与代码生成方面同样表现优异。

| Benchmark | LongCat-Flash-Omni | DeepSeek-V3.1 | GPT-4.1 |

|---|---|---|---|

| MMLU | 90.3 | 90.9 | 89.6 |

| MATH500 | 97.6 | 96.1 | 90.6 |

| Humaneval+ | 90.85 | 92.68 | 93.29 |

这表明该模型不仅擅长感知,也拥有强大的逻辑与数学推理能力。

五、从下载到部署:五分钟上手

核心问题: 如何在本地或集群上运行 LongCat-Flash-Omni?

1. 环境准备

conda create -n longcat python=3.10

conda activate longcat

依赖要求:

-

Python ≥ 3.10 -

PyTorch ≥ 2.8 -

CUDA ≥ 12.9

2. 安装 SGLang 开发分支

git clone -b longcat_omni_v0.5.3.post3 https://github.com/XiaoBin1992/sglang.git

pushd sglang

pip install -e "python"

popd

3. 下载模型权重

pip install -U "huggingface_hub[cli]"

huggingface-cli download meituan-longcat/LongCat-Flash-Omni --local-dir ./LongCat-Flash-Omni

4. 启动 Demo

单节点推理:

python3 longcat_omni_demo.py \

--tp-size 8 \

--ep-size 8 \

--model-path ./LongCat-Flash-Omni \

--output-dir output

多节点推理:

python3 longcat_omni_demo.py \

--tp-size 16 \

--ep-size 16 \

--nodes 2 \

--node-rank $NODE_RANK \

--dist-init-addr $MASTER_IP:5000 \

--model-path ./LongCat-Flash-Omni \

--output-dir output

提示:请将

$NODE_RANK和$MASTER_IP替换为实际 GPU 集群信息。

六、交互体验:让 AI 听见、看见、回应

LongCat-Flash-Omni 的交互能力可通过两种方式体验:

-

网页版:https://longcat.ai

目前支持语音对话功能。 -

移动端 App:

-

Android 用户可扫码下载; -

iOS 用户可在中国区 App Store 搜索 “LongCat”。

-

作者感悟:

当一个模型能“看到你在做什么”,还能“听到你在说什么”并自然回应时,AI 的交互边界正被重新定义。

LongCat-Flash-Omni 不是在模拟人类,而是在重构理解的方式。

七、使用与合规须知

模型权重遵循 MIT License,可自由使用与修改,但需注意:

-

不得用于违反隐私、安全或法律的场景; -

商业使用需遵守 Meituan 的商标与专利限制; -

在高风险领域部署前,应进行安全与准确性评估。

八、实用摘要 / 一页速览

| 模块 | 说明 |

|---|---|

| 模型名称 | LongCat-Flash-Omni |

| 类型 | 开源全模态大模型(文本 + 视觉 + 语音 + 视频) |

| 参数量 | 560B(激活 27B) |

| 上下文长度 | 128K Tokens |

| 亮点 | 实时音视频交互、早期融合训练、模态解耦并行 |

| 性能 | 多模态基准全面领先,中文语音识别误差率 0.63% |

| 开源协议 | MIT |

| 体验入口 | https://longcat.ai |

九、常见问题(FAQ)

Q1:LongCat-Flash-Omni 是否开源?

A:是的,模型与技术报告均已在 GitHub 与 Hugging Face 全面开源。

Q2:运行模型需要多大算力?

A:FP8 权重需至少 8×H20-141G 显卡节点;BF16 模式建议两节点(16×H800-80G)。

Q3:是否支持中文语音与文字?

A:完全支持,且在中文语音识别上表现卓越(AISHELL-1 误差率 0.63%)。

Q4:SGLang 官方版本支持吗?

A:目前需使用 LongCat 团队提供的开发分支,未来将并入正式版。

Q5:是否可商用?

A:模型权重为 MIT 许可,可自由使用,但不得侵犯商标与专利权。

Q6:有移动端体验方式吗?

A:可在 longcat.ai 体验网页版,或通过 App Store / 安卓扫码下载。

Q7:模型是否具备安全限制?

A:团队提醒用户需遵守相关法律法规,特别是在高风险或敏感场景下。

🏁 结语

LongCat-Flash-Omni 的发布,标志着多模态智能进入“实时理解与生成”的新阶段。

它让机器不再只是“阅读世界”,而是能“感知世界”。

在未来的交互时代,LongCat-Flash-Omni 或许会成为“通用智能”的关键基石。

而这只闪电猫,正在以更快的速度,连接人类与世界的新接口。