LLM Review:借助盲态同行评审提升大语言模型的创意写作能力

在自然语言处理领域,大语言模型(LLMs)早已不是陌生的存在——从日常的智能对话到专业的文本总结,从逻辑推理任务到多智能体协作系统,LLMs展现出了极强的适配性。但当我们把目光投向创意写作,比如科幻小说创作这类需要独特视角和新颖构思的场景时,LLMs却暴露出明显的短板:要么单模型生成的内容陷入“套路化”怪圈,要么多智能体协作反而让内容趋于同质化。如何让LLMs在借助协作优势的同时,保住创意的“独特性”?本文将深入拆解LLM Review这一创新框架,以及配套的评估体系,解答大模型创意写作的核心痛点。

一、大模型创意写作的核心悖论:协作反而限制创造力?

想要解决问题,首先要认清问题的本质。在创意写作场景中,LLMs面临的困境主要分为两类,而多智能体协作的“双刃剑效应”更是让问题变得复杂。

1.1 单智能体LLM的创意瓶颈:只会“复刻”,不会“创造”

单一大语言模型进行创意写作时,最大的问题是缺乏实质性的概念新颖性。尽管我们可以通过解码策略、提示词工程、后训练优化等方式,让生成内容在表面上看起来更多样,但这些方法只能带来“表层多样性”——模型依然倾向于复刻熟悉的语言模式和叙事框架,难以产出真正跳出固有认知的创意内容。

比如在科幻写作中,单LLM生成的故事往往离不开“外星入侵”“时空穿越”等经典套路,人物设定和世界观构建也高度雷同,这是因为模型的训练数据决定了它更倾向于“安全”的、已被验证的表达,而非冒险探索全新的创意轨迹。

1.2 多智能体协作的悖论:交互越多,创意越趋同

既然单智能体有局限,那多智能体协作是不是能解决问题?答案并非如此。

现有多智能体框架(比如辩论、讨论式协作)原本是为提升推理准确性设计的,这类框架默认“更多交互=更好结果”,但在创意写作中,这个假设完全不成立:

-

从人类创意研究来看,群体头脑风暴中,过度的实时交互会导致“生产阻塞”和“收敛倾向”——成员会不自觉地模仿他人的思路,最终产出的想法数量更少、原创性更低; -

从LLM协作实践来看,智能体之间反复暴露彼此的实时修订内容,会让模型不自觉地向同伴的表达对齐,最终导致内容同质化,反而扼杀了创意的“发散性”。

核心结论很明确:提升LLM的创意写作能力,关键不是增加交互次数,而是优化信息流动的规则——创意需要“发散性”,要让每个智能体保留独立的创作轨迹,而非强制对齐。

二、LLM Review:用“盲态同行评审”重构多智能体交互逻辑

针对上述痛点,研究人员借鉴学术领域的“双盲同行评审”机制,设计了LLM Review框架。核心思路是:约束信息流动,而非最大化信息流动,让智能体既能获得外部反馈,又能保留独立的创意轨迹。

2.1 LLM Review的核心设计灵感:盲态同行评审

学术领域的双盲评审,核心是“评审者和作者互不知情,仅基于内容给出反馈”,这一机制能避免偏见,聚焦内容本身。LLM Review将这一思路落地到多智能体协作中,核心是“反馈可见,修订不可见”——智能体之间可以点评彼此的初稿,但看不到对方基于反馈做出的修订,从而避免创意趋同。

2.2 LLM Review的三步核心流程(附对比)

LLM Review的执行流程清晰且易落地,我们先拆解具体步骤,再对比其他多智能体框架的差异:

步骤1:独立创作(Compose)

3个writer智能体(固定数量)各自被分配一个专属人设(比如人文主义作家、未来主义作家、生态主义作家),基于同一个科幻写作提示词,独立完成约300字的初始故事初稿。

-

关键:人设全程固定,且所有智能体仅参考提示词和自身人设,无任何交互。

步骤2:盲态评审+独立修订(Review)

-

评审阶段:每个智能体对其他两个智能体的初稿进行针对性点评,反馈聚焦5个核心维度——原创性、世界观构建潜力、思辨逻辑一致性、意象丰富度、人物深度; -

修订阶段:每个智能体仅基于“自己的初稿+收到的反馈”进行修订,完全看不到其他智能体的修订版本。

步骤3:输出最终版本

每个智能体输出独立修订后的故事,最终可整合多版本优势,也可保留单版本的独特性。

2.3 LLM Review与其他多智能体框架的核心差异

为了更清晰地理解LLM Review的优势,我们对比目前主流的多智能体创意写作框架:

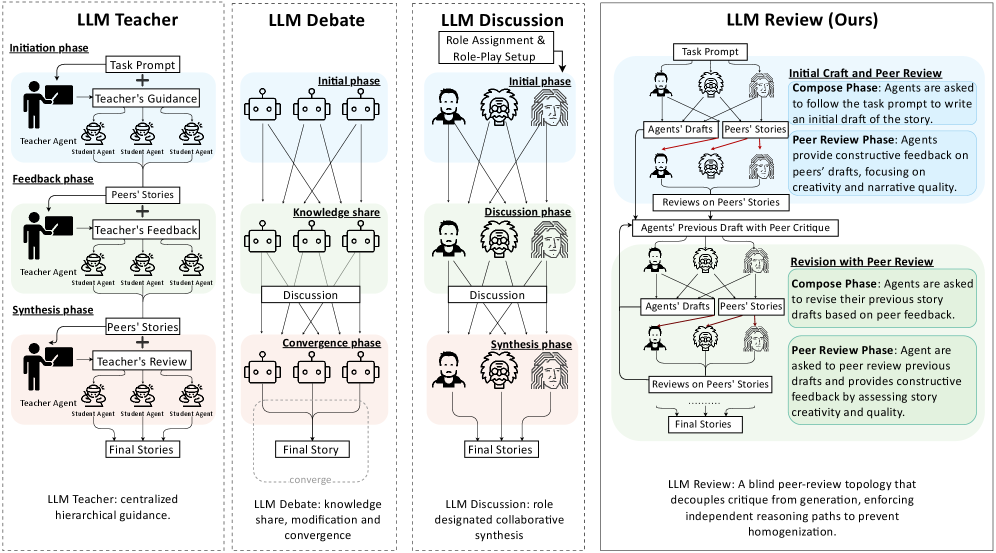

图1:从单智能体到多智能体框架的交互逻辑对比,LLM Review通过盲态评审实现“反馈有用,创意独立”

三、SciFi-100:首个针对LLM科幻写作的专属评估数据集

要验证LLM Review的效果,首先需要一套能精准评估“创意写作质量”的数据集——通用数据集无法覆盖创意写作的核心维度,因此研究人员构建了SciFi-100数据集,这也是首个专为LLM科幻写作评估设计的数据集。

3.1 为什么需要专属的科幻写作数据集?

创意写作的评估需要兼顾“叙事逻辑”“世界观构建”“人物深度”等多个维度,通用的文本生成数据集(比如新闻、对话数据集)完全无法适配:

-

通用数据集聚焦“正确性”“流畅度”,而创意写作需要评估“新颖性”“思辨性”; -

科幻写作有其专属的核心维度(比如科学概念融合、伦理哲学主题),通用数据集无法覆盖。

3.2 SciFi-100的构建流程(可复现)

SciFi-100的构建遵循“理论指导+模型生成+人工筛选”的三步法,确保数据集的多样性和针对性:

-

确定核心评估维度:基于叙事学、文学理论、创意写作教学的核心理论,梳理出10个科幻写作的核心维度(比如科学概念落地、人物弧光、世界观沉浸感等); -

生成初始提示词:针对每个维度,用LLM生成20个独特的科幻写作提示词(聚焦“能展开完整叙事的场景”),总计200个初始提示词; -

人工筛选与修订:对200个提示词进行人工审核,筛选出主题多样、逻辑完整、适合创意发挥的提示词,最终每个维度保留10个,总计100个(即SciFi-100)。

3.3 SciFi-100的核心价值

SciFi-100的意义不仅是“提供100个科幻写作提示词”,更在于它搭建了一套平衡的创意评估基础:数据集覆盖科幻写作的全核心维度,能全面检验LLM在不同创意场景下的表现,避免因提示词单一导致的评估偏差。

四、全方位创意评估体系:不止“好不好”,更要“新不新”

评估创意写作的难度在于“创意的主观性”——如何把“主观的创意”转化为“可量化的指标”?研究人员设计了三层评估体系,兼顾“质量”和“新颖性”,让评估结果既符合人类直觉,又有客观数据支撑。

4.1 LLM-as-a-Judge:让GPT-4o当“专业评委”

LLM具备逼近人类判断的能力,因此研究人员选择GPT-4o作为“评委”,对生成的科幻故事进行量化评分,核心规则如下:

评估维度(贴合科幻写作核心)

评分规则

-

每个维度采用0-5分制:0分代表内容存在抄袭嫌疑且质量极差,5分代表内容高度原创且质量优异; -

为避免评分波动,每篇故事在每个维度上评分3次,最终取平均分,确保结果的稳定性。

4.2 人工评估:验证LLM评委的可靠性

为了确保LLM-as-a-Judge的评分符合人类偏好,研究人员补充了人工评估环节:

-

招募9名学生标注员,针对LLM Review框架+Llama-3.2-3B模型生成的SciFi-100故事进行评分; -

标注员使用和GPT-4o完全相同的5个维度、0-5分制,对每篇故事打分; -

对每个维度的9个评分取平均值,得到“人类共识分数”,用于验证LLM评分的一致性。

这一步的核心价值是“交叉验证”——避免LLM评委因自身偏见给出偏离人类直觉的分数,让评估结果更可信。

4.3 规则化评估:量化“新颖性”,告别主观判断

除了“质量评分”,创意写作的核心是“新颖性”——如何衡量生成内容是否跳出了经典套路?研究人员设计了三套规则化指标,以1003本经典科幻小说组成的SFGram语料库为参考,从“绝对多样性”“词汇新颖性”“语义新颖性”三个维度量化新颖性。

4.3.1 绝对多样性:用“意外度”衡量内容的“非套路化”

绝对多样性聚焦“生成内容本身的独特性”,用token级平均意外度(surprisal) 来衡量,公式如下:

S_{\text{avg}}=-\frac{1}{L}\sum_{j=1}^{L}\log p(x_{j}\mid x_{<j})$$

用通俗的话解释:

– $x_j$ 是生成文本中第j个token(可以理解为“词”);

– $p(x_j|x_{<j})$ 是模型基于前文,预测这个token出现的概率;

– 概率越低,$\log p(x_j|x_{<j})$ 的值越负,取反后数值越大,代表这个token越“出乎意料”;

– 对所有token的意外度取平均值(除以长度L),就是整段文本的平均意外度——数值越高,说明内容越不套路,固有模式的痕迹越轻。

#### 4.3.2 词汇分歧度:和经典科幻语料库比“用词差异”

词汇分歧度聚焦“词汇层面的新颖性”,用**KL散度** 计算生成文本与SFGram经典语料库的词汇分布差异,公式如下:

关键解读:

-

是SFGram语料库中“单个词”的出现概率(单字分布); -

是生成文本中“单个词”的出现概率; -

KL散度数值越大,说明生成文本的词汇分布和经典科幻小说的差异越大,词汇层面的新颖性越高; -

为避免“零概率”问题,计算时会加入“加性平滑”,保证数值稳定性。

4.3.3 语义分歧度:和经典科幻语料库比“意思差异”

词汇分歧度只看“用词”,语义分歧度则看“表达的意思”,分为两个指标:

(1)近邻语义相似度(反向衡量新颖性)

步骤如下:

-

用all-mpnet-base-v2模型(Sentence Transformers系列),将SFGram语料库拆成250词左右的片段,生成每个片段的语义嵌入; -

同样生成待评估故事的语义嵌入; -

计算故事嵌入与所有语料库片段嵌入的余弦相似度:

\text{Cosine Similarity}=\frac{\mathbf{u}\cdot\mathbf{v}}{\|\mathbf{u}\|\|\mathbf{v}\|}$$

4. 取最大相似度值,用“1 – 最大相似度”作为“语义新颖性分数”——数值越大,说明故事的核心语义和经典科幻的差异越大。

##### (2)嵌入体积增益:衡量语义空间的“拓展性”

这个指标聚焦“生成内容是否拓展了经典科幻的语义边界”,公式如下:

通俗解读:

-

是SFGram语料库嵌入的协方差矩阵,代表经典科幻的语义空间“体积”; -

是语料库+生成故事嵌入的协方差矩阵; -

两者的对数行列式差值,就是“体积增益”——数值越大,说明生成故事让科幻语义空间的覆盖范围更广,语义新颖性越高; -

为避免数值不稳定,计算时会给协方差矩阵加一个小的(单位矩阵)。

4.4 规则化评估的注意事项

需要明确的是,规则化指标主要衡量“多样性和新颖性”,而非“内容质量”——比如高意外度可能是“创意新颖”,也可能是“逻辑混乱”。因此,规则化指标必须和LLM-as-a-Judge的质量评分结合使用,才能全面评估创意写作能力。

五、实验结果:LLM Review的表现到底有多好?

理论和方法最终要靠结果验证。研究人员将LLM Review与单智能体、LLM Teacher、LLM Debate、LLM Discussion等框架对比,在SciFi-100数据集上的核心结果如下(核心数据节选):

核心结论可以总结为三点:

-

LLM Review全面超越基线:在质量维度(LLM-as-a-Judge评分)和新颖性维度(规则化指标),LLM Review均显著优于单智能体和其他多智能体框架; -

小模型也能超越大模型:搭配LLM Review框架后,中小规模模型(比如Llama-3.2-3B)的创意写作能力,能超过更大规模的单智能体模型; -

交互结构比模型规模更重要:提升创意写作能力,不必一味追求“更大的模型”,优化多智能体的信息流动规则,能以更低的成本实现更好的效果。

六、核心价值与实践启示

LLM Review框架和配套的评估体系,不仅解决了大模型创意写作的核心痛点,还为相关领域的实践提供了关键启示:

6.1 对技术研发的启示:信息流动“约束”比“放任”更重要

多智能体系统的设计,不能一概而论“越多交互越好”——针对创意类任务,关键是“保留发散性”。LLM Review的盲态评审机制,本质是通过“信息不对称”(只看初稿反馈,不看修订内容),让每个智能体的创意轨迹不被干扰,这为其他创意类任务(比如诗歌创作、广告文案生成)提供了可复用的思路。

6.2 对落地应用的启示:中小模型也有“用武之地”

在大模型研发成本居高不下的当下,LLM Review证明:交互结构的优化,可以替代部分模型规模的优势。对于中小企业或研发资源有限的团队,不必追求部署超大模型,而是可以通过优化多智能体交互规则,让中小模型在创意写作场景中达到甚至超越大模型的效果。

6.3 对评估体系的启示:创意评估需要“多维度融合”

SciFi-100数据集+“LLM评委+人工验证+规则化指标”的评估体系,解决了创意写作“评估难”的问题——既避免了纯主观评分的偏差,又避免了纯规则化指标的片面性,这套评估思路可以迁移到其他创意类任务的评估中。

七、FAQ:解答你最关心的问题

Q1:为什么多智能体协作会让LLM的创意变弱?

A:核心原因是“收敛倾向”。现有多智能体框架中,智能体实时暴露彼此的修订内容,模型会不自觉地向同伴的表达对齐,就像人类群体头脑风暴中,成员会模仿他人思路一样。最终,智能体的创意轨迹从“发散”变成“收敛”,内容自然趋于同质化。

Q2:LLM Review和普通的多智能体讨论有什么本质区别?

A:最核心的区别是“信息流动的规则”:普通多智能体讨论中,智能体能看到彼此的实时修订内容,而LLM Review中,智能体只能看到同伴的初稿和反馈,看不到修订后的内容。这种“盲态修订”保留了每个智能体的独立创意轨迹,既利用了外部反馈优化质量,又避免了创意趋同。

Q3:SciFi-100数据集只适合科幻写作评估吗?

A:并非如此。SciFi-100的核心价值是“覆盖创意写作的全核心维度”(比如人物深度、世界观构建、主题思辨性),这些维度同样适用于其他创意写作场景(比如奇幻小说、散文创作)。只需替换提示词的主题,就能将数据集适配到其他创意写作评估中。

Q4:规则化评估里的“嵌入体积增益”到底怎么理解?

A:可以把经典科幻语料库的语义嵌入想象成一个“气球”,这个气球的大小代表经典科幻的语义覆盖范围。“嵌入体积增益”就是看生成的故事嵌入加入后,这个“气球”变大了多少——数值越大,说明故事的语义内容越超出经典科幻的边界,新颖性越高。

Q5:小模型用LLM Review能超过大模型,这对实际应用有什么意义?

A:实际应用中,大模型的部署成本(算力、存储、授权)远高于中小模型。LLM Review证明,通过优化交互结构,中小模型可以在创意写作场景中达到大模型的效果,这意味着企业可以用更低的成本实现高质量的创意内容生成,降低技术落地的门槛。

总结

LLM Review的出现,打破了“多智能体交互越多,创意越好”的固有认知,证明了“信息流动的约束”才是提升大模型创意写作能力的关键。配套的SciFi-100数据集和多维度评估体系,也为创意写作的“量化评估”提供了可行方案。未来,随着这类“精准交互”框架的优化,大语言模型有望真正从“内容生成工具”升级为“创意协作伙伴”,在更多创意领域释放价值。