深夜,你面对着一个复杂难解的bug,咖啡已经凉了第三回,而截止日期就在明天早上。这种场景对每个开发者都不陌生——直到现在。

在软件开发的世界里,我们一直在寻找那个能够真正理解我们意图的智能助手。不是简单的代码补全,不是机械的模式匹配,而是一个能够真正参与思考、理解上下文、甚至主动发现问题的合作伙伴。

今天,这个愿景向前迈进了一大步。

代码智能的新里程碑:从助手到合作伙伴

想象一下,一个能够理解你模糊的需求描述、自动调用合适的工具、在几轮对话内交付完整功能的AI伙伴。这不再是科幻场景——快手AI团队开源的KAT-Dev-32B和其旗舰版本KAT-Coder正在将这个愿景变为现实。

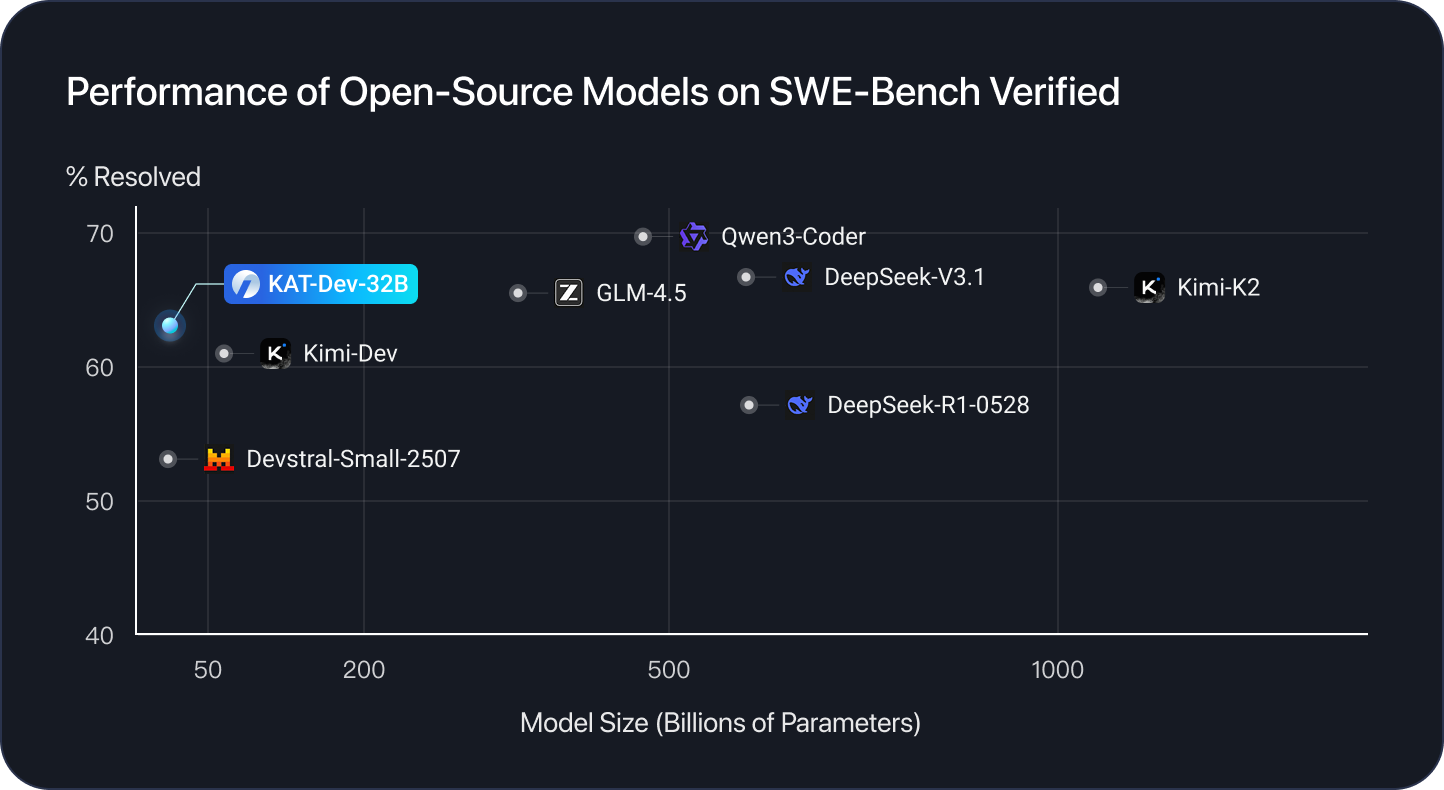

KAT-Dev-32B作为开源社区的新成员,在SWE-Bench Verified基准测试中取得了62.4%的解决率,在所有开源模型中排名第五。而其大哥KAT-Coder更是达到了惊人的73.4%,标志着代码智能模型正式进入了实用化阶段。

但数字背后的故事更值得关注:这些模型不是通过简单的规模扩展实现的突破,而是通过一种全新的训练范式——可扩展的智能体强化学习(Agentic RL)。

三阶段训练:从基础能力到自主智能

中期训练:打好智能体的基本功

传统的代码模型训练往往直接从代码数据开始,但KAT团队发现了一个关键洞察:基础能力决定天花板。

在中期训练阶段,他们为模型注入了六种核心能力:

-

工具使用能力:在沙盒环境中构建了数千个工具的真实交互数据 -

多轮对话理解:构建了长达数百轮的人-助手-工具三方对话 -

领域知识注入:融入了高质量的编程专业知识 -

真实开发流程:整合了大量Git仓库的Pull Request数据 -

指令遵循:收集了30多个类别的常见用户指令 -

通用推理能力:强化了通用领域的推理和问题解决能力

“这就像在教一个实习生,”团队在技术报告中比喻道,“先让他们熟悉所有工具和工作流程,而不是直接扔给他们一个项目。”

监督微调:从理论到实践

有了基础能力,接下来就是实战训练。团队精心设计了八个任务类型和八大编程场景,确保模型能够应对真实世界的复杂性。

八大任务类型覆盖了开发全生命周期:

-

功能实现与增强 -

Bug修复与重构 -

性能优化与测试用例生成 -

代码理解与配置部署

八大编程场景确保专业覆盖:

-

应用开发与UI/UX工程 -

数据科学与机器学习 -

数据库系统与基础设施 -

专业领域编程与安全工程

这种全面的覆盖确保了模型不会在特定领域表现出色而在其他领域掉链子。

强化微调:驾校教练的温柔引导

这是KAT训练流程中最创新的环节之一。在传统的强化学习之前,他们加入了一个RFT(强化微调)阶段。

想象一下学开车:拿到驾照后,你不会直接上高速公路,而是有一个经验丰富的教练坐在副驾驶。RFT就是这个教练。

通过引入人工工程师标注的”教师轨迹”,模型在开始自主探索之前就获得了正确的行为示范。这种方法不仅提升了性能,更重要的是显著稳定了后续的RL训练。

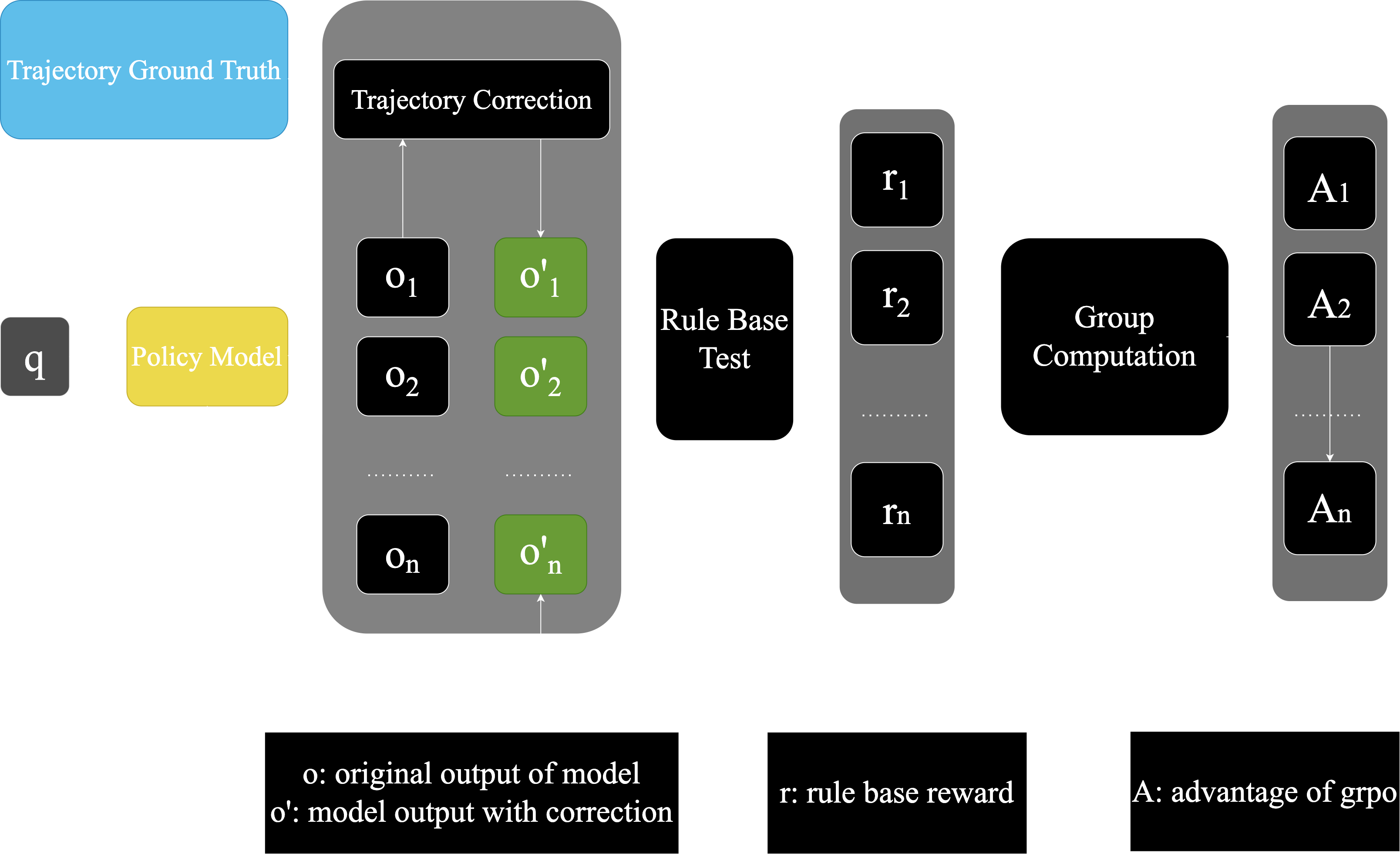

Agentic RL Scaling:智能体训练的技术革命

如果说前三阶段是打好基础,那么Agentic RL Scaling就是让模型真正”开窍”的关键。

三大挑战与优雅解决方案

扩展智能体强化学习面临三个核心挑战,而KAT团队为每个挑战都找到了创新的解决方案:

1. 非线性轨迹历史的学习效率

-

解决方案:前缀缓存机制,避免重复计算

2. 内在模型信号的充分利用

-

解决方案:基于熵的轨迹剪枝,保留信息量最大的节点

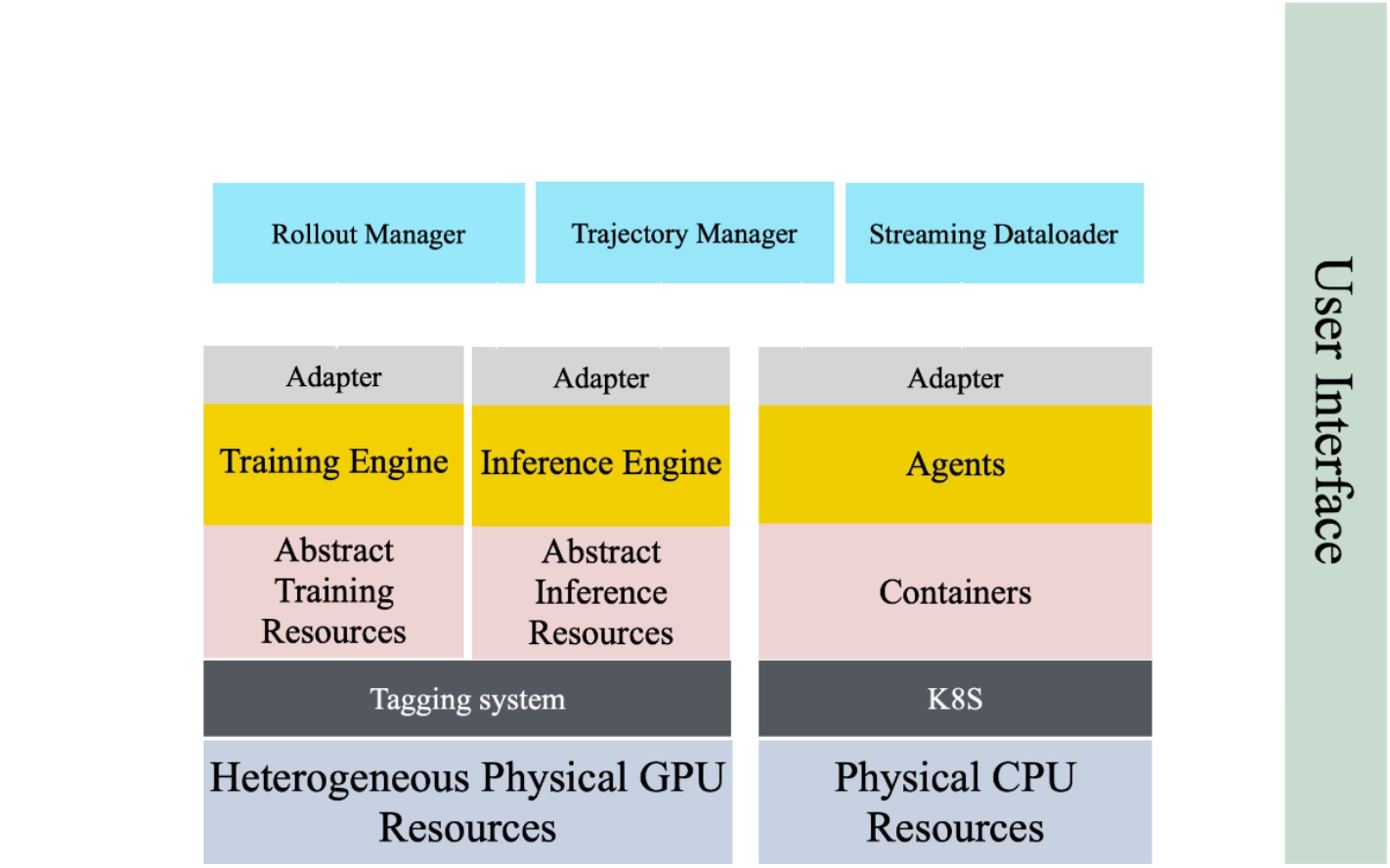

3. 高吞吐基础设施的构建

-

解决方案:SeamlessFlow架构,实现智能体与训练的完全解耦

基于熵的树剪枝:智能训练的核心算法

即使有了上述技术,在整个树结构中训练所有token仍然成本高昂。团队开发了一种基于熵的剪枝机制:

“我们像园丁修剪果树一样修剪轨迹树,”技术负责人解释说,”只保留那些最能结果实的枝条。”

具体来说,他们将轨迹压缩为前缀树,每个节点代表共享前缀,每个边对应token片段。在固定计算预算下,系统基于熵信号和到达可能性估计节点的信息量,按重要性顺序扩展节点直到预算耗尽。

真实世界数据:从开源到企业级代码库

与仅在GitHub公开仓库上训练的模型不同,KAT团队走得更远。除了开源数据,他们还收集并利用了来自真实工业系统的企业级代码库。

“公开仓库往往包含较简单的项目,”团队指出,”而这些大规模、复杂的代码库——跨越多种编程语言并代表真实业务逻辑——让模型接触到显著更具挑战性的开发场景。”

这种对真实世界复杂性的暴露,是模型能够在工业环境中表现出色的关键。

如何开始使用KAT:从开源到生产环境

方案一:拥抱开源——KAT-Dev-32B

对于大多数开发者和研究者,KAT-Dev-32B提供了最佳的入门路径。模型已在Hugging Face上完全开源:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Kwaipilot/KAT-Dev"

# 加载tokenizer和模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 准备模型输入

prompt = "实现一个Python函数,计算斐波那契数列的第n项"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 生成代码

generated_ids = model.generate(

**model_inputs,

max_new_tokens=512

)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

content = tokenizer.decode(output_ids, skip_special_tokens=True)

print("生成的代码:", content)

对于需要更高性能的场景,可以使用vLLM进行服务化部署:

MODEL_PATH="Kwaipilot/KAT-Dev"

vllm serve $MODEL_PATH \

--enable-prefix-caching \

--tensor-parallel-size 8 \

--tool-parser-plugin $MODEL_PATH/qwen3coder_tool_parser.py \

--chat-template $MODEL_PATH/chat_template.jinja \

--enable-auto-tool-choice --tool-call-parser qwen3_coder

方案二:极致性能——KAT-Coder API

对于企业用户和需要顶级性能的开发者,KAT-Coder通过StreamLake平台提供API服务:

# 安装Claude Code客户端

npm install -g @anthropic-ai/claude-code

# 配置API端点(替换为你的Endpoint ID和API Key)

export ANTHROPIC_BASE_URL=https://wanqing.streamlakeapi.com/api/gateway/v1/endpoints/ep-xxx-xxx/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=你的API_KEY

团队还推荐使用claude-code-router——一个第三方路由工具,可以灵活地在不同后端API之间切换。

涌现行为:当模型开始”思考”

在Agentic RL Scaling过程中,团队观察到了一些令人惊喜的涌现行为:

多轮交互减少32%

经过RL训练后,模型完成任务所需的平均交互轮次比SFT后模型减少了近三分之一。”这就像模型学会了直达问题核心,”研究人员评论道,”它不再需要那么多来回确认。”

并行工具调用

更令人印象深刻的是,模型开始展示出并行调用多个工具的能力,突破了传统的顺序调用模式。

团队从理论角度解释了这一现象:在轨迹树结构中,并行工具调用创造了额外的分支可能性。这些分支在训练中被独立处理,同时长时熵剪枝机制会保留信息量更大的节点——而多工具调用节点通常具有更高的熵值。

真实世界案例:从概念到实现

星空动画生成

通过简单的描述,KAT-Coder能够生成完整的星空动画代码,包括粒子系统、运动轨迹和交互逻辑。

经典游戏重构

团队测试了模型对经典游戏的重构能力——从游戏逻辑到物理引擎,从UI设计到性能优化,模型展现出了全面的理解。

未来路线图:代码智能的下一站

KAT团队的愿景远不止于此。他们的路线图包含了四个关键方向:

深度工具集成

与主流IDE、版本控制系统和开发工作流的深度集成,创造无缝的编码体验。

多语言扩展

覆盖新兴编程语言和框架,确保全面的语言支持。

协同编码系统

探索多智能体系统,让KAT模型能够在复杂软件项目中协作。

多模态代码智能

集成视觉理解能力,处理架构图、UI设计、调试截图和文档图像。

常见问题解答

Q:KAT-Dev-32B和KAT-Coder的主要区别是什么?

A:KAT-Dev-32B是开源版本,在SWE-Bench上达到62.4%解决率;KAT-Coder是闭源的旗舰版本,达到73.4%解决率,通过API提供服务。

Q:在本地运行KAT-Dev-32B需要什么配置?

A:建议使用至少80GB显存的GPU(如A100/H100),支持vLLM推理加速。对于资源有限的用户,可以考虑量化版本或使用云服务。

Q:模型支持哪些编程语言?

A:目前主要支持Python、JavaScript、Java、C++、Go等主流语言,并在持续扩展中。

Q:如何获得KAT-Coder的API访问权限?

A:通过StreamLake Wanqing平台申请API密钥,具体流程参考官方文档。

Q:模型的训练数据是否包含企业敏感代码?

A:训练使用的企业级代码库都经过严格的匿名化和脱敏处理,确保不包含任何敏感信息。

结语:开发者新时代的黎明

KAT系列模型的发布不仅仅是另一个AI模型的诞生,它标志着代码智能从简单的辅助工具向真正的智能合作伙伴的转变。通过可扩展的Agentic RL训练范式,我们看到了AI理解复杂任务、主动使用工具、甚至优化自身工作流程的能力。

正如一位早期测试者分享的体验:”它不像是在与一个工具对话,而像是在与一个理解你意图的资深开发者协作。”

在这个新时代,开发者的角色正在从代码的书写者转变为问题的定义者和解决方案的架构师。而KAT这样的智能伙伴,将帮助我们专注于创造性的工作,将重复性的编码任务交给能够理解我们意图的AI伙伴。

开始你的智能编码之旅:Hugging Face | StreamLake