OpenAI gpt-oss 模型深度解析:架构、安全与性能全面解读

引言

2025年8月5日,OpenAI 正式发布了两款开源大模型 gpt-oss-120b 和 gpt-oss-20b。这两款基于 Apache 2.0 协议许可的模型,在保持强大推理能力的同时,兼顾了可定制性和安全性。本文将深入解析这两款模型的技术细节、训练方法及评估结果,带您了解其核心优势和应用潜力。

一、模型架构与核心参数

1. 基础架构设计

gpt-oss 系列模型采用稀疏门控混合专家架构(MoE),在传统 Transformer 基础上进行了多项创新:

-

参数规模:

-

gpt-oss-120b:总参数 1168 亿,活跃参数 51 亿/Token -

gpt-oss-20b:总参数 209 亿,活跃参数 36 亿/Token -

注:参数统计方式与常规模型不同,详见表1

-

-

技术亮点:

-

残差流维度 2880 -

采用 Pre-LN 结构(前层归一化) -

混合专家数量:120b 版本 128 个,20b 版本 32 个 -

动态路由机制:每个 Token 选择 Top-4 专家

-

2. 量化技术突破

为降低模型部署门槛,OpenAI 采用了MXFP4 量化方案:

-

4.25 bits/参数 的高精度量化 -

显存优化效果: -

120b 模型可运行于单张 80GB GPU -

20b 模型最低支持 16GB 显存设备

-

二、训练数据与过程

1. 预训练阶段

-

数据规模:数万亿 Token 的纯文本数据 -

数据构成:重点覆盖 STEM、编程和通用知识领域 -

安全过滤:采用与 GPT-4o 相同的 CBRN 预训练过滤器 -

知识库时效:截止 2024 年 6 月

2. 后训练优化

采用与 OpenAI o3 类似的**思维链强化学习(CoT RL)**技术:

-

训练数据集涵盖编程、数学、科学等领域的广泛问题 -

通过”和谐对话格式”(Harmony Chat Format)实现: -

特殊标记界定消息边界 -

关键词参数定义消息角色(System/Developer/User) -

三级信息层级:System > Developer > User > Assistant > Tool

-

三、推理能力与工具使用

1. 三级推理模式

模型支持可调节推理强度:

-

低(Low):基础推理需求 -

中(Medium):中等复杂度任务 -

高(High):复杂问题深度思考

图3显示不同推理强度下的性能变化

2. 工具调用能力

支持多种智能体工具:

-

网络浏览工具:集成搜索和网页交互功能 -

Python 工具:在 Jupyter 环境中执行代码 -

自定义函数:通过 Developer 消息定义函数接口

四、基准测试结果分析

1. 核心能力评估

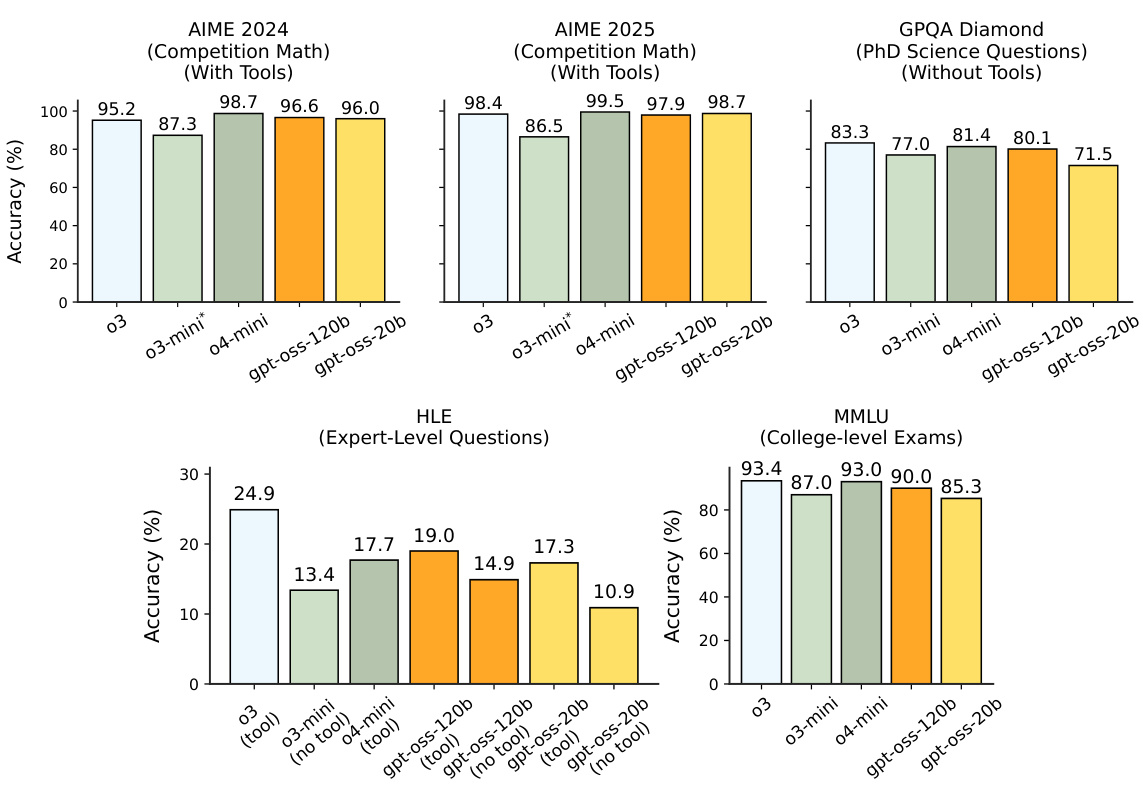

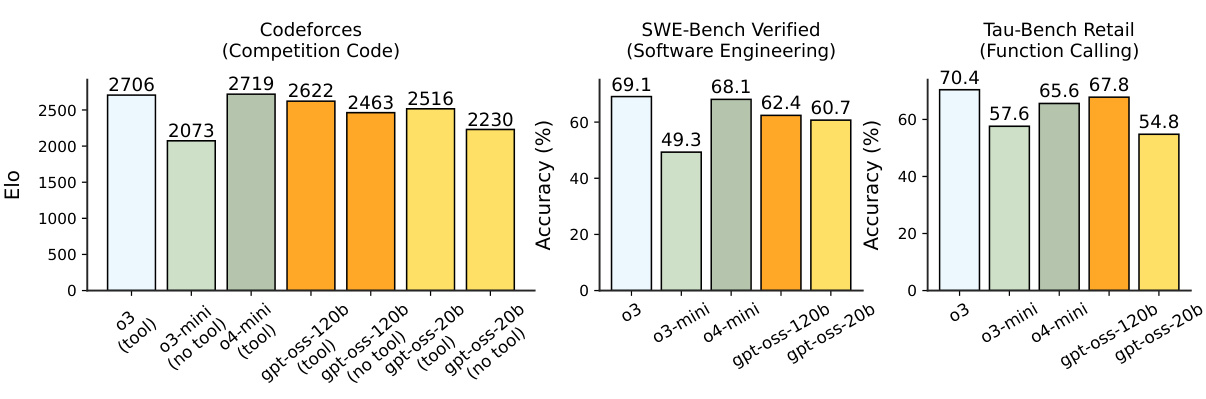

表3展示了各基准测试的详细结果,其中:

-

数学能力:在 AIME 测试中,120b 模型启用工具时准确率达 97.9% -

编程能力:Codeforces Elo 评分最高达 2622(120b+工具) -

多语言能力:MMMLU 测试中 14 种语言平均准确率 81.3%(120b 高强度模式)

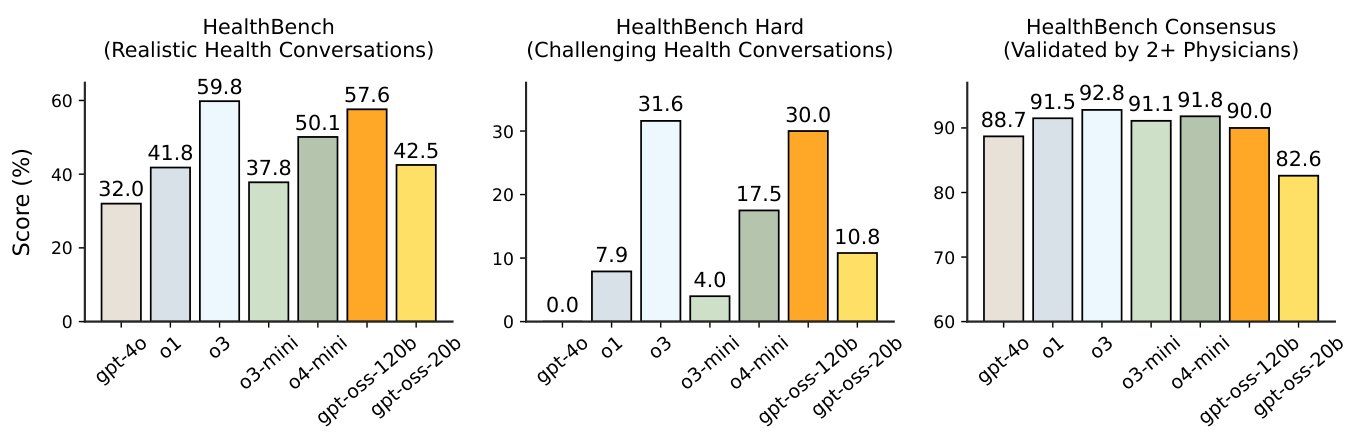

2. 医疗领域表现

HealthBench 测试显示:

-

120b 模型接近 OpenAI o3 性能 -

显著优于 GPT-4o 和 o4-mini 等模型

五、安全性能评估

1. 默认安全表现

表4-表10展示了多项安全测试结果:

-

内容过滤:生产基准测试中准确率普遍超 80% -

抗越狱能力:与 OpenAI o4-mini 相当 -

指令层级遵循:在系统/用户冲突测试中表现良好

2. 针对性对抗测试

5.1 生物化学领域

表11详细记录了多项测试:

-

长文本生物风险问答:能够综合各阶段生物威胁信息 -

病毒学故障排除:准确率超人类平均水平 -

协议 QA 开放问答:准确率低于专家共识基准

图5-图16 展示了具体测试结果

5.2 网络安全领域

表12记录了漏洞识别与利用能力:

-

CTF 专业级挑战通过率达 42%(120b 模型) -

在 Azure SSRF 等场景中表现突出

六、常见问题解答(FAQ)

Q1: gpt-oss 模型与 OpenAI API 模型的差异?

A: 核心架构相似,但开源版本缺少部分系统级安全防护,需开发者自行实施额外防护措施。

Q2: 量化版本对性能影响?

A: MXFP4 量化在保持 90% 以上参数精度的同时,大幅降低显存需求,实际推理精度损失小于 3%。

Q3: 如何获取模型权重?

A: 需通过 OpenAI 官方渠道申请,符合 Apache 2.0 协议使用规范。

Q4: 模型支持哪些编程语言?

A: 原生支持 Python 工具调用,通过函数定义可扩展其他语言支持。

七、技术应用建议

1. 部署建议

-

120b 版本建议使用 80GB+ 显存设备 -

20b 版本适合边缘设备部署

2. 优化技巧

-

合理设置推理强度(复杂任务用 High 模式) -

善用工具调用扩展能力边界 -

注意输出中可能包含的 CoT 幻觉内容

结语

gpt-oss 系列模型在保持强大性能的同时,通过开源方式促进了 AI 技术普惠。其在医疗、生物安全等领域的突出表现,为专业领域应用提供了新可能。开发者需注意平衡模型能力与安全防护,构建可靠的应用系统。