T5Gemma:重新定义编解码器大型语言模型的性能与效率

在大型语言模型(LLM)迅速发展的今天,编解码器模型似乎被解码器模型的光芒所掩盖。然而,编解码器模型凭借其在推理效率、设计灵活性以及对输入理解的丰富表示上的优势,依然在许多实际应用中占据重要地位。今天,我们将深入探讨 T5Gemma——一个通过适应技术将预训练的解码器模型转化为编解码器模型的新系列,它不仅继承了解码器模型的强大能力,还在性能和效率上实现了显著提升。

一、研究背景:编解码器模型的复兴

在大型语言模型领域,解码器模型因其在生成任务中的出色表现而备受关注。然而,编解码器模型如 T5,凭借其高效的推理能力、灵活的设计以及对输入理解的强大能力,在许多实际应用中仍然不可或缺。编解码器模型通过将输入理解与输出生成分离,为处理复杂的上下文表示和任务提供了更高的自由度。

T5Gemma 的研究团队提出了一个关键问题:能否通过适应技术,将预训练的解码器模型转化为编解码器模型?答案是肯定的。通过从预训练的解码器模型中初始化编解码器模型的参数,然后通过 UL2 或 PrefixLM 基础训练进一步适应,T5Gemma 实现了这一点。

这种适应方法不仅加速了训练过程,还有效地将解码器模型的内部知识转移到编解码器模型中,保留甚至增强了其能力。更重要的是,这种方法允许大小不一的模型进行组合,例如将大型编码器与小型解码器配对,为特定任务提供质量与效率的优化组合。

二、技术核心:编解码器适应技术

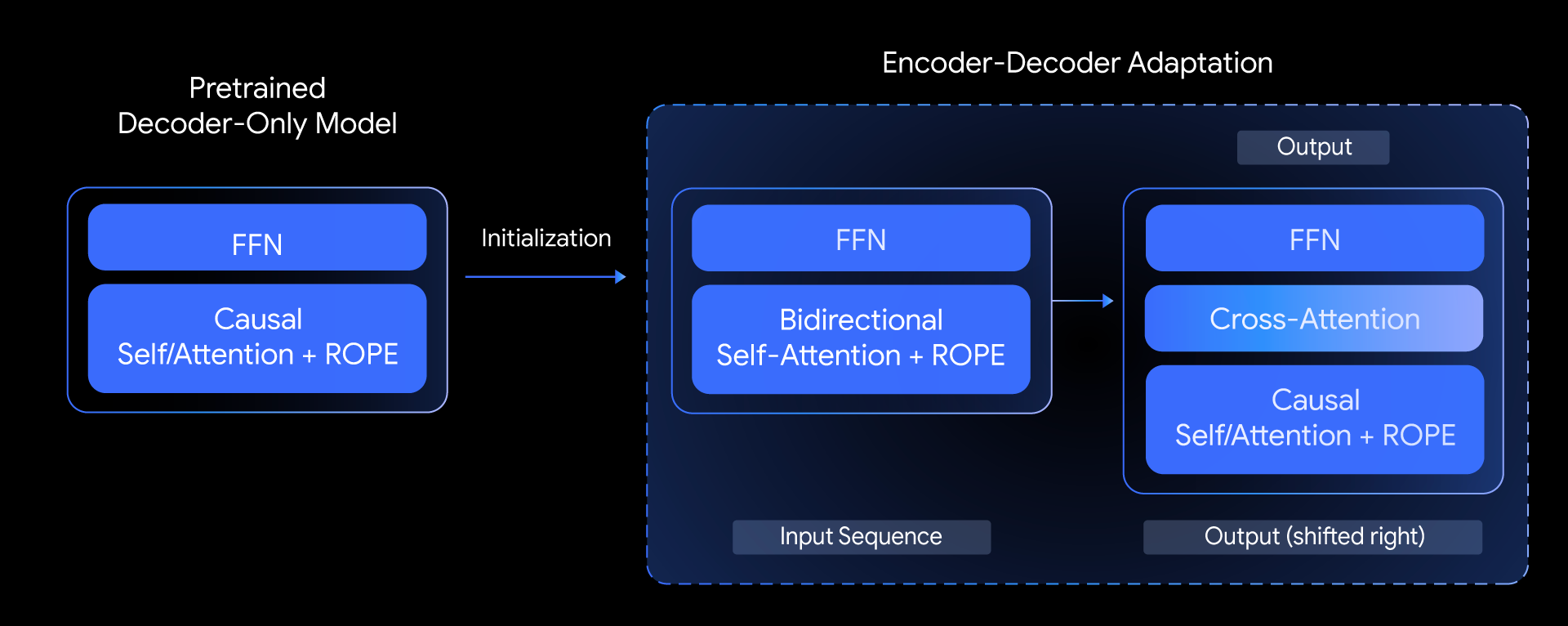

(一)架构设计

T5Gemma 的编解码器架构基于原始 Transformer 架构,但在编码器部分进行了调整。编码器采用与解码器模型相同的架构,但将自注意力从因果注意力改为双向注意力。这一改变使得编码器能够更全面地理解输入信息,对下游任务的性能提升起到了关键作用。

解码器部分则与解码器模型保持一致,但在每个解码器块中引入了交叉注意力机制。交叉注意力的头部数量和头部维度与自注意力相同,但关注的是编码器的整个输出。这种设计使得解码器能够充分利用编码器生成的上下文信息,增强生成任务的表现。

(二)初始化策略

在从预训练解码器模型初始化编解码器模型时,研究团队采用了精心设计的策略。编码器完全从解码器模型初始化,因为其不引入新权重。在解码器中,前馈网络(FFN)和自注意力子模块从解码器模型的对应层初始化,而交叉注意力则根据编码器和解码器的配置进行初始化。

当编码器和解码器配置相同时,交叉注意力从自注意力权重初始化。而在非平衡配置下,交叉注意力从头开始初始化,并在前 K 步训练中进行预热,同时冻结其他模型参数。K 步之后,所有参数一起调整。

(三)预训练目标

T5Gemma 探索了两种经典的编解码器预训练目标:前缀语言建模(PrefixLM)和 UL2。

PrefixLM 类似因果语言建模,但引入了前缀条件。实验中,将序列均分为两部分,前半部分作为输入,后半部分作为目标。这简化了预处理流程,同时方便从解码器模型进行知识蒸馏。

UL2 则更为复杂,由多个不同复杂程度的去噪任务组成。研究团队按照相关文献准备 UL2 数据,并在实验中比较了这两种预训练目标的性能。

三、实验成果:性能与效率的双重提升

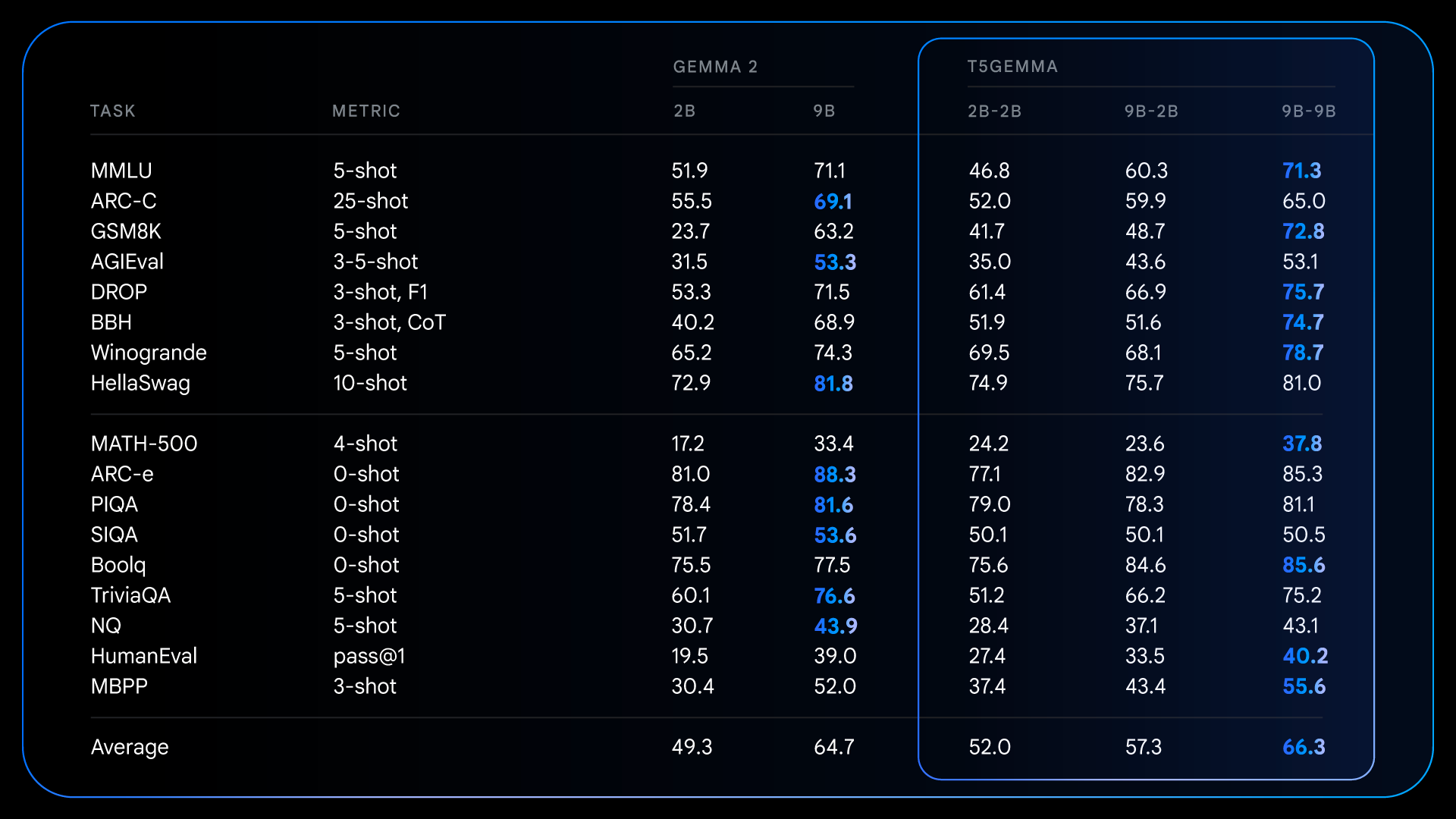

(一)预训练与指令调优表现

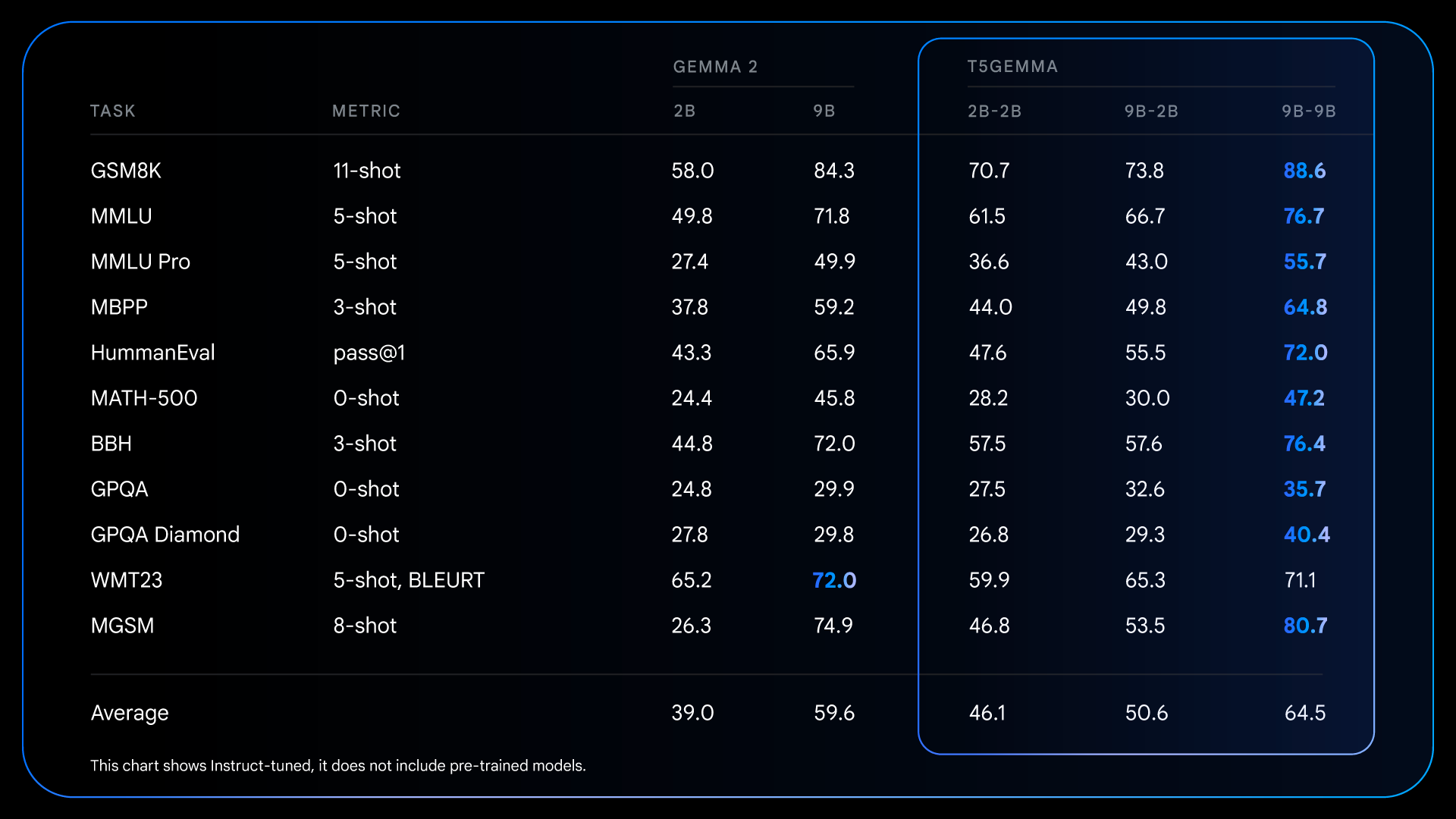

在预训练阶段,T5Gemma 模型在多个基准测试中表现优异。例如,在 GSM8K(数学推理)和 DROP(阅读理解)任务中,T5Gemma 9B-9B 分别比原始 Gemma 2 9B 模型高出 9 分和 4 分。这表明通过适应技术初始化的编解码器架构,能够创造出更强大、性能更优的基础模型。

经过指令调优后,T5Gemma 的优势进一步扩大。以 T5Gemma 2B-2B IT 为例,其在 MMLU 和 GSM8K 任务上的得分分别比 Gemma 2 2B 高出近 12 分和 12.7%。这表明适应架构不仅提供了一个更好的起点,还能更有效地响应指令调优,最终产生更强大、更有用的模型。

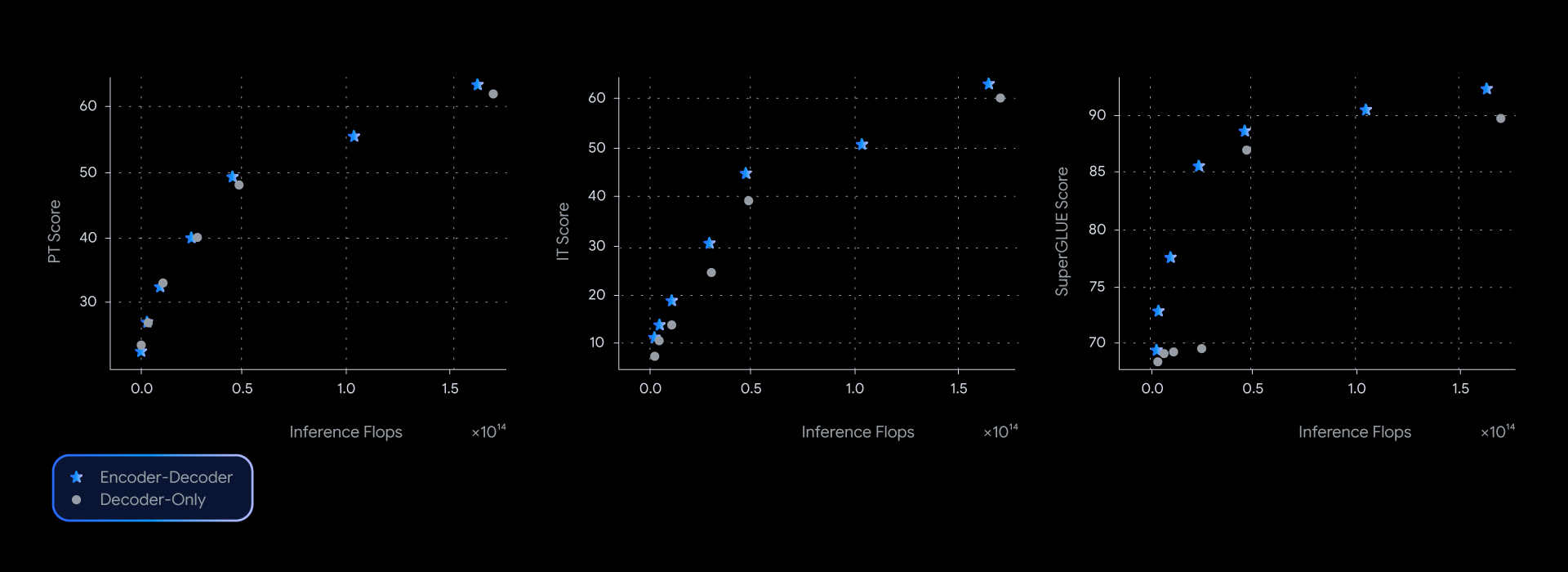

(二)推理效率分析

T5Gemma 在推理效率上同样表现出色。在 GSM8K 任务的延迟测试中,T5Gemma 9B-9B 与 Gemma 2 9B 模型的延迟相近,但准确率更高。更令人印象深刻的是,T5Gemma 9B-2B 的延迟几乎与更小的 Gemma 2 2B 模型相同,却实现了显著的性能提升。

这种灵活性使得 T5Gemma 能够在不同的应用场景中找到质量与效率的最佳平衡点。例如,在需要深度理解输入的任务(如摘要生成)中,可以选择大型编码器与小型解码器的组合,以减少生成时间,同时保持竞争力。

四、模型变体与应用场景

(一)多种模型尺寸

T5Gemma 提供了多种尺寸的模型,包括 T5 尺寸的 Small、Base、Large 和 XL 模型,基于 Gemma 2 的 2B 和 9B 模型,以及介于 T5 Large 和 T5 XL 之间的额外模型。这种多样化的选择使得研究人员和开发者能够根据具体需求选择合适的模型尺寸。

(二)不同训练目标

T5Gemma 提供了基于 PrefixLM 或 UL2 训练目标的模型。PrefixLM 侧重于生成性能,而 UL2 更关注表示质量。这种多样性为用户提供了根据不同任务需求选择模型的灵活性。

(三)非平衡模型配置

T5Gemma 还提供了一种强大的非平衡配置——9B-2B 检查点。这种配置允许研究编码器与解码器尺寸之间的权衡,为特定任务定制模型提供了新的可能性。

五、实际应用案例

(一)文本摘要生成

在文本摘要任务中,T5Gemma 的非平衡配置(如 9B-2B)展现出了独特的优势。大型编码器能够深入理解输入文本的语义信息,而小型解码器则能够高效地生成简洁、准确的摘要。这种组合不仅提高了摘要的质量,还显著降低了生成延迟,满足了实时应用场景的需求。

(二)机器翻译

在机器翻译任务中,T5Gemma 的双向注意力机制使得编码器能够更全面地捕捉源语言句子的上下文信息。实验表明,T5Gemma 在多种语言对的翻译任务中都取得了优异的性能,尤其是在处理复杂句式和长句子时,其优势更加明显。

(三)问答系统

对于问答系统,T5Gemma 的高效推理能力和强大的上下文理解能力使其能够在短时间内提供准确、详细的答案。在 SuperGLUE 基准测试中,T5Gemma 在 COPA、WIC、WSC 等任务上均取得了较高的准确率,证明了其在语言理解任务中的竞争力。

六、未来发展方向

(一)模型尺寸扩展

目前,T5Gemma 的研究主要集中在 Gemma 2 模型的 2B 和 9B 尺寸上。未来,研究团队计划扩展模型尺寸(如 27B),以探索更大规模模型的性能潜力。

(二)跨模型家族适配

T5Gemma 的方法具有高度的灵活性,理论上可以应用于其他模型家族,如 LLaMA、QWen 等。未来的工作将尝试将不同家族的模型进行适配组合,例如将 LLaMA 模型与 QWen 模型配对,以充分发挥各自的优势。

(三)多模态扩展

将 T5Gemma 扩展到多模态建模(如视觉 – 语言和语音 – 语言)是另一个令人兴奋的方向。这将使模型能够处理更复杂的输入形式,进一步拓展其应用场景。

(四)训练目标优化

研究团队还将继续探索如何更好地结合 PrefixLM、知识蒸馏和 UL2 等技术,以进一步提升模型的性能。此外,研究 PrefixLM 和 UL2 的联合优化方法也将成为未来的工作重点。

七、总结

T5Gemma 通过创新的适应技术,成功地将预训练的解码器模型转化为编解码器模型,在保持高效推理能力的同时,显著提升了模型的性能。它不仅为编解码器模型在大型语言模型领域的发展注入了新的活力,还为研究人员和开发者提供了一个强大而灵活的工具。通过结合 T5Gemma 的多种模型尺寸、训练目标和配置选项,我们能够针对不同的应用场景找到最佳的质量与效率平衡点,推动自然语言处理技术在更多领域的应用和发展。