实时视频生成的突破:MirageLSD如何实现无限流媒体与零延迟

想象一下:视频通话中,你挥动铅笔的瞬间,屏幕里同步变成魔杖发射火花;游戏直播时,整个战场实时转化为水墨画风——这就是MirageLSD带来的现实。

一、什么是Live-Stream Diffusion?

我们团队在2025年7月正式发布MirageLSD——全球首个实现无限时长、40毫秒延迟的实时视频生成模型。与传统AI视频方案相比,它的核心突破体现在三个维度:

| 特性对比 | 传统模型 | MirageLSD |

|---|---|---|

| 生成延迟 | 10秒以上 | <40毫秒 |

| 持续时间 | 5-10秒片段 | 无限连续流 |

| 交互性 | 批量生成后编辑 | 实时动态响应 |

| 典型应用场景 | 短视频特效 | 直播/视频通话/游戏 |

技术定义

Live-Stream Diffusion(LSD)是一种因果自回归框架,通过以下组件实现实时生成:

graph LR

A[历史帧 F_i-2, F_i-1] --> C

B[当前输入帧 I_i+1] --> C

D[用户提示 P] --> C

C[LSD模型] --> E[输出帧 F_i+1]

E --> A

二、攻克两大技术堡垒

问题1:为什么之前视频无法超过30秒?

错误累积效应是罪魁祸首。当模型逐帧生成时,前帧的微小瑕疵(如纹理偏差、位移误差)会像滚雪球一样放大:

我们的解决方案:历史增强训练

-

扩散强制(Diffusion Forcing)

每帧独立加噪,训练模型单帧去噪能力 -

输入历史人工污染

在训练中故意给历史帧添加模拟缺陷,教会模型预期并修正误差

实验证明:该方法使连续生成时长突破120分钟无质量衰减

问题2:如何实现40毫秒帧生成?

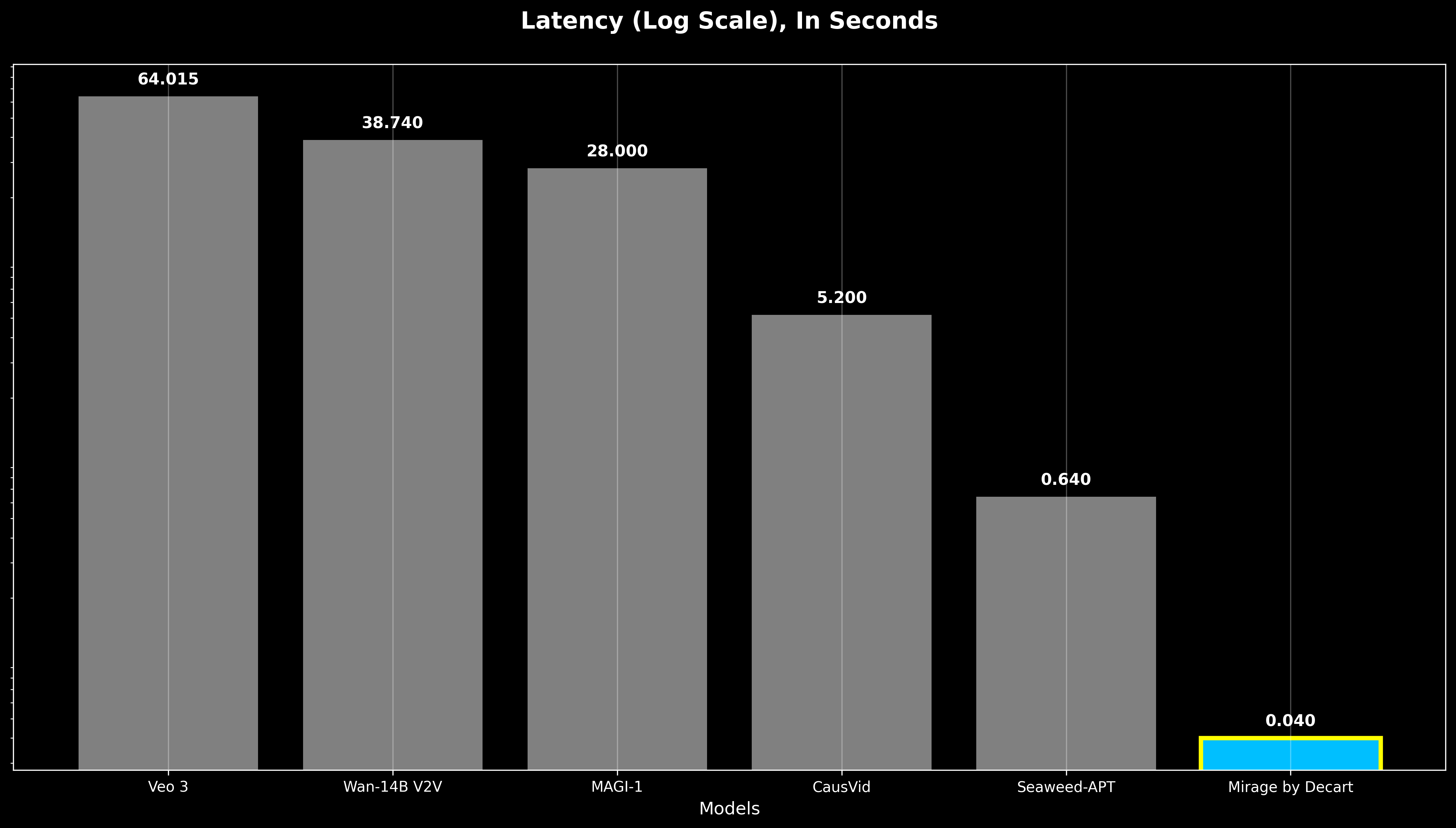

实时性要求每帧处理≤40ms(24FPS标准),而当前最优模型延迟仍超640ms:

三重加速架构

# 优化策略伪代码

def generate_frame():

apply_hopper_kernels() # CUDA定制核减少80%层间延迟

execute_pruning() # 架构感知剪枝降低35%FLOPs

use_distillation() # 捷径蒸馏减少75%去噪步骤

return frame < 40ms

关键技术细节:

-

Hopper GPU专属内核

内核间直接GPU-GPU通信,消除数据传输瓶颈 -

张量核心对齐剪枝

根据GPU硬件特性调整参数矩阵维度 -

三步捷径蒸馏

小模型复现大模型去噪路径(基于Frans等2024年技术)

三、平台应用场景实例

实时交互操作指南

sequenceDiagram

用户->>+Mirage平台: 输入提示词“赛博朋克”

Mirage平台->>+摄像头: 获取实时视频流

循环每帧处理

LSD模型-->>历史帧: 分析F_i-2至F_i

LSD模型-->>输入帧: 解析I_i+1

LSD模型->>输出帧: 生成F_i+1

输出帧-->>用户屏幕: 40ms内渲染

end

当前支持场景:

-

📱 手机摄像头实时风格化(iOS/Android版已上线) -

🎮 游戏画面即时转换(如《我的世界》→ 蒸汽朋克世界) -

💻 视频会议动态背景生成(支持毛发级边缘分割)

四、技术局限性及发展路线

现存挑战

| 问题领域 | 改进方向 |

|---|---|

| 长期记忆 | 扩展历史帧窗口容量 |

| 物体精确控制 | 整合ControlNet适配器 |

| 极端风格一致性 | 增强几何约束机制 |

2025年更新计划

title Mirage平台发展路线

dateFormat YYYY-MM-DD

section 模型升级

面部一致性 :2025-07-18, 30d

语音控制 :2025-08-20, 25d

section 平台功能

直播角色扮演 :2025-08-01, 45d

游戏SDK集成 :2025-09-10, 60d

五、技术问答(FAQ)

Q1:和传统Diffusion模型有什么区别?

核心差异在生成架构:

- 传统方案:批量生成5秒片段 → 需要完整缓存 → 高延迟

+ LSD方案:逐帧流式生成 → 即时输出 → 零延迟

Q2:40ms延迟如何保证?

通过三层硬件协同优化:

-

CUDA内核级:合并计算指令减少启动开销 -

模型架构级:参数张量匹配GPU核心数量 -

蒸馏压缩:12步去噪压缩至3步

Q3:为什么能避免画面崩溃?

历史增强训练使模型具备“抗干扰”能力,即使输入帧存在30%像素误差,仍能稳定输出:

.png)

六、参考文献

@techreport{mirage2025,

title={MirageLSD: Zero-Latency, Real-Time, Infinite Video Generation},

author={Decart AI},

year={2025},

url={https://mirage.decart.ai/}

}

完整技术资源请访问: