从农场到未来:解读Ralph Loop如何让AI编码学会“自己动手”

想象一下,你正在指导一位永不气馁的编程助手。它写了一段代码,运行,失败了,但它不会停下来等你指示,而是立刻查看错误信息,思考,修改,然后再次尝试。如此循环,直到成功。这不是科幻场景,而是一位澳大利亚山羊农场主用短短5行代码开启的现实。

这就是Ralph Loop——一种让AI通过“反复失败”来学习并最终完成任务的技术范式。它正在悄然改变我们与AI协作编写软件的方式。今天,我们就来深入解读Ralph Loop的四种主要变体,看看这个简单的想法是如何演变成一股强大的开发浪潮的。

故事的起点:一个农场主的5行代码

这一切始于2025年的澳大利亚乡村。Geoffrey Huntley在照看山羊之余,也在与AI编程工具“较劲”。他发现了一个恼人的模式:每次AI生成的代码出错,整个会话就会停滞,必须由他手动介入,解释错误,给出指令,然后重启。这个过程既低效又重复。

Huntley思考:如果AI能像人类一样,看到自己运行失败的结果,并自动基于这个反馈进行重试,那会怎样?他的解决方案简单到令人惊讶——一个只有5行的Bash脚本:

while :; do

cat prompt.txt | claude-code --continue

done

这个脚本构成了第一个Ralph Loop:一个无限循环,不断地将同一个提示文件喂给Claude Code。没有复杂的逻辑,就是机械地重试。Huntley以《辛普森一家》中那个永远乐观、屡败屡战的小男孩Ralph Wiggum为之命名。

为什么这个简单的循环有效? 关键在于思维的转变。传统开发追求“一次成功”,但在AI的世界里,“确定性地失败”比“不确定性地成功”更有价值。每一次编译错误、测试失败或类型检查报错,都提供了精确的反馈,告诉AI哪里出了问题。AI不是在盲目尝试,而是在一个有明确反馈信号的环境中进行迭代改进。

这个循环创造了一个“自引用反馈系统”:

-

AI收到提示(如“实现功能X,通过所有测试”)。 -

AI编写代码并运行测试,假设有3个测试失败。 -

循环重启,相同的提示再次输入,但此时AI看到的文件系统状态已经改变——代码文件已生成,测试结果已输出。 -

AI读取新的上下文(尤其是失败信息),调试并修复代码。 -

重复此过程,直到所有测试通过。

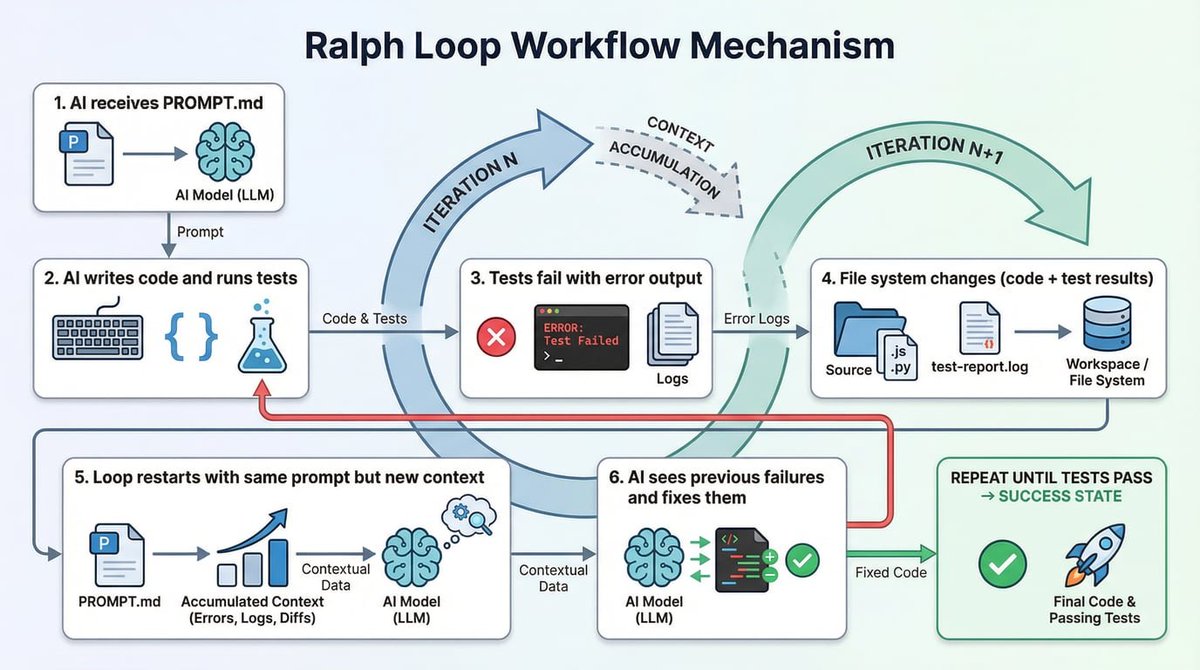

(图解:Ralph Loop的自引用反馈循环。提示是固定的,但文件系统的状态随着每次迭代而变化,为AI提供新的上下文。)

两大基础实现:官方集成与极简主义

原始的Bash脚本虽然理念纯粹,但使用起来不够方便。社区很快发展出两种更实用的基础实现方式。

1. Claude Code官方插件:内置的“停止钩子”

Anthropic的Claude Code团队将Ralph理念做成了官方插件。它的核心创新在于“Stop Hook”(停止钩子)机制。

它是如何工作的?

传统的外部循环需要反复启动新会话。而Claude Code插件则在单个会话内部实现循环:

-

拦截退出:当Claude试图退出时,插件会进行拦截。 -

检查完成条件:插件检查输出中是否包含用户预设的完成标签(例如 <promise>COMPLETE</promise>)。 -

阻止与注入:如果未完成,插件会阻止会话退出,并自动注入新的提示,开启下一轮迭代。

如何使用?

安装插件后,使用非常简单:

/ralph-loop “构建一个TODO应用的REST API,包含CRUD操作、输入验证和单元测试。完成后输出<promise>COMPLETE</promise>” \

--max-iterations 50 \

--completion-promise “COMPLETE”

特点与适用场景:

-

优点:无需外部脚本;保持单一会话的连贯上下文;使用简便。 -

限制:迭代计数和成本控制功能相对基础。 -

适合谁:适合进行快速原型开发、短期任务(1小时内),或希望紧密集成在Claude Code生态中的项目。

2. Ryan Carson版:工具无关的显式控制

Ryan Carson的实现回归了Huntley的原始哲学:极简、显式,且与任何AI CLI工具都能搭配使用。

核心脚本逻辑:

for i in $(seq 1 $_ITERATIONS); do

OUTPUT=$(cat prompt.txt | amp --dangerously-allow-all 2>&1)

if echo “$OUTPUT” | grep -q “<promise>COMPLETE</promise>”; then

exit 0

fi

done

项目结构:

scripts/ralph/

├── run.sh # 主循环脚本

├── prompt.txt # 核心AI指令

├── prd.json # 用户故事任务列表

└── progress.txt # 学习日志(跨迭代传递知识)

核心特点:

-

全新上下文:每次迭代对AI来说都是一个全新的开始,避免了长期会话可能产生的上下文混淆。 -

知识积累:通过 progress.txt文件,以“代码库”模式记录项目经验,供后续迭代参考。 -

高度灵活:可与 amp、claude、cursor等任何命令行AI工具配合。

适合谁:需要处理多任务/多用户故事的项目、计划长时间(数小时甚至过夜)无人值守运行、或是不使用Claude Code的开发者。

两种生产级演进:应对成本与漂移的挑战

基础的Ralph Loop在投入生产环境时,暴露了两个核心问题:不可控的成本和任务目标漂移。开源社区针对这些问题,提出了两种代表性的高级解决方案。

1. Vercel Labs:面向开发者的双层循环架构

Vercel Labs将Ralph理念深度集成到其AI SDK中,核心创新是双层循环架构。

它是如何工作的?

-

内层循环(Tool Loop):AI SDK像往常一样调用工具(写代码、运行测试等)。 -

外层循环(Ralph Loop):内层循环结束后,系统自动执行一个 verifyCompletion函数(由开发者定义),来验证任务是否真正完成(例如,所有测试是否通过,性能指标是否达标)。 -

反馈注入:如果 verifyCompletion返回“未完成”及原因,这个原因会被作为系统消息注入到下一轮迭代的上下文中,指导AI进行针对性修复。

关键优势:可编程的成本控制

Vercel的实现允许你预设精确的停止条件,防止预算失控:

stopWhen: [

iterationCountIs(50), // 最多迭代50次

totalCostIs(10.0), // 总成本不超过10美元

totalTokenUsageIs(200000) // 总token使用不超过20万

]

适合谁:适合已有Vercel AI SDK技术栈、需要处理单一明确任务(如代码迁移、批量重构),且对成本控制有精确要求的开发者。

(图解:Vercel的双层循环架构。外层循环通过verifyCompletion函数进行验证,并将失败原因作为反馈注入下一轮迭代。)

2. Zenflow:规格驱动的“受控循环”

Zenflow是一个独立的桌面应用,其核心理念是:“没有锚点的循环注定会漂移”。它将Ralph循环嵌入到一套严谨的“规格驱动开发”(SDD)工作流中。

核心架构:作为状态机的Markdown文件

整个工作流由一个结构化的Markdown文件(workflow.md)定义和管理:

.zenflow/tasks/{task_id}/

├── workflow.md # 可执行的工作流定义与日志

├── spec.md # 需求规格(不变的锚点)

├── report.md # 执行报告

└── changes/ # 每次迭代的代码变更记录

自修改计划机制:Zenflow的循环不是靠外部脚本重启,而是让AI代理在完成一个步骤后,自己修改workflow.md文件,追加下一个步骤。Zenflow检测到文件变化后,自动执行新步骤。这确保了循环始终朝着计划的目标前进。

“委员会方法”多模型审查

Zenflow研究发现,让不同的大模型互相审查,比单一模型反复迭代更有效。一个典型的工作流可能包括:

-

实现:由Claude Opus生成代码。 -

审查:由GPT-4o审查代码,找出潜在问题(不同模型有不同“盲点”)。 -

修复:由Claude Opus根据审查意见进行修复。 -

最终验证:由Gemini Pro做最终检查。

“黄金三次迭代”法则

Zenflow团队基于实践经验提出:多数任务在1到3次迭代内就能收敛到正确方案。超过3次,AI容易开始“过度优化”或“方向漂移”。因此,Zenflow提倡“快速失败”哲学,强制限制迭代次数,避免无意义的资源消耗。

适合谁:需要管理复杂、多步骤开发流程的团队;担心长时间运行导致目标漂移的项目;以及希望利用多模型优势提升代码质量的开发者。

(图解:Zenflow的“委员会方法”工作流,利用不同的大模型进行实现、审查和验证,以提高输出质量。)

技术权衡:我该选择哪个版本?

为了帮助你决策,这里是一个清晰的对比:

| 特性 | Claude Code 官方版 | Ryan Carson 版 | Vercel Ralph Loop | Zenflow 受控循环 |

|---|---|---|---|---|

| 核心架构 | 会话内停止钩子 | 外部Bash循环 | 双层循环(验证+工具) | 单层循环 + 自修改计划 |

| 核心锚点 | 完成标签匹配 | 完成标签匹配 | verifyCompletion 函数 |

spec.md + workflow.md |

| 多模型支持 | 否 | 否(但可换工具) | 否 | 是(委员会方法) |

| 成本控制 | 基础(最大迭代数) | 基础(最大迭代数) | 精细(Token/成本/迭代数) | 严格(3次迭代硬限制) |

| 适用场景 | Claude Code快速原型 | 灵活、长时、多任务 | Vercel AI SDK生态,明确任务 | 复杂工作流,防漂移,团队协作 |

选择建议:

-

选 Claude Code 官方版:如果你已经是Claude Code用户,想以最简单的方式体验Ralph Loop,进行短期任务。 -

选 Ryan Carson 版:如果你追求最大灵活性和控制力,不依赖特定工具,或需要长时间运行。 -

选 Vercel Ralph Loop:如果你的项目基于TypeScript/Vercel AI SDK,需要精细的成本控制和可编程集成。 -

选 Zenflow:如果你面临复杂的多步骤开发流程,极度担心目标漂移,并希望利用多模型能力提升代码质量。

真实世界中的Ralph:它能做什么,成本如何?

理论再好,也需要实践检验。让我们看几个真实案例:

案例1:开发一门完整的编程语言

Geoffrey Huntley本人使用Ralph技术,在3个月内几乎无人干预地开发了一门名为CURSED的编程语言,包括编译器、标准库、编辑器支持和文档。他只是在必要时调整prompt.txt中的指令。

案例2:黑客马拉松的批量产出

在一次Y Combinator黑客马拉松中,参与者使用Ralph,一夜之间自动生成了6个完整的代码仓库。这展示了其强大的批量开发和无人值守能力。

案例3:惊人的成本效益

有开发者报告,使用amp工具配合Ralph循环,完成了一个价值5万美元的商业合同项目,实际AI API成本仅为297美元,成本比率仅0.594%。这引发了关于AI开发经济学的深度思考。

案例4:社区的“甜蜜烦恼”

Reddit的r/ClaudeCode社区也有真实反馈。有用户报告了一个Bug:一个项目的Ralph循环意外接管了另一个项目的会话,导致2小时消耗了14%的月度用量。解决方案是使用Git Worktrees为每个Ralph任务创建独立的工作目录。另一位用户则精辟地总结:“Ralph很厉害……但第一次用需要信念和对最终结果的信任。Ralph会考验你。”

争议与反思:安全、成本与“人在循环”的未来

Ralph Loop的“暴力迭代”哲学并非没有争议。

成本:最现实的挑战

Ralph最大的开销是Token消耗。社区数据显示,一次50次迭代的自主循环可能消耗周度用量的10-15%。因此,始终设置--max-iterations参数不是可选项,而是必须项。关键在于权衡:如果Ralph在2小时内完成了原本需要20小时人工指导的工作,即使消耗15%的用量,其投资回报率也可能是非常可观的。

安全:迭代中的“退化”风险

2025年的一项研究《AI代码生成中的迭代安全降级》指出一个令人担忧的现象:在纯LLM反馈循环中,代码安全性可能会随着迭代次数增加而系统性下降。最初安全的代码,在经过多轮AI“改进”后,可能在不经意间引入身份验证绕过、SQL注入等新漏洞。这警示我们,对于安全敏感的任务,不能完全放任AI自主循环,需要引入只读权限的代理进行安全检查,或在关键节点保留人工审查。

思维模式的根本转变

Ralph Loop最终改变的是人机协作的模式。正如技术博主Matt Pocock所说,新模式是:“不再强迫AI遵循脆弱的多步计划,而是让代理简单地‘从看板上抓任务卡片’,完成它,然后找下一个。”

-

传统模式:人类计划 → AI执行步骤1 → 人类审查 → AI执行步骤2 → …… -

Ralph模式:人类定义成功标准 → AI自主迭代 → 达成目标(通过文件系统、测试结果、Git历史反馈)

这就要求开发者掌握一项新技能:写好目标,而非写好步骤。你的提示词不应是“做A,然后做B”,而应是“达成X状态,证据是Y测试通过”。

如何使用Ralph Loop:实用指南与技巧

哪些任务适合交给Ralph?

-

有明确、自动化验证标准的任务

ralph-loop “让tests/auth/目录下的所有测试通过。当npm test -- auth返回0退出码时,输出<promise>DONE</promise>” --max-iterations 30 -

迭代改进类任务

-

重构代码以符合新的代码规范。 -

将项目从旧框架迁移到新框架。 -

优化性能以达到某个基准指标。

-

-

新项目或新功能开发

-

从零开始构建一个API。 -

开发一个一次性数据处理脚本。

-

-

任何拥有完整自动化流水线的任务

-

有单元测试、集成测试套件。 -

配置了Linter和代码格式化工具。 -

拥有CI/CD管道,可以自动构建和部署。

-

哪些任务不适合?

-

需要人类判断和权衡的决策

-

系统架构选型(微服务还是单体?)。 -

用户体验设计决策。 -

安全方案评审。

-

-

目标模糊不清的任务

-

例如:“让应用更快”——这种提示会导致AI无目的地优化,可能以破坏功能为代价。

-

-

生产环境的高风险操作

-

线上故障的紧急修复。 -

数据库的不可逆迁移。 -

支付或核心业务逻辑的更改。

-

-

探索性、调研性工作

-

“分析性能下降的根本原因”——这需要理解上下文和意图,而不仅仅是执行。

-

如何撰写一个高效的Ralph Prompt?

一个糟糕的Prompt:“构建一个电商平台。”

一个优秀的Prompt范例:

## 目标

实现用户认证系统。

## 成功标准

1. 运行 `npm test -- auth` 所有测试通过。

2. 运行 `npm run typecheck` 无TypeScript编译错误。

3. 包含以下功能模块:

- 基于JWT的令牌生成与验证

- 使用bcrypt进行密码哈希

- 刷新令牌机制

## 验证步骤

每次迭代完成后,请自动:

1. 运行 `npm test -- auth`

2. 运行 `npm run typecheck`

3. 如果上述两步均成功,输出:<promise>AUTH_COMPLETE</promise>

## 约束

- 必须使用项目中现有的 `lib/jwt.ts` 工具库。

- 必须遵循 `docs/security-guidelines.md` 中的安全规范。

- 密码最小长度强制为8位。

## 受阻处理

如果连续15次迭代仍未成功:

1. 记录当前遇到的核心问题。

2. 列出已尝试过的解决方案。

3. 建议一个可能的替代实现路径。

4. 输出:<promise>BLOCKED</promise> 并停止循环。

要点总结:

-

可验证:成功标准必须能被机器自动检测。 -

可操作:提供具体的验证命令。 -

有边界:明确给出技术栈、规范和约束。 -

有熔断:预设卡住时的处理机制,避免无限循环。

监控与安全措施

智能熔断器:高级的Ralph实现可以内置熔断逻辑,当检测到以下情况时自动停止:

-

无进展:连续多次迭代没有任何文件被修改。 -

重复错误:连续出现完全相同的错误信息。 -

质量下降:AI输出内容长度或结构完整性骤降。

Git安全网:在启动Ralph前,始终创建一个隔离的分支,这是最重要的安全回滚措施。

# 在运行Ralph前

git checkout -b ralph/experiment-$(date +%s)

# 如果结果不满意,轻松回滚

git reset --hard origin/main

(图解:一个理想的Ralph Loop监控面板,展示迭代进度、Token消耗、成本预估和实时日志。)

未来展望:从自主工具到自主智能还有多远?

Ralph Loop展示了AI在受限领域内(目标明确、结果可验证)的强大自主性。但它也清晰地划出了当前AI能力的边界。

Ralph能做的:

-

让测试通过。 -

修复编译和类型错误。 -

按照明确的规范实现功能。 -

在固定模式内进行代码重构。

Ralph还不能做的(也是AGI需要突破的):

-

理解业务意图:为什么需要这个功能?它的商业价值是什么? -

进行长期架构权衡:今天的代码选择会对系统三年后的可维护性产生什么影响? -

真正的创新性解决问题:提出前所未有的、优雅的解决方案。 -

跨领域知识迁移:将在开发编译器时学到的知识,应用到设计数据库索引上。

2026年的研究开始关注“反馈循环安全降级”和“递归自我改进的风险”。这提醒我们,在追求自主性的同时,人类定义的目标、设置的边界和关键时刻的监督,仍然是不可替代的安全阀。

Geoffrey Huntley的总结非常深刻:“Ralph需要信念和对最终结果的信任。每次Ralph走错方向,我不怪工具——我检查自己的prompt并调整。就像调吉他。”

这或许就是Ralph Loop带给我们的最大启示:它将人类开发者的核心技能,从“一步步地微观管理AI”,提升到了“精准地定义宏观目标与成功标准”。这是一种进步,一条通往更高效人机协作的路径。从澳大利亚农场里那5行循环开始的代码,正在全球开发者的实践中,不断迭代出新的未来。

正如Ralph Wiggum本人可能会说的:“我在帮忙!”——以一种我们从未预料到的方式。

关于Ralph Loop的常见问题(FAQ)

Q1:Ralph Loop和普通的AI编码助手(如Copilot)有什么区别?

A1:普通AI助手是反应式的,需要你不断给出下一个指令。Ralph Loop是主动且自治的。你给它一个最终目标,它会自己规划步骤、执行、遭遇失败、学习、再尝试,循环往复直到达成目标,整个过程无需你步步指导。

Q2:使用Ralph Loop会不会非常烧钱?

A2:它确实比单次交互消耗更多Token,因为它会多次调用AI。关键在于设置合理的约束(如最大迭代次数、成本上限)并权衡性价比。如果一个价值数天的开发任务能在几小时内以几十美元的成本完成,其投资回报率可能非常高。监控和预算是必须的。

Q3:我担心AI在循环中会“跑偏”,忘记最初的目标。

A3:这是“目标漂移”风险,也是原始Ralph的弱点。因此,像Zenflow这样的高级版本引入了“规格锚点”(spec.md)来反复对齐目标,而Vercel版本则通过verifyCompletion函数在每次迭代后检查是否偏离。写好清晰、可验证的成功标准Prompt是防御漂移的第一道防线。

Q4:Ralph生成的代码质量有保证吗?安全吗?

A4:质量取决于你的“成功标准”是否严格(例如是否包含严格的测试和Lint检查)。安全性是一个已知风险,研究表明纯AI循环可能引入漏洞。最佳实践是:1) 对安全敏感部分保留人工审查;2) 使用像Zenflow的“委员会方法”,让不同模型互相审查代码;3) 在循环中集成安全扫描工具。

Q5:我需要很深的编程知识才能用好Ralph吗?

A5:恰恰相反,Ralph可以降低实现复杂功能的门槛。但你需要的核心技能发生了转移:从“知道如何一步步编码”变为“知道如何清晰定义问题、设置验证标准、并编写出能让AI理解的高质量Prompt”。这是一种更上层的架构和设计能力。