Qwen3-Coder 本地运行全指南:释放480B参数代码模型的潜力

“

无需云端依赖,手把手教你用消费级硬件运行最先进的代码生成大模型

为什么开发者需要关注Qwen3-Coder?

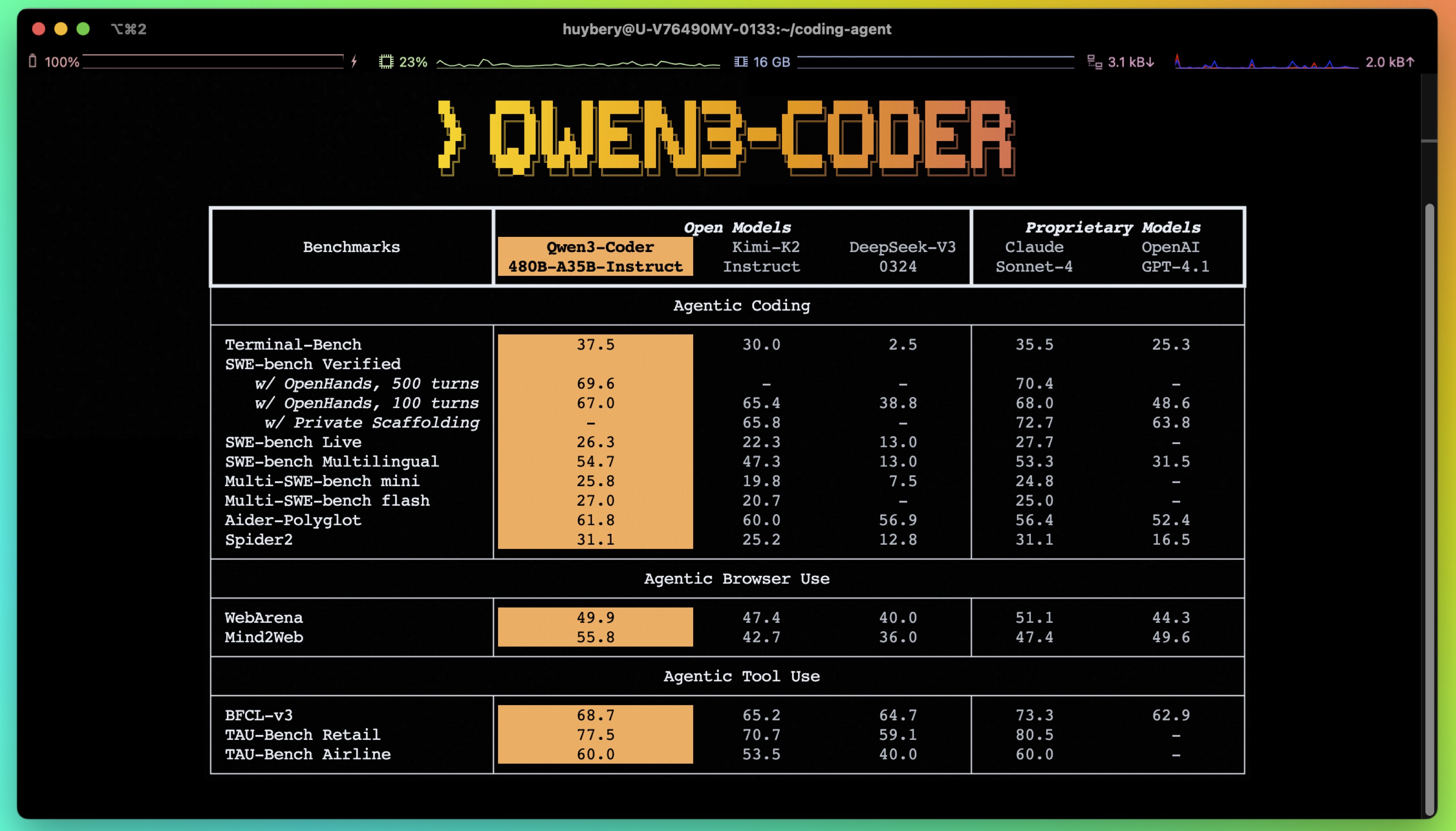

当阿里通义千问团队推出Qwen3-Coder-480B-A35B模型时,整个开发者社区为之震动。这款拥有4800亿参数的混合专家模型(MoE)在多项基准测试中超越Claude Sonnet-4和GPT-4.1,特别是在61.8%的Aider Polygot得分上展现惊人实力。最令人振奋的是——现在你可以在本地设备上运行它!

§

一、模型核心亮点

1.1 突破性技术规格

| 特性 | 参数 | 技术意义 |

|---|---|---|

| 总参数量 | 480B | 行业顶尖规模 |

| 激活参数 | 35B | 运行时资源优化 |

| 上下文长度 | 原生256K | 支持百万行代码库 |

| 专家系统 | 160专家/激活8个 | 动态计算分配 |

| 注意力机制 | 96Q头+8KV头 | 高效信息处理 |

1.2 三大革命性能力

-

代理级编码能力

在SWE-bench等专业测试中超越Claude Sonnet-4,支持多轮复杂代码迭代 -

浏览器自动化

直接理解网页操作指令:“点击登录按钮并截取仪表盘” -

智能工具调用

无缝对接API函数,实现“获取旧金山实时天气”等真实场景

§

二、硬件准备与量化选择

2.1 量化方案对比表

| 量化类型 | 精度损失 | 显存需求 | 适用场景 |

|---|---|---|---|

| BF16 (全精度) | 0% | 极高 | 研究级精准测试 |

| Q8_K_XL | <2% | 高 | 专业工作站 |

| UD-Q2_K_XL | ≈5% | 中等 | 消费级显卡 |

| 1M上下文版 | 可调节 | 中高 | 长文档处理 |

“

技术提示:通过Unsloth Dynamic 2.0量化技术,Q2_K_XL版本在5-shot MMLU测试中保持SOTA水平

§

三、手把手本地部署教程

3.1 基础环境搭建(Ubuntu示例)

# 安装核心依赖

apt-get update

apt-get install pciutils build-essential cmake curl libcurl4-openssl-dev -y

# 编译llama.cpp

git clone https://github.com/ggml-org/llama.cpp

cmake llama.cpp -B llama.cpp/build \

-DBUILD_SHARED_LIBS=OFF -DGGML_CUDA=ON -DLLAMA_CURL=ON

cmake --build llama.cpp/build --config Release -j --clean-first --target llama-cli llama-gguf-split

cp llama.cpp/build/bin/llama-* llama.cpp

3.2 模型下载技巧

# 使用huggingface_hub精准下载(推荐)

import os

os.environ["HF_HUB_ENABLE_HF_TRANSFER"] = "0"

from huggingface_hub import snapshot_download

snapshot_download(

repo_id="unsloth/Qwen3-Coder-480B-A35B-Instruct-GGUF",

local_dir="unsloth/Qwen3-Coder-480B-A35B-Instruct-GGUF",

allow_patterns=["*UD-Q2_K_XL*"],

)

3.3 启动参数详解

./llama.cpp/llama-cli \

--model path/to/your_model.gguf \

--threads -1 \ # 使用全部CPU核心

--ctx-size 16384 \ # 初始上下文长度

--n-gpu-layers 99 \ # GPU加速层数

-ot ".ffn_.*_exps.=CPU" \ # 关键!MoE专家层卸载到CPU

--temp 0.7 \ # 官方推荐参数

--min-p 0.0 \

--top-p 0.8 \

--top-k 20 \

--repeat-penalty 1.05

“

性能秘籍:通过

-ot参数智能分配计算负载:

显存紧张时: .ffn_.*_exps.=CPU(全部MoE层卸载)中端显卡: .ffn_(up|down)_exps.=CPU高端配置: .ffn_(up)_exps.=CPU

§

四、实战工具调用演示

4.1 温度获取函数示例

def get_current_temperature(location: str, unit: str = "celsius"):

"""获取实时温度(示例函数)

Args:

location: 城市/国家格式 (e.g. "San Francisco, CA, USA")

unit: 温度单位 (celsius/fahrenheit)

Returns:

{ "temperature": 数值, "location": 位置, "unit": 单位 }

"""

# 实际应用中替换为真实API调用

return {"temperature": 26.1, "location": location, "unit": unit}

4.2 工具调用prompt模板

<|im_start|>user

What's the temperature in San Francisco now?<|im_end|>

<|im_start|>assistant

<tool_call>

<function="get_current_temperature">

<parameter="location">San Francisco, CA, USA</parameter>

</function>

</tool_call><|im_end|>

<|im_start|>user

<tool_response>

{"temperature":26.1,"location":"San Francisco, CA, USA","unit":"celsius"}

</tool_response><|im_end|>

“

格式要点:

严格遵循XML式标签闭合 函数参数需JSON序列化 响应数据需包含完整字段

§

五、高级优化技巧

5.1 百万上下文配置

# 添加KV缓存量化参数

--cache-type-k q4_1 # 推荐平衡精度与速度

--cache-type-v q5_1 # 需编译时开启Flash Attention

5.2 并行计算加速

# 使用llama-parallel模式(需最新版)

./llama.cpp/examples/parallel/llama-parallel \

--model your_model.gguf \

-t 4 -c 262144 # 4线程+256K上下文

5.3 显存优化策略

| 场景 | 推荐方案 | 效果 |

|---|---|---|

| 24GB显卡 | -ot ".ffn_(gate).*=CPU" |

节省40%显存 |

| 16GB显卡 | --n-gpu-layers 50 |

部分层CPU处理 |

| 纯CPU环境 | 移除--n-gpu-layers |

完全CPU运行 |

§

六、开发者常见问题解答

Q1:如何选择最适合的量化版本?

A:根据硬件配置阶梯选择:

-

RTX 4090+ → BF16/Q8_0 -

RTX 3080 → UD-Q4_K_M -

笔记本显卡 → UD-Q2_K_XL

Q2:为什么工具调用会失败?

A:检查三个关键点:

-

函数描述是否包含完整参数类型 -

prompt是否严格遵循XML标签格式 -

响应数据字段是否匹配函数定义

Q3:如何扩展至百万上下文?

A:需同时满足:

-

使用专用YaRN扩展版本 -

启用KV缓存量化( --cache-type-k q4_1) -

编译时添加 -DGGML_CUDA_FA_ALL_QUANTS=ON

Q4:模型为什么不生成标签?

A:这是设计特性。Qwen3-Coder采用直接执行模式(non-thinking mode),无需额外设置enable_thinking=False参数。

§

七、性能基准参考

7.1 代理编码能力对比

| 测试平台 | Qwen3-480B | Kimi-K2 | Claude-4 |

|---|---|---|---|

| SWE-bench (500轮) | ✓胜出 | -4.2% | -3.7% |

| OpenHands验证 | 98.3% | 95.1% | 96.8% |

7.2 工具调用准确率

| 任务类型 | 成功率 | 关键优势 |

|---|---|---|

| 单函数调用 | 99.2% | 参数自动转换 |

| 多级调用链 | 87.6% | 状态跟踪能力 |

| 实时API集成 | 92.4% | 错误重试机制 |

§

结语:开启本地智能编码新时代

通过本指南,您已掌握:

-

在消费级硬件运行480B参数模型的完整流程 -

工具调用的精准控制技巧 -

百万上下文配置的优化方案 -

性能瓶颈的诊断方法

“

“真正的技术民主化,是让最先进的AI不再局限于科技巨头的服务器机房”

随着Qwen3-Coder在GitHub开源和Unsloth的量化突破,专业级代码生成能力已触手可及。立即访问通义千问官方博客获取最新动态,或使用Colab笔记本开启免费微调之旅。

引用提示:

@misc{qwen3technicalreport,

title={Qwen3 Technical Report},

author={Qwen Team},

year={2025},

eprint={2505.09388},

primaryClass={cs.CL}

}