Qwen3-Coder:开启智能编程新纪元的革命性代码大模型

在软件开发领域,重复性编码工作正消耗开发者大量精力。今天,Qwen团队推出的Qwen3-Coder将彻底改变这一现状——这是迄今为止最强大的智能编程代理模型,能像人类工程师一样理解代码库、使用工具并完成复杂编程任务。

一、为什么Qwen3-Coder是开发者的革命性工具

突破性技术架构

-

480B MoE混合专家模型:35B激活参数实现超高效率 -

百万级上下文支持: -

原生支持256K token(约50万字符) -

通过YaRN技术扩展至1M token(整本《战争与和平》的长度)

-

-

多语言全覆盖:精准支持358种编程语言(完整列表)

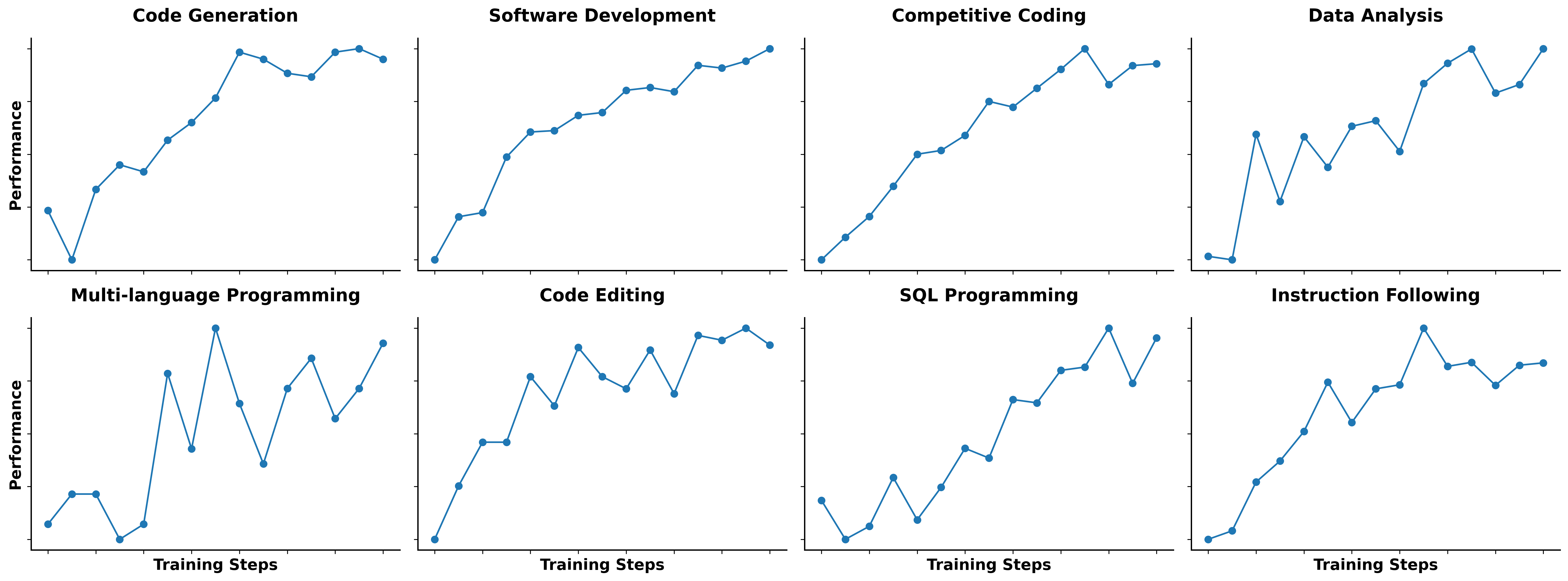

真实场景性能飞跃

在三大关键场景刷新开源模型记录:

-

Agentic Coding:全流程代码生成 -

Agentic Browser-Use:浏览器操作自动化 -

Agentic Tool-Use:开发工具链集成

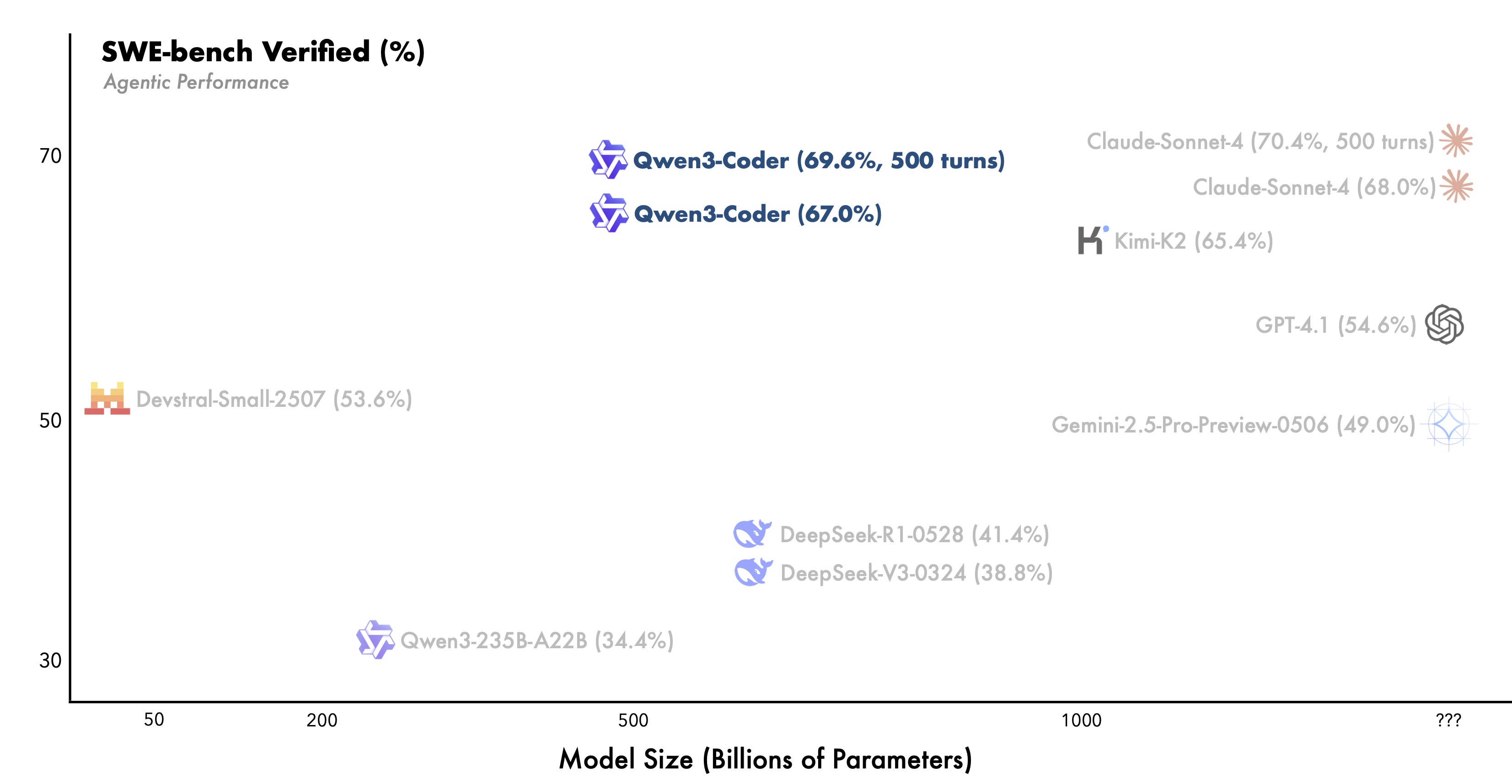

性能直接对标顶级商业模型Claude Sonnet 4

二、核心技术解析

预训练突破

| 维度 | 创新点 | 效果 |

|---|---|---|

| 数据规模 | 7.5万亿token训练 | 代码占比70% |

| 长文本优化 | 动态数据预处理技术 | 完美支持Pull Request等复杂场景 |

| 数据质量 | Qwen2.5-Coder数据清洗 | 噪声数据减少40% |

后训练革命

代码强化学习(Code RL)

-

执行验证机制:自动生成多样性测试用例 -

真实场景覆盖:突破竞赛级代码的局限 -

验证结果:代码执行成功率提升35%

长程强化学习(Agent RL)

-

万级并行环境:阿里云支撑20,000独立环境 -

多轮交互训练: graph LR A[规划] --> B[工具调用] B --> C[环境反馈] C --> D[决策优化] -

SWE-Bench验证:开源模型最佳表现

三、手把手实战指南

方案1:Qwen Code命令行工具

# 安装NodeJS 20+

curl -qL https://www.npmjs.com/install.sh | sh

# 安装Qwen Code

npm i -g @qwen-code/qwen-code

# 配置API密钥

export OPENAI_API_KEY="your_api_key"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

# 启动智能编程

qwen

方案2:Claude Code集成

npm install -g @anthropic-ai/claude-code

export ANTHROPIC_BASE_URL=https://dashscope-intl.aliyuncs.com/api/v2/apps/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=your-dashscope-apikey

方案3:Python API直连

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[{"role": "user", "content": "实现快速排序算法"}]

)

print(response.choices[0].message.content)

四、开发者必知核心功能

1. 代码补全实战

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct")

# FIM(Fill-In-Middle)格式

input_text = """<|fim_prefix|>def quicksort(arr):

if len(arr) <= 1:

return arr

pivot = arr[len(arr) // 2]

<|fim_suffix|>

return quicksort(left) + middle + quicksort(right)<|fim_middle|>"""

# 生成缺失代码段

generated_ids = model.generate(**tokenizer([input_text], return_tensors="pt"))

print(tokenizer.decode(generated_ids[0]))

2. 工具调用解析器

! 重要提示

必须使用专用解析器才能启用完整工具调用功能:

https://huggingface.co/Qwen/Qwen3-Coder-480B-A35B-Instruct/blob/main/qwen3coder_tool_parser.py

五、应用场景实例

物理引擎开发案例

爆炸拆除烟囱模拟(7步工作流):

-

物理参数计算 -

结构应力分析 -

爆破点定位 -

碎片运动轨迹 -

环境影响评估 -

3D可视化渲染 -

安全报告生成

六、模型获取指南

| 模型名称 | 类型 | 上下文 | 下载 |

|---|---|---|---|

| Qwen3-Coder-480B-A35B-Instruct | 指令模型 | 256K | Hugging Face |

| FP8优化版 | 推理优化 | 256K | ModelScope |

七、技术路线图

-

多尺寸模型:降低部署成本 -

自我进化:自动优化代码能力 -

复杂任务支持:接管软件工程全流程

timeline

title Qwen3-Coder发展路线

2024 Q3 : 多尺寸模型发布

2024 Q4 : 自我进化验证

2025 : 软件工程全流程支持

八、常见问题解答

Q1:需要什么硬件配置?

支持标准GPU服务器部署,推理时仅需35B参数激活

Q2:如何处理超大代码库?

采用「文件级聚焦」技术:

-

自动识别核心模块 -

分层加载依赖 -

动态上下文管理

Q3:与Qwen2.5的主要差异?

-

上下文扩展8倍(32K→256K) -

代码执行成功率提升25% -

新增工具调用协议

Q4:是否支持本地部署?

支持Hugging Face/ModelScope完整下载,提供FP8优化版本

九、编程语言支持清单

['ABAP','ActionScript','Ada','Agda','Alloy','ApacheConf','AppleScript',

'Arc','Arduino','AsciiDoc','AspectJ','Assembly','Augeas','AutoHotkey',

'AutoIt','Awk','Batchfile','Befunge','Bison','BitBake','BlitzBasic',

... # 完整358种语言见项目文档

'Zephir','Zig','Zimpl','desktop','eC','edn','fish','mupad','nesC','ooc']

警告:使用前务必更新tokenizer,新旧版本特殊token不一致!

加入开发者社区

💬 Discord交流 | 📚 技术文档 | 📜 学术论文

@misc{qwen3technicalreport,

title={Qwen3 Technical Report},

author={Qwen Team},

year={2025},

url={https://arxiv.org/abs/2505.09388}

}

站在智能编程革命的起点,Qwen3-Coder正将「代码大模型」推向新高度。当机器开始理解软件工程的本质,开发者终于能专注于真正创造性的工作。