“

华为昇腾团队研发的MindVL模型,在1/10训练数据下实现与Qwen2.5-VL相当的性能表现,本文深度解析其技术架构与训练策略。

一、MindVL的核心技术创新

1. 原生分辨率视觉处理

传统多模态模型采用固定分辨率切片处理,导致细粒度细节丢失。MindVL突破性采用原生分辨率Vision Transformer,支持:

- ❀

原始图像尺寸直接输入(自动缩放为28倍数) - ❀

动态2D旋转位置编码(RoPE) - ❀

保留复杂图表的全局布局信息

“

📌 实际应用:处理财务报表、医疗影像等密集型视觉内容时,MindVL能捕捉到小数点后两位的数字细节。

2. 昇腾NPU专属优化框架

针对昇腾硬件特性开发的MindSpeed-MLLM框架包含:

- ❀

多模态数据并行加载器 - ❀

动态运算符融合替换(如将Conv2d转换为Matmul) - ❀

NUMA核心绑定优化 - ❀

任务队列流水线调度

实测在910B集群达到40% MFU(模型浮点利用率),接近NVIDIA A100水平。

二、三阶段渐进式训练策略

“

🔍 数据配比:图像对数据300B tokens + 多任务数据140B tokens

2.1 预训练数据构建

1. 通用图文对

- ❀

采用CLIP评分+URL过滤+人工抽检三级清洗 - ❀

图像聚类分层采样保证长尾覆盖

2. 专业领域数据

- ❀

OCR数据:文档OCR(PDF解析)+ 场景OCR(Focus OCR + PaddleOCR交叉验证) - ❀

表格数据:RapidTable布局检测 + LORE关系判断 - ❀

STEM数据:MMMU学科分类 + PDF解析增强

3. 视觉定位数据

- ❀

Florence2-large重标注 + SAM点标注生成 - ❀

引入UMG-41M指代理解数据集

三、模型性能优化技术

1. 模型权重平均

- ❀

不同训练阶段权重融合(预热期+多任务期) - ❀

不同序列长度模型集成(2K/4K/8K) - ❀

在MMBench提升1.9个百分点

2. 测试时分辨率搜索

建立网格搜索空间:

- ❀

最小像素:4/16/32/64 2828 - ❀

最大像素:1280/2048/2560/3072/4096/8192 2828

“

📊 最佳实践:OCR任务推荐min_pixels=16,文档问答推荐max_pixels=3072

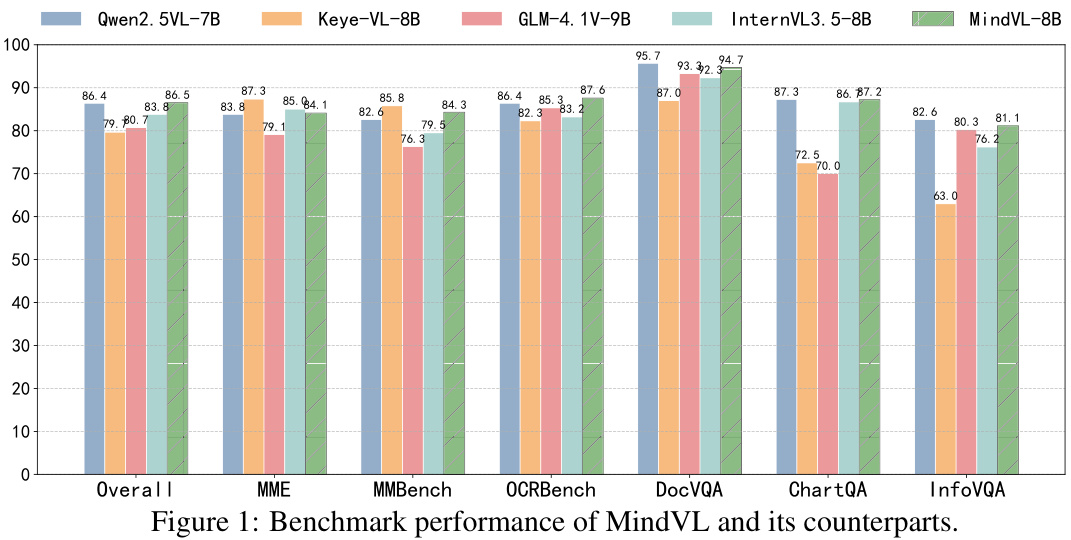

四、性能表现对比

“

✅ 关键突破:在OCR任务中超越Qwen2.5-VL 1.2个百分点

五、部署与使用建议

1. 硬件要求

- ❀

昇腾910B/910B2系列NPU - ❀

建议使用8卡以上集群训练

2. 推理优化

# 示例代码:分辨率自适应推理

from mindspore import Tensor

import mindspore.numpy as np

def dynamic_resize(image):

min_pixels = 16*28*28 # OCR任务推荐值

max_pixels = 3072*28*28 # 文档任务推荐值

# 实现动态缩放逻辑...

3. 微调建议

- ❀

领域适配:建议在预训练基础上进行LoRA微调 - ❀

计算资源:单卡910B可处理7B模型微调

常见问题解答

Q: MindVL如何处理不同分辨率的图像?

A: 通过动态2D RoPE编码自动适配原始尺寸,输入时会自动缩放为28的整数倍。

Q: 模型支持哪些语言?

A: 主要优化中文场景,但在英文测试中表现同样优异,支持中英双语混合输入。

Q: 如何获取模型权重?

A: 目前未开源,但可通过华为云ModelArts平台申请试用。

Q: OCR性能提升的关键是什么?

A: 文档OCR数据增强策略 + 原生分辨率处理 + 测试时分辨率优化

未来发展方向

- ❀

支持更大参数模型(如基于DeepSeek-V3的71B版本) - ❀

扩展多语言能力 - ❀

开发端侧轻量版本

“

📌 行业意义:首次在国产AI芯片上实现国际领先的多模态模型训练,为自主可控AI生态奠定基础。

本文基于华为昇腾团队2025年2月发表的《MindVL: Towards Efficient and Effective Training of Multimodal Large Language Models on Ascend NPUs》论文整理,保留核心技术细节,去除冗余学术表述。