GLM-4.7:全面提升的编码助手,为你的开发工作赋能

摘要

GLM-4.7是一款进阶的编码助手,在多语言代理编码、终端任务、UI设计、工具使用及复杂推理等方面较前代GLM-4.6有显著提升,本文详解其性能、案例及使用方法。

如果你是一名开发者,或者经常需要与代码、设计打交道,那么一款高效、智能的工具绝对能让你的工作事半功倍。今天,我们要聊的就是这样一款工具——GLM-4.7。它到底有什么过人之处?能给我们的工作带来哪些实际帮助?又该如何上手使用呢?接下来,就让我们一步步揭开它的面纱。

GLM-4.7:你的全新编码伙伴

GLM-4.7作为一款全新的编码伙伴,可不是简单的版本升级,它在多个关键领域都带来了令人惊喜的进步。无论是核心的编码能力,还是UI设计、工具使用,甚至是复杂的推理任务,都有了质的飞跃。

核心编码能力:多场景下的显著提升

对于开发者来说,核心编码能力无疑是最受关注的。GLM-4.7在这方面交出了一份亮眼的成绩单。

和它的前代产品GLM-4.6相比,GLM-4.7在多语言代理编码和基于终端的任务中表现出了明显的优势。具体来看,在SWE-bench基准测试中,它的得分达到了73.8%,比GLM-4.6提升了5.8个百分点;在多语言的SWE-bench测试中,更是取得了66.7%的成绩,提升幅度高达12.9%;而在Terminal Bench 2.0上,得分41%,较前代提升了16.5%。

不仅如此,GLM-4.7还具备了“先思考后行动”的能力。这一点在复杂任务中尤为重要,它能在主流的代理框架中,如Claude Code、Kilo Code、Cline和Roo Code等,带来显著的性能提升。想象一下,在处理一个复杂的编码任务时,它会先在“脑海”里梳理思路,再动手编码,这样是不是能减少很多不必要的错误和返工?

vibe编码:让设计更上一层楼

除了核心编码,GLM-4.7在UI质量上也迈出了一大步。我们都知道,一个干净、现代的网页,或者一套布局精准、尺寸合适的幻灯片,能给人带来完全不同的视觉体验。

GLM-4.7在“vibe coding”方面的进步,就体现在它能生成更整洁、更现代的网页,设计出更美观的幻灯片。无论是布局的合理性还是尺寸的准确性,都有了明显的提升。这对于需要兼顾开发和简单设计工作的人来说,无疑是个好消息,不用再为了调整一个布局细节而耗费大量时间了。

工具使用:效率倍增的秘密武器

在实际工作中,我们很少能仅凭代码完成所有任务,往往需要借助各种工具。GLM-4.7在工具使用方面的提升,也让它的实用性大大增强。

在τ²-Bench等基准测试中,GLM-4.7的表现有了显著提高;通过BrowseComp进行网页浏览时,效率也更高。这意味着,当你需要调用外部工具来获取信息、处理数据时,GLM-4.7能更流畅、更准确地完成操作,帮你节省宝贵的时间。

复杂推理:数学与逻辑能力的飞跃

复杂推理能力,尤其是数学和逻辑推理,是衡量一款智能工具是否“聪明”的重要标准。GLM-4.7在这方面也有不小的突破。

在HLE(Humanity’s Last Exam)基准测试中,GLM-4.7的得分达到了42.8%,比GLM-4.6提升了12.4%。这意味着它在解决复杂的数学问题、进行逻辑推理时,思路更清晰,结果更准确。无论是处理数据分析中的数学模型,还是解决编程中遇到的逻辑难题,它都能成为你的得力助手。

当然,除了这些核心领域,GLM-4.7在聊天、创意写作、角色扮演等其他场景中,也有显著的进步。可以说,它是一款全方位提升的智能工具。

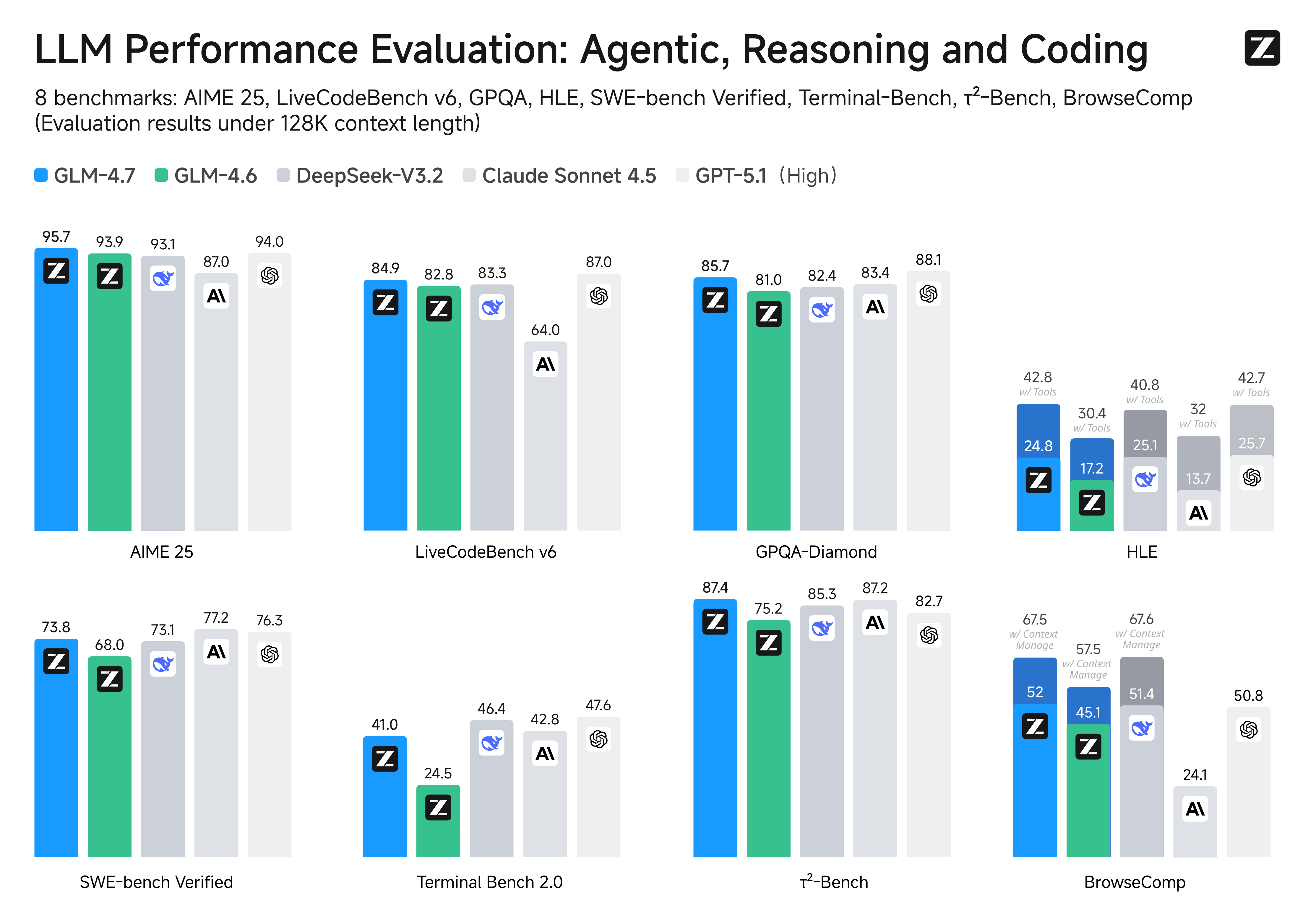

基准测试表现:GLM-4.7与同类模型的正面交锋

可能你会好奇,GLM-4.7和目前市场上的其他主流模型相比,到底处于什么水平?下面这份表格就详细对比了GLM-4.7与GLM-4.6、Kimi K2 Thinking、DeepSeek-V3.2、Gemini 3.0 Pro、Claude Sonnet 4.5、GPT-5 High、GPT-5.1 High在17项基准测试中的表现,这些测试包括8项推理测试、5项编码测试和3项代理测试。

| 基准测试 | GLM-4.7 | GLM-4.6 | Kimi K2 Thinking | DeepSeek-V3.2 | Gemini 3.0 Pro | Claude Sonnet 4.5 | GPT-5 High | GPT-5.1 High |

|---|---|---|---|---|---|---|---|---|

| 推理 | ||||||||

| MMLU-Pro | 84.3 | 83.2 | 84.6 | 85.0 | 90.1 | 88.2 | 87.5 | 87.0 |

| GPQA-Diamond | 85.7 | 81.0 | 84.5 | 82.4 | 91.9 | 83.4 | 85.7 | 88.1 |

| HLE | 24.8 | 17.2 | 23.9 | 25.1 | 37.5 | 13.7 | 26.3 | 25.7 |

| HLE (w/ Tools) | 42.8 | 30.4 | 44.9 | 40.8 | 45.8 | 32.0 | 35.2 | 42.7 |

| AIME 2025 | 95.7 | 93.9 | 94.5 | 93.1 | 95.0 | 87.0 | 94.6 | 94.0 |

| HMMT Feb. 2025 | 97.1 | 89.2 | 89.4 | 92.5 | 97.5 | 79.2 | 88.3 | 96.3 |

| HMMT Nov. 2025 | 93.5 | 87.7 | 89.2 | 90.2 | 93.3 | 81.7 | 89.2 | – |

| IMOAnswerBench | 82.0 | 73.5 | 78.6 | 78.3 | 83.3 | 65.8 | 76.0 | – |

| LiveCodeBench-v6 | 84.9 | 82.8 | 83.1 | 83.3 | 90.7 | 64.0 | 87.0 | 87.0 |

| 代码代理 | ||||||||

| SWE-bench Verified | 73.8 | 68.0 | 71.3 | 73.1 | 76.2 | 77.2 | 74.9 | 76.3 |

| SWE-bench Multilingual | 66.7 | 53.8 | 61.1 | 70.2 | – | 68.0 | 55.3 | – |

| Terminal Bench Hard | 33.3 | 23.6 | 30.6 | 35.4 | 39.0 | 33.3 | 30.5 | 43.0 |

| Terminal Bench 2.0 | 41.0 | 24.5 | 35.7 | 46.4 | 54.2 | 42.8 | 35.2 | 47.6 |

| 通用代理 | ||||||||

| BrowseComp | 52.0 | 45.1 | – | 51.4 | – | 24.1 | 54.9 | 50.8 |

| BrowseComp (w/ Context Manage) | 67.5 | 57.5 | 60.2 | 67.6 | 59.2 | – | – | – |

| BrowseComp-ZH | 66.6 | 49.5 | 62.3 | 65.0 | – | 42.4 | 63.0 | – |

| τ²-Bench | 87.4 | 75.2 | 74.3 | 85.3 | 90.7 | 87.2 | 82.4 | 82.7 |

从表格中我们可以清晰地看到,在不同的测试项目中,GLM-4.7各有胜负。比如在HMMT Feb. 2025测试中,它以97.1的得分表现出色;在τ²-Bench中,87.4的得分也处于上游水平。当然,有些项目中其他模型表现更优,但总体来说,GLM-4.7在众多主流模型中占据了一席之地,尤其考虑到它相比前代的大幅提升,其进步是有目共睹的。

其实,AGI(人工通用智能)的发展是一段漫长的旅程,基准测试只是评估其性能的一种方式。虽然这些指标提供了必要的参考,但最重要的还是实际使用中的“感受”。真正的智能不仅仅是在测试中取得好成绩,或者处理数据更快,最终衡量AGI成功与否的标准,是它能否无缝地融入我们的生活——而“编码”正是其中重要的一环。

实际案例展示:GLM-4.7能做些什么?

说了这么多性能和数据,可能你还是会想:GLM-4.7在实际应用中到底能做出什么样的成果?别担心,下面这些案例会让你有更直观的感受。

前端开发展示

有用户提出需求:“构建一个HTML网站,要求高对比度深色模式+粗体紧凑标题+动画滚动条+厚实的分类标签+磁性CTA(号召性按钮)。”

GLM-4.7成功完成了这个任务,如果你想查看完整的实现过程,可以访问Z.ai上的完整轨迹。想象一下,仅仅通过这样一段描述,就能得到一个符合要求的网页雏形,是不是大大节省了开发时间?

体素艺术环境设计展示

还有一个需求是:“设计一个精心制作的体素艺术环境,其中包含一座华丽的宝塔,位于一个充满活力的花园中。包括各种植被——尤其是樱花树——并确保构图充满活力、色彩丰富且视觉冲击力强。可以使用任何体素或WebGL库,但需将整个项目作为单个自包含的HTML文件交付,以便我可以直接粘贴并在Chrome中打开。”

GLM-4.7也完美响应了这个需求,完整的实现过程可以查看这里。对于需要快速制作可视化内容的设计师或开发者来说,这样的能力无疑是非常实用的。

海报设计展示

有人需要“设计一张介绍巴黎的海报,具有浪漫和时尚的美感。整体风格应显得优雅、视觉精致且注重设计感。”

GLM-4.7同样交出了令人满意的答卷,完整轨迹可访问Z.ai链接。从这个案例可以看出,它不仅能处理代码相关的任务,在设计领域也有不错的表现。

除了这些,GLM-4.7在幻灯片制作等方面也有出色的展示,足以证明它的多功能性和实用性。

开始使用GLM-4.7:你需要知道的一切

了解了GLM-4.7的强大功能和实际案例后,你是不是已经迫不及待想试试了?别着急,下面就为你详细介绍如何开始使用这款工具,以及它的一些特色功能。

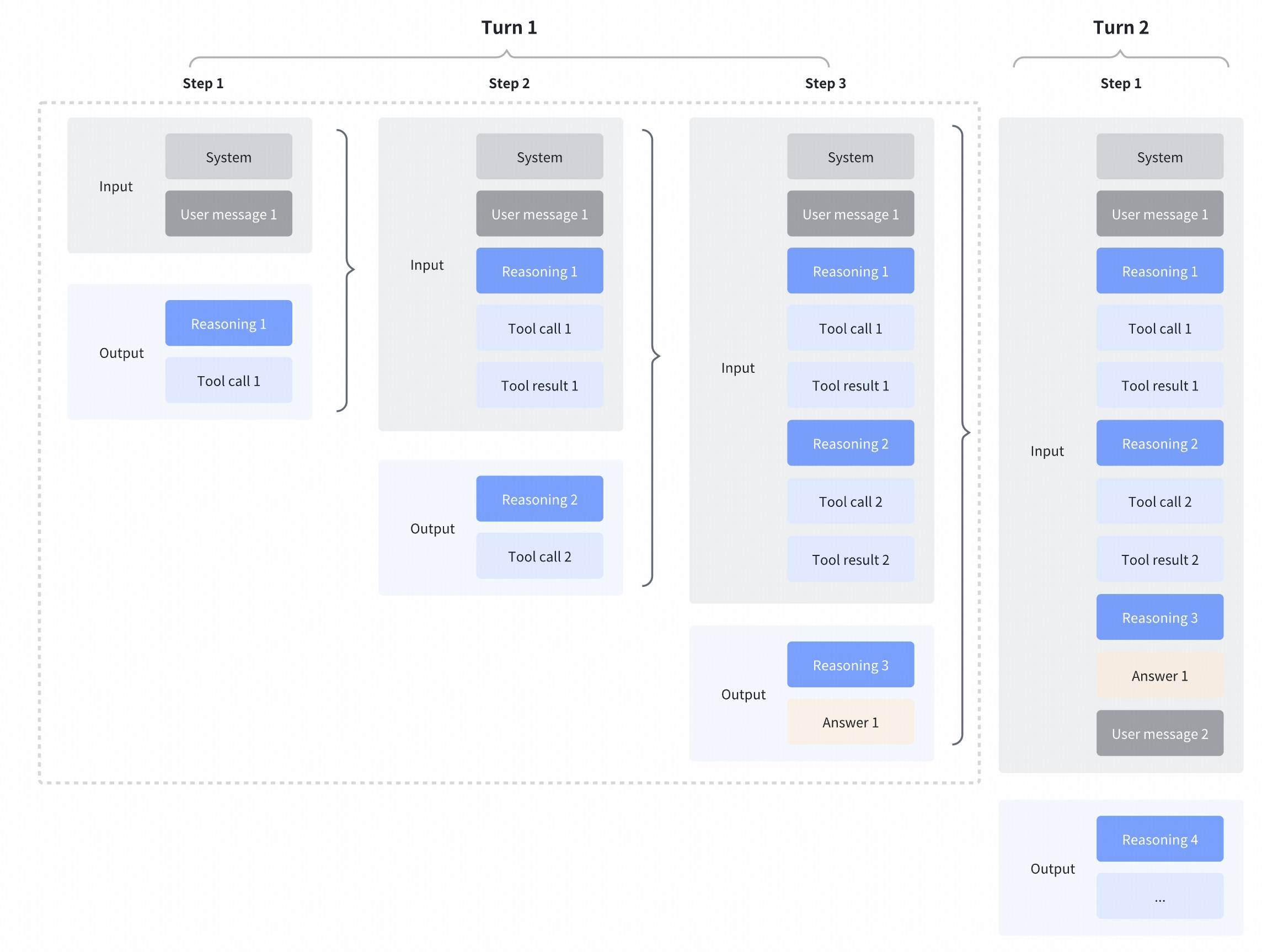

交错思考与保留思考:让复杂任务更稳定可控

GLM-4.7增强了自GLM-4.5以来引入的“交错思考”(Interleaved Thinking)功能,并进一步推出了“保留思考”(Preserved Thinking)和“回合级思考”(Turn-level Thinking)。通过在行动之间进行思考,并在多个回合中保持一致性,它使得复杂任务的处理更加稳定和可控。

-

交错思考:GLM-4.7在每次响应和调用工具之前都会进行思考,这有助于提高对指令的遵循度和生成内容的质量。就像我们在做一件事之前会先想清楚步骤一样,它也会“深思熟虑”后再行动。 -

保留思考:在编码代理场景中,GLM-4.7会自动保留多轮对话中的所有思考块,重用已有的推理结果,而不是从头重新推导。这减少了信息丢失和不一致性,非常适合处理长期、复杂的任务。比如在一个持续多天的编码项目中,它不会忘记之前的思路,能更好地保持任务的连贯性。 -

回合级思考:GLM-4.7支持在一个会话中按回合控制推理——对于轻量请求,可以禁用思考功能以减少延迟和成本;对于复杂任务,则启用思考功能以提高准确性和稳定性。这样的灵活性让你可以根据实际需求调整,兼顾效率和效果。

想了解更多细节,可以访问相关指南。

通过Z.ai API平台调用GLM-4.7

Z.ai API平台提供了GLM-4.7模型的调用服务。如果你想通过API将GLM-4.7集成到自己的应用或工作流中,可以参考详细的API文档和集成指南。同时,该模型也可以通过OpenRouter在全球范围内使用,访问OpenRouter官网即可了解更多。

在编码代理中使用GLM-4.7

GLM-4.7现在可以在多个编码代理中使用,如Claude Code、Kilo Code、Roo Code、Cline等。

-

对于GLM编码计划订阅者:你会自动升级到GLM-4.7。如果你之前自定义过应用配置(比如Claude Code中的 ~/.claude/settings.json),只需将模型名称更新为“glm-4.7”即可完成升级。 -

对于新用户:订阅GLM编码计划意味着你可以以更低的成本使用达到Claude级别性能的编码模型——价格仅为其1/7,而使用配额却是3倍。想要开始使用,可以访问订阅页面。

在Z.ai上与GLM-4.7聊天

GLM-4.7可以通过Z.ai访问。你只需将模型选项更改为“GLM-4.7”即可开始使用,如果系统没有自动更改,手动设置一下就好。

本地部署GLM-4.7

如果你希望在本地使用GLM-4.7,也完全可以实现。GLM-4.7的模型权重在HuggingFace(链接)和ModelScope(链接)上公开可用。

对于本地部署,GLM-4.7支持vLLM和SGLang等推理框架。详细的部署说明可以在官方GitHub仓库中找到,按照步骤操作,你就能在自己的设备上运行GLM-4.7了。

一些你可能关心的细节

在使用过程中,你可能会好奇一些参数设置或测试条件,这里为你说明一下:

-

默认设置(大多数任务):温度1.0,top-p 0.95,最大新令牌131072。对于多轮代理任务(τ²-Bench和Terminal Bench 2),启用保留思考模式。 -

Terminal Bench和SWE-bench Verified设置:温度0.7,top-p 1.0,最大新令牌16384。 -

τ²-Bench设置:温度0,最大新令牌16384。在τ²-Bench中,我们在零售和电信交互中添加了额外的提示,以避免因用户错误结束交互而导致的失败;在航空领域,我们应用了Claude Opus 4.5发布报告中提出的领域修复方案。

常见问题解答(FAQ)

GLM-4.7和GLM-4.6相比,主要提升在哪些方面?

GLM-4.7在多个方面较GLM-4.6有显著提升:核心编码上,SWE-bench得分73.8%(+5.8%)、SWE-bench多语言66.7%(+12.9%)、Terminal Bench 2.0 41%(+16.5%);复杂推理上,HLE(w/ Tools)42.8%(+12.4%);还在UI设计、工具使用等方面有进步。

如何在编码代理中升级到GLM-4.7?

如果是GLM编码计划订阅者,会自动升级;若之前自定义过应用配置,只需将模型名称更新为“glm-4.7”即可。新用户订阅GLM编码计划后可直接使用。

GLM-4.7支持本地部署吗?

支持。其模型权重在HuggingFace和ModelScope上公开,支持vLLM和SGLang等推理框架,详细部署说明在官方GitHub仓库。

GLM-4.7在哪些基准测试中表现较好?

在HMMT Feb. 2025中得97.1分,τ²-Bench中得87.4分,AIME 2025中得95.7分,这些测试中表现较为突出。

什么是“保留思考”功能?

在编码代理场景中,GLM-4.7会自动保留多轮对话中的所有思考块,重用已有推理结果,减少信息丢失和不一致性,适合长期、复杂任务。

可以通过API调用GLM-4.7吗?

可以。Z.ai API平台提供该服务,可参考官方API文档;同时也可通过OpenRouter在全球范围内使用。

GLM-4.7作为一款不断进化的编码助手,无论是性能提升还是功能创新,都展现出了它在智能工具领域的潜力。无论你是专业开发者、设计师,还是需要处理复杂任务的职场人,它都有可能成为你工作中的得力伙伴。现在,不妨按照上面的方法,亲自体验一下GLM-4.7带来的便利吧!