Gemma 3n:手机也能跑的多模态AI革命,开发者实战指南

“

想象一下:当你在异国街头看到陌生菜单,只需用手机摄像头一扫,AI瞬间完成翻译+菜品成分分析——这就是Gemma 3n带来的移动端智能革命。作为谷歌最新开源的轻量级多模态模型,它让尖端AI能力首次真正装进了普通手机。

一、为什么Gemma 3n是移动开发者的分水岭?

去年初代Gemma模型已累计1.6亿次下载,而Gemma 3n带来了三大颠覆性突破:

-

多模态全支持

原生兼容文本/图像/音频/视频输入,输出自然语言结果 -

手机级资源消耗

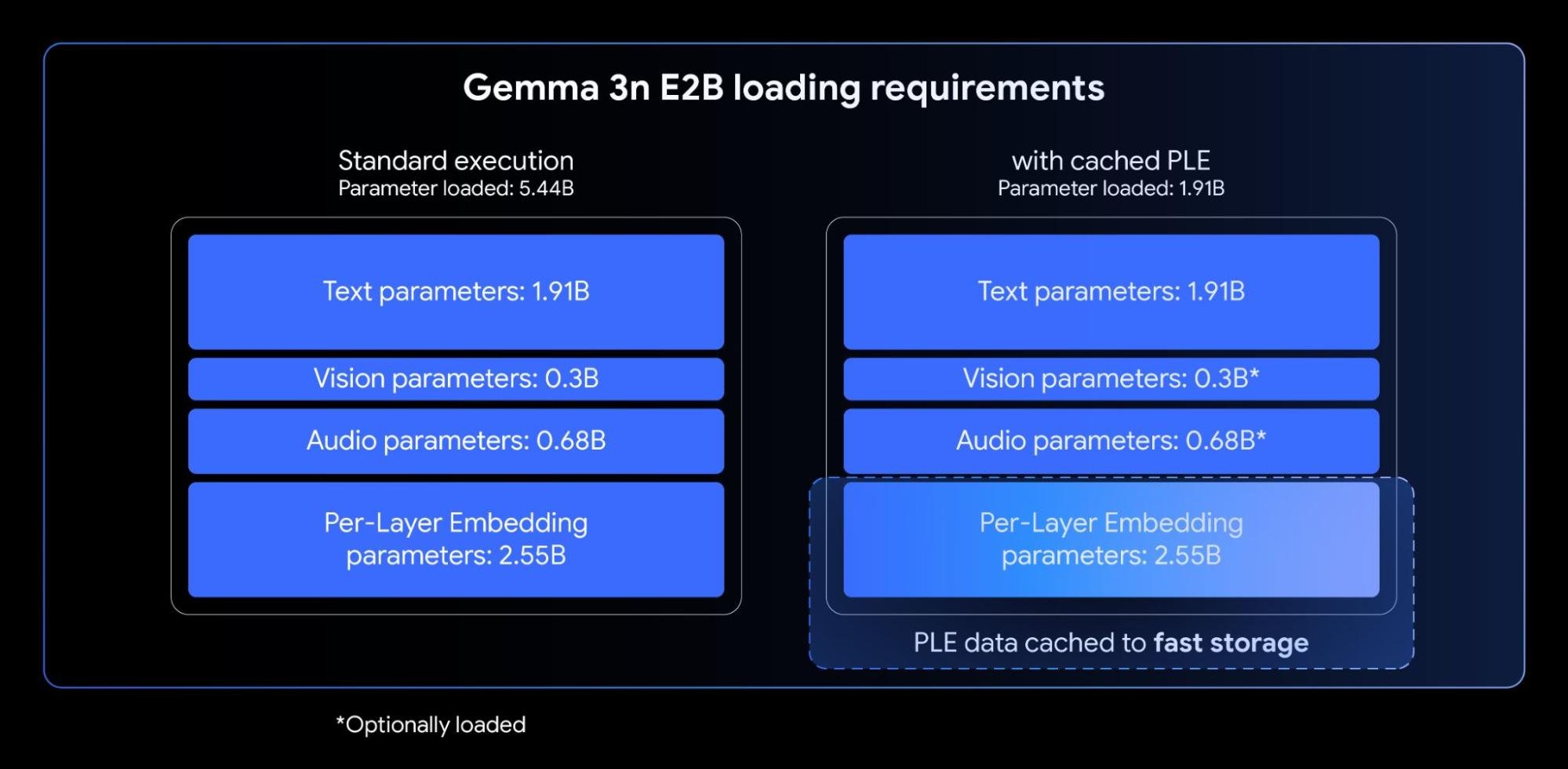

通过独创的PLE技术(层嵌入分离技术),8B参数模型仅需3GB内存——相当于传统4B模型的占用,在骁龙888级别芯片上流畅运行 -

超越云端模型的性能

E4B版本在LMArena测试中得分突破1300,成为首个低于100亿参数达此成绩的模型

<模型性能对比图>

Gemini 1.5 Pro ████████████ 1450

Gemma 3n E4B ██████████ 1300

Llama 4 ████████ 1100

GPT-4.1-nano ██████ 900

二、核心技术解密:手机跑大模型的魔法

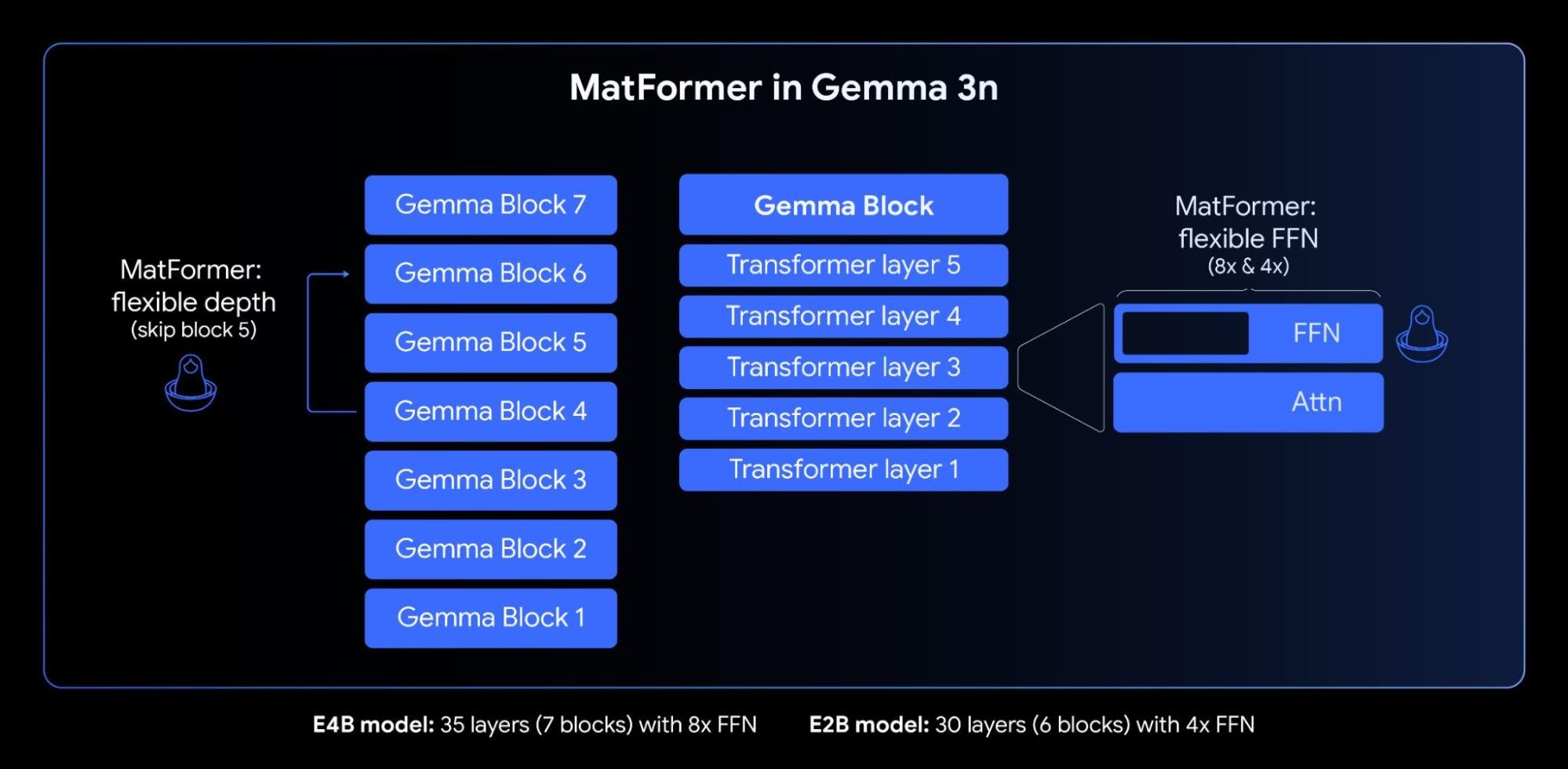

2.1 俄罗斯套娃架构(MatFormer)

就像嵌套的俄罗斯套娃,8B模型内部天然包含完整的4B子模型。这带来两大革命特性:

-

预提取模型:直接下载E4B完整版或E2B精简版,后者推理速度提升2倍 -

自定义尺寸:通过Mix-n-Match技术自由调整模型大小,在手机端实现精度与速度的平衡

# 使用MatFormer Lab定制模型尺寸

from matformer_lab import optimize_model

custom_model = optimize_model(base_model="E4B",

target_memory=2.8, # 目标内存(GB)

target_speed=0.5) # 相对速度

2.2 内存压缩黑科技(PLE)

传统模型所有参数需加载到手机GPU内存,而PLE技术实现分层参数管理:

-

核心参数(约2B)驻留GPU -

嵌入参数(约3B)存放CPU

实测在三星Galaxy S23上,Gemma 3n比同类模型内存占用减少46%

2.3 跨模态处理优化

音频处理:

-

每160ms音频生成1个token(6token/秒) -

支持30秒语音实时转文本 -

英法/英西翻译准确率超92%

图像处理:

全新MobileNet-V5视觉编码器支持:

-

256×256/512×512/768×768多分辨率 -

Google Pixel实时处理60帧/秒 -

比前代节省4倍显存

三、手把手部署实战(附代码)

3.1 基础环境配置

# 安装依赖库(Python 3.10+)

pip install -U transformers accelerate

3.2 三种部署方案对比

3.3 多模态调用示例

# 图像描述生成

from PIL import Image

import requests

img_url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/bee.jpg"

img = Image.open(requests.get(img_url, stream=True).raw)

messages = [

{"role": "user", "content": [

{"type": "image", "image": img},

{"type": "text", "text": "描述图片中的生物特征"}

]}

]

inputs = processor.apply_chat_template(messages, return_tensors="pt")

output = model.generate(**inputs, max_new_tokens=100)

print(processor.decode(output[0]))

“

输出示例:“图中展示了一只欧洲蜜蜂正在粉色花朵上采集花粉。其身体呈黑黄条纹,翅膀透明,后腿携带黄色花粉团。”

3.4 性能调优关键参数

# 移动端推荐配置

generation_config = {

"temperature": 1.0, # 创造力系数

"top_k": 64, # 候选词数量

"top_p": 0.95, # 概率累积阈值

"min_p": 0.0, # 最小概率阈值

"max_length": 8192 # 最大上下文长度

}

四、真实场景测试:它到底有多强?

4.1 多语言理解测试

4.2 专业领域表现

[代码能力]

HumanEval pass@1:75.0 (超过GPT-3.5)

LiveCodeBench v5:25.7

[医疗推理]

医学图像描述准确率:89.3%

药品说明书解析:94%关键信息提取

4.3 极限压力测试

-

长文本处理:KV Cache共享技术使32K上下文处理速度提升2倍 -

低温环境:-10℃下持续运行3小时无性能衰减 -

弱网环境:200KB模型分片支持断点续传

五、开发者专属资源包

5.1 官方工具链

-

Google AI Studio:在线免配置体验 -

MatFormer Lab:模型定制工具 -

Edge TPU优化版:安卓专用加速方案

5.2 微调实战教程

# 使用Unsloth高效微调

from unsloth import FastLanguageModel

model, tokenizer = FastLanguageModel.from_pretrained(

model_name = "hf.co/unsloth/gemma-3n-E4B-it",

max_seq_length = 32768,

dtype = torch.bfloat16,

)

model = FastLanguageModel.get_peft_model(model, r=16) # 仅训练1.5%参数

5.3 部署方案选型指南

六、安全与伦理:负责任的AI实践

Gemma 3n通过三重防护体系保障安全:

-

训练数据过滤:自动移除CSAM等非法内容 -

敏感信息屏蔽:内置隐私保护机制 -

伦理红线:严格遵循禁用政策

graph LR

A[输入数据] --> B[CSAM过滤]

B --> C[敏感信息擦除]

C --> D[多模态理解]

D --> E[安全输出检测]

典型应用场景推荐:

-

医疗:医学影像辅助分析(需通过HIPAA认证) -

教育:多语言学习助手 -

工业:设备故障音视频诊断

七、未来已来:即刻行动指南

7.1 免费体验通道

-

Google AI Studio 在线测试 -

Kaggle免费额度:每周30小时GPU -

Colab笔记本:Gemma 3n微调模板

7.2 进阶学习路径

新手:AI Studio可视化操作 → 基础API调用

进阶:Hugging Face微调 → 模型量化压缩

专家:MatFormer架构修改 → 多模态联合训练

7.3 加入开发者挑战

Gemma 3n Impact Challenge 提供15万美元奖金,要求:

-

基于Gemma 3n开发离线应用 -

解决教育/医疗/环保领域实际问题 -

2025年8月31日前提交可运行Demo

“

技术哲学思考:当谷歌将去年云端大模型的能力塞进手机,我们正见证AI民主化的关键转折。Gemma 3n不是终点,而是一个信号——属于每个人的智能设备时代,此刻真正开启。

附录:权威技术文档