2026年AI的关键转折:为什么我们需要Agent Harness?

AI技术正站在一个关键的转折点上。在过去几年里,整个行业的目光仅仅聚焦于模型本身。我们习惯了问:“这个模型有多聪明?”我们沉迷于查阅各种排行榜和基准测试,只为了弄清楚模型A是否击败了模型B。然而,这种单维度的评估方式正在失效。

顶级模型在静态排行榜上的差距正在缩小,但这可能是一种假象。当任务变得越长、越复杂时,模型之间的差距就会变得清晰无比。这最终归结为“耐用性”:一个模型在执行数百次工具调用的长时间跨度中,究竟能在多大程度上持续遵循指令。

在排行榜上1%的微小差异,根本无法检测出一个模型在五十步之后是否会偏离轨道。为了展示真正的能力、性能和改进,我们需要一种全新的方式。我们需要能够证明模型可以可靠地执行数天工作流的系统。而“Agent Harness”正是这一问题的答案。

什么是Agent Harness?

Agent Harness是包裹在AI模型周围用于管理长时运行任务的基础设施。这非常重要:它不是Agent本身,而是管理Agent如何运行的软件系统。它的核心职责是确保Agent保持可靠、高效和可操控。

要理解它,我们可以将其与现有的技术层级进行对比。Agent Harness的运作层级高于Agent框架。框架可能只提供工具的构建块或实现代理循环,而Harness则更进一步,它提供了提示词预设、对工具调用的独到处理、生命周期挂钩,或者是现成可用的能力,比如规划、文件系统访问或子代理管理。如果说框架是零件,那么Harness就是“自带电池”的整机系统。

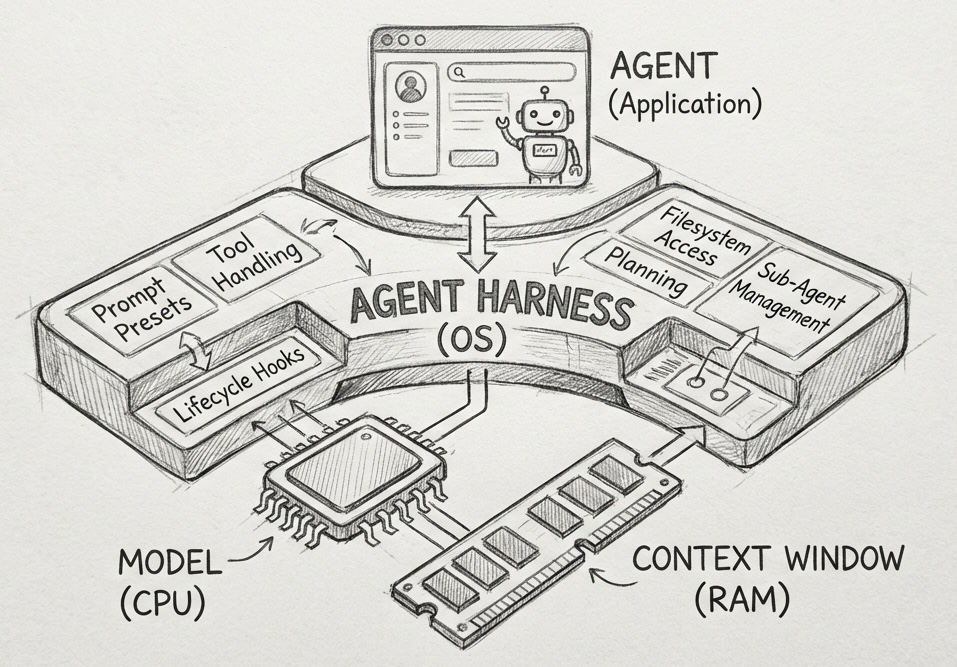

为了更直观地理解,我们可以用一个计算机系统的比喻来可视化这种关系:

-

模型是CPU: 它提供原始的处理能力。 -

上下文窗口是RAM: 它是有限的、易失的工作记忆。 -

Agent Harness是操作系统: 它管理上下文,处理“启动”序列(如提示词、挂钩),并提供标准驱动程序(如工具处理)。 -

Agent是应用程序: 它是运行在操作系统之上的特定用户逻辑。

在这个架构中,Agent Harness实施了“上下文工程”策略,例如通过压缩来减少上下文、将状态卸载到存储设备,或者将任务隔离到子代理中。对于开发者而言,这意味着你可以跳过构建操作系统的繁琐工作,完全专注于应用程序本身,即定义你的Agent所独有的逻辑。

目前,通用的Harness还比较罕见。Claude Code是这一新兴类别中的典型例子,它试图通过Claude Agent SDK或LangChain DeepAgents来实现标准化。不过,也可以说,所有的编码CLI在某种程度上都是针对特定垂直领域的专用Agent Harness。

基准测试的困境与Agent Harness的必要性

过去,基准测试主要针对单回合的模型输出。最近一年,我们开始看到一种评估系统而非原始模型的趋势,即模型作为一个组件,可以使用工具或与环境交互(例如AIMO, SWE-Bench)。

然而,这些较新的基准测试在衡量“可靠性”方面面临困境。它们很少测试模型在第50次或第100次工具调用/回合后的表现。但这正是真正的困难所在。一个模型可能足够聪明,能在一两次尝试内解决一个难题,但在运行一小时后,却无法遵循初始指令或对中间步骤进行正确推理。标准基准测试难以捕捉长工作流所需的耐用性。

随着基准测试变得越来越复杂,我们需要弥合基准测试声明与用户体验之间的差距。Agent Harness在这一过程中至关重要,原因有三:

1. 验证现实世界的进展

基准测试往往与用户需求错位。随着新模型频繁发布,Harness允许用户轻松测试和比较最新模型在其特定用例和约束条件下的表现,从而验证真实的进步。

2. 赋能用户体验

如果没有Harness,用户体验可能会落后于模型的潜力。发布Harness允许开发者使用经过验证的工具和最佳实践来构建Agent。这确保了用户与具有相同系统结构的产品进行交互,从而获得一致的体验。

3. 通过现实反馈进行“爬山”

一个共享、稳定的环境构成了反馈循环,研究人员可以基于实际用户的采用情况迭代和改进(即“爬山”)基准测试。

改进系统的能力与验证其输出的难易程度成正比。Harness将模糊、多步骤的Agent工作流转化为我们可以记录和评估的结构化数据,从而让我们能够有效地进行“爬山”优化。

构建Agent过程中的“苦涩教训”

Rich Sutton曾写过一篇著名的文章《苦涩教训》。他认为,利用计算能力的通用方法总是能击败手工编码的人类知识。这一教训目前正在Agent开发领域重演。

我们可以看到具体的案例数据:

-

Manus在六个月内将其Harness重构了五次,以消除僵化的假设。 -

LangChain在一年内将其“开放深度研究”Agent重新架构了三次。 -

Vercel移除了其Agent工具的80%,从而导致了更少的步骤、更少的Token和更快的响应。

为了在“苦涩教训”中生存下来,我们的基础设施必须足够轻量级。每一个新模型的发布,都带来了构建Agent的最佳方式。在2024年需要复杂的手工编码管道才能实现的能力,在2026年可能只需要一个上下文窗口的提示词就能处理。

开发者必须构建允许他们随时剔除昨天编写的“智能”逻辑的Harness。如果你过度设计了控制流,下一次模型更新就会破坏你的系统。

下一步是什么?Agent Harness的未来趋势

我们正朝着训练环境和推理环境的融合迈进。一个新的瓶颈正在出现,那就是“上下文耐久性”。Harness将成为解决“模型漂移”的主要工具。实验室将利用Harness精确检测模型在第100步后何时停止遵循指令或推理正确。这些数据将被直接反馈到训练中,以创建不会在长任务中“疲劳”的模型。

作为构建者和开发者,我们的关注点应该发生以下转移:

1. 从简单开始

不要构建庞大的控制流。提供强大的原子工具。让模型来制定计划。实施护栏、重试和验证机制。

2. 构建以删除为目标

让你的架构保持模块化。新模型将取代你的逻辑。你必须准备好剔除代码。

3. Harness就是数据集

竞争优势不再仅仅是提示词,而是你的Harness捕获的轨迹。每次你的Agent在工作流后期未能遵循指令,都可以用于训练下一次迭代。

常见问题解答(FAQ)

Agent Harness和Agent框架有什么区别?

Agent框架通常提供构建工具或实现代理循环的基本构建块。而Agent Harness位于更高的层级,它不仅包含这些功能,还提供了提示词预设、对工具调用的独到处理、生命周期挂钩以及规划、文件系统访问等现成能力。简单来说,框架是零件,而Harness是自带电池的完整系统。

为什么现有的基准测试无法评估Agent的性能?

现有的基准测试大多关注单回合输出或简单的系统交互。它们很少测试模型在第50次或第100次工具调用后的表现。而在长时间运行的任务中,模型可能会在后期偏离指令或推理失败,这种“耐用性”问题是标准基准测试无法捕捉的。

开发者为什么要关注“模型漂移”?

随着任务持续时间的增加,模型可能会出现“疲劳”,即在执行了一定数量的步骤后停止正确遵循指令或推理。这就是模型漂移。Agent Harness能够检测这种现象发生的具体时刻(例如第100步),并将这些数据反馈给实验室,用于训练更耐用的模型。

为什么说“构建以删除为目标”是未来的开发准则?

这是因为模型的能力在飞速进化。今天需要复杂代码实现的功能,明天可能只需要一个简单的提示词。如果架构过于僵化或过度设计,下一次模型更新就会导致系统崩溃。保持模块化,随时准备用新的模型能力替换旧的控制流,是适应这一变化的关键。

Agent Harness如何帮助提升用户体验?

通过提供一个共享、稳定的系统结构,Harness确保了开发者使用经过验证的最佳实践进行构建。这意味着用户无论何时使用基于该Harness的Agent,都能获得一致的、优化的体验,而不会因为底层模型的变化而遭受体验下降。