GLM-5 深度解析:面向 Agentic Engineering 的下一代旗舰模型实战指南

本文核心问题:GLM-5 究竟是一款什么样的模型,为何它被定义为面向“Agentic Engineering”的旗舰基座?

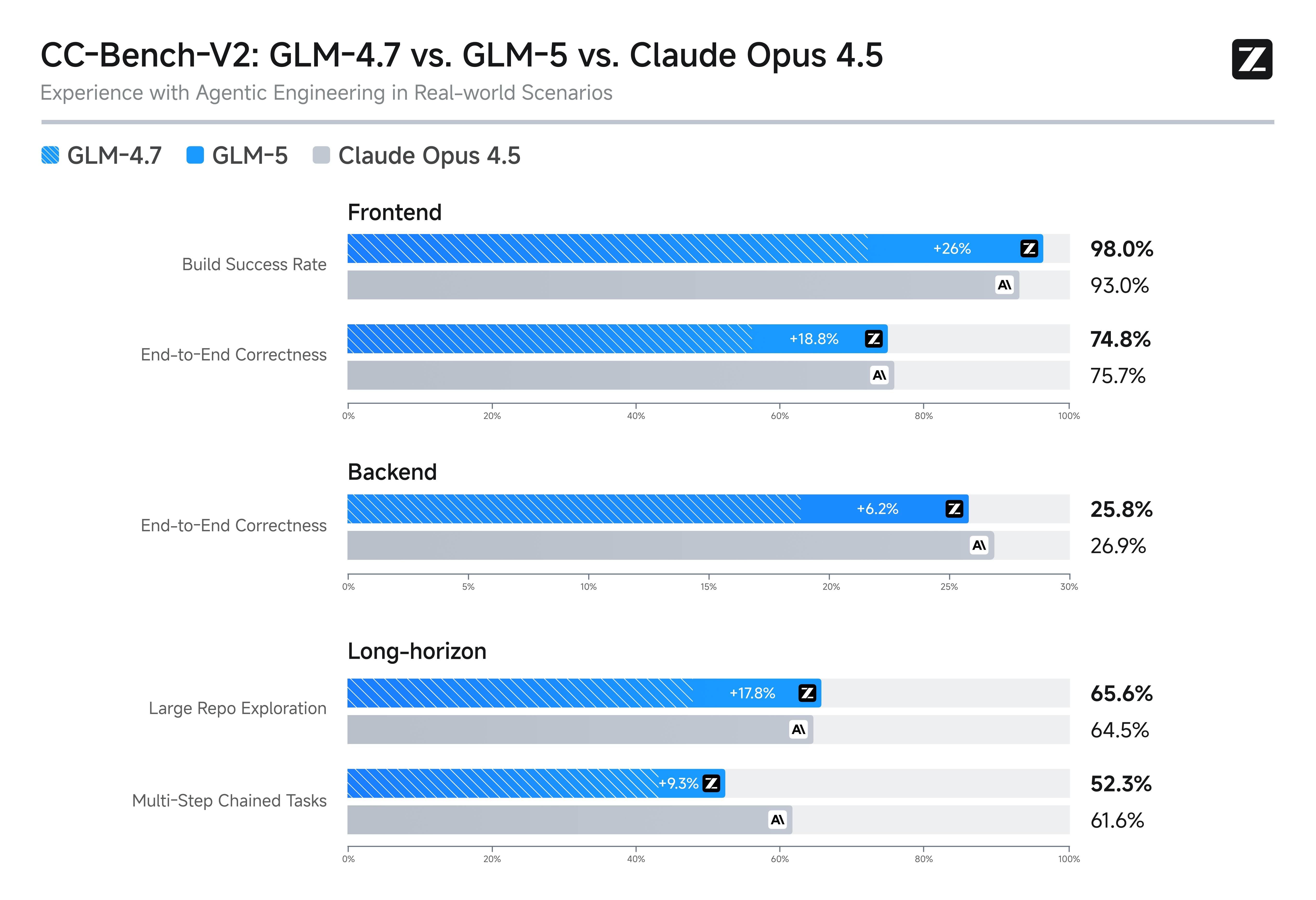

GLM-5 是智谱 AI 推出的新一代旗舰基座模型,其核心设计理念不再局限于单一任务的问答,而是全面转向“Agentic Engineering”(智能体工程)。简单来说,它旨在成为能够处理复杂系统工程、执行长程任务的可靠生产力工具。该模型在编程与智能体能力上达到了开源模型的 SOTA(State-of-the-art)水平,其真实编程场景的使用体验已逼近 Claude Opus 4.5,特别擅长在模糊复杂的目标下进行自主决策与工具调用。

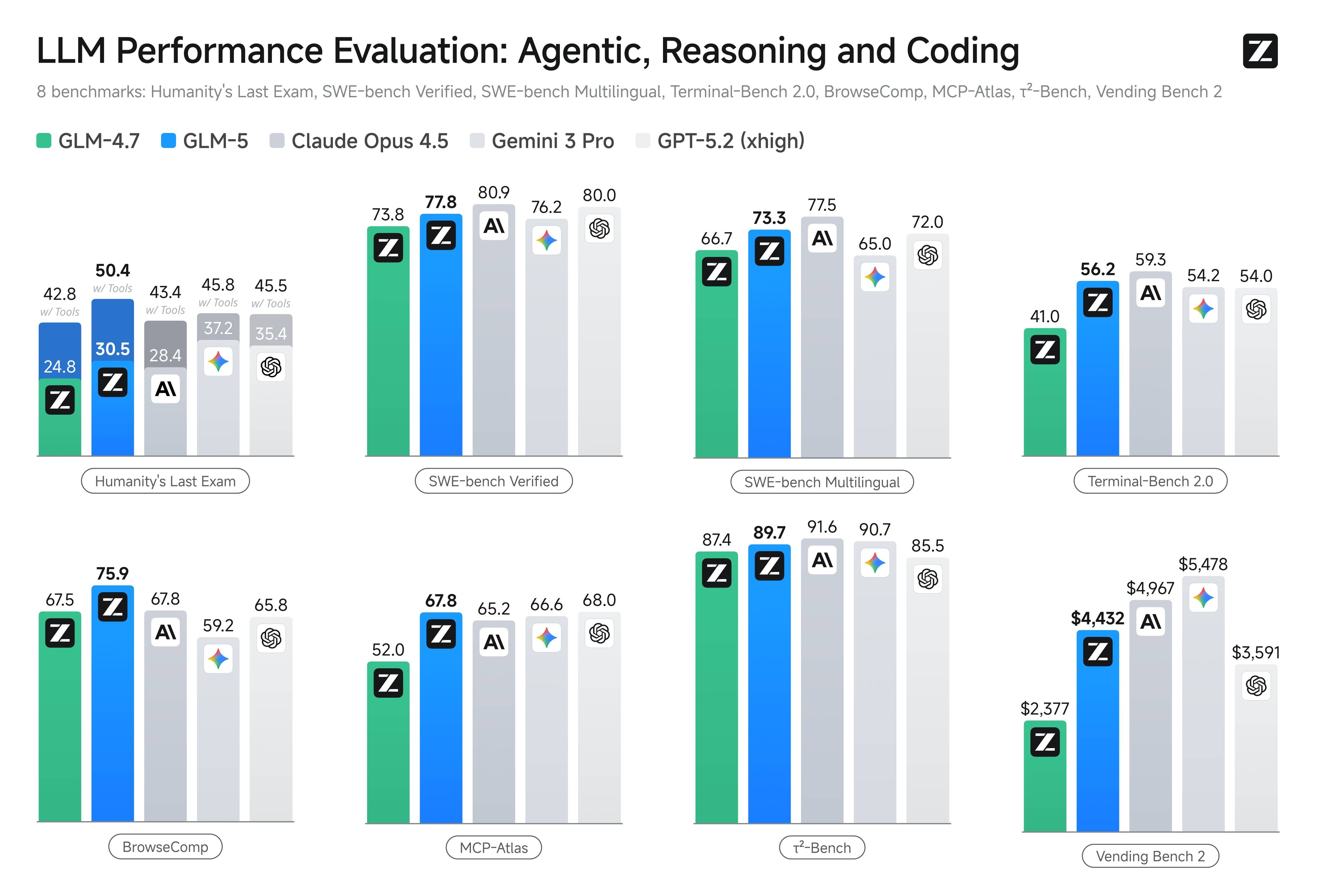

图片来源:智谱 AI 文档

一、 GLM-5 的核心定位与基础规格

本段核心问题:GLM-5 在模型架构和输入输出限制上有哪些关键指标,开发者需要关注什么?

作为一款面向未来的旗舰模型,GLM-5 在基础参数上进行了大幅扩展,以支撑其更强的通用智能水平。对于开发者而言,了解其上下文窗口和输出限制是规划应用架构的第一步。

1.1 关键参数指标

GLM-5 在架构上实现了从“写代码”到“写工程”的跨越,其基础规格如下表所示:

1.2 架构升级的背景

GLM-5 的基座能力提升源于三个维度的技术迭代:

-

参数规模扩展:参数规模从 355B(激活 32B)扩展至 744B(激活 40B),预训练数据量从 23T 提升至 28.5T。这意味着模型见过的数据和模式更多,通用泛化能力更强。 -

异步强化学习:引入全新的 “Slime” 框架,支持异步智能体强化学习算法。这使得模型不仅能从静态数据中学习,还能从长程交互中持续优化策略,这对于 Agent 任务至关重要。 -

稀疏注意力机制:首次集成 DeepSeek Sparse Attention。这一改进在保持长文本处理效果无损的同时,显著降低了部署成本,提升了 Token 处理效率。

二、 能力图谱:从思考到执行的全面覆盖

本段核心问题:GLM-5 具备哪些核心功能特性,如何支撑复杂的应用场景?

GLM-5 的能力设计紧密围绕“工具使用”与“深度思考”展开。它不再仅仅是一个文本生成器,而是一个能够接入外部系统、进行深度推理的智能体核心。

2.1 深度思考模式

这是 GLM-5 最显著的能力之一。通过启用 thinking 参数,模型能够在输出最终结果前,先进行内部的逻辑推演和规划。

-

✦ 应用场景:在处理复杂数学证明、逻辑谜题或多步骤规划时,思考模式能显著提高准确率。 -

✦ 使用方式:在 API 调用中设置 thinking: {"type": "enabled"}。

2.2 强大的工具调用与 MCP 支持

-

✦ Function Call:模型能够精准识别用户意图,并根据预定义的函数签名调用外部工具。 -

✦ MCP (Model Context Protocol):这是一个重要的扩展能力。GLM-5 能够灵活调用外部 MCP 工具与数据源,这意味着它可以打破信息孤岛,直接操作数据库、查询私有知识库或控制物理设备。

2.3 结构化输出与上下文缓存

-

✦ 结构化输出:支持直接输出符合特定 JSON Schema 的数据。这对于将 AI 能力集成到现有业务系统(如 CRM、ERP)中极其关键,避免了繁琐的正则解析。 -

✦ 上下文缓存:针对长对话场景,智能缓存历史上下文,优化了多轮对话的性能和成本。

反思与见解:

在实际开发中,很多模型虽然宣称支持 Function Call,但在参数填充上经常出错(例如类型不匹配)。GLM-5 强调在 MCP-Atlas 等基准测试中的表现,实际上是在解决“工具调用准确性”这一痛点。对于 Agent 开发者来说,工具调用的成功率直接决定了系统的稳定性。 一个能稳定调用 API 的模型,比一个能写诗但无法正确传参的模型更有价值。

图片来源:智谱 AI 文档

三、 推荐场景与实战价值

本段核心问题:在具体的业务流中,GLM-5 最适合解决哪些问题?

技术参数最终要落地到场景中。GLM-5 的能力特性使其在以下领域具有天然优势。

3.1 Agentic Coding(智能体编程)

这不仅仅是代码补全。GLM-5 能够基于自然语言描述,自动生成前后端代码、进行数据处理,甚至完成工程重构。

-

✦ 场景描述:开发人员只需输入“重构用户鉴权模块,引入 OAuth2.0 支持”,模型即可理解现有代码结构,规划修改步骤,并生成可运行的代码。 -

✦ 价值点:显著缩短从需求到产物的迭代周期,降低重复性劳动。

3.2 复杂智能体任务

具备自主决策能力,适合执行“一句话输入到完整交付物”的任务。

-

✦ 场景描述:在办公场景中,指令“分析本季度销售数据并生成 PPT 大纲”。模型需要先读取文件、清洗数据、分析趋势,最后生成结构化大纲。 -

✦ 能力要求:需要长程规划能力,确保在多步骤执行中不偏离目标。

3.3 文本数据提取与信息质检

-

✦ 场景描述:从非结构化的合同、财报中抽取关键字段(如甲方、金额、日期),或识别客服工单中的违规风险。 -

✦ 技术支撑:利用其长上下文和结构化输出能力,将复杂文本转化为可分析的结构化数据。

四、 开发实战:GLM-5 API 调用指南

本段核心问题:如何通过代码实际调用 GLM-5,有哪些关键参数需要注意?

以下是基于官方文档整理的详细接入指南。无论您使用 Python、Java 还是直接通过 cURL,都可以快速上手。

4.1 准备工作

在调用 API 之前,您需要拥有智谱 AI 开放平台的 API Key。请将示例代码中的 your-api-key 替换为您自己的密钥。

4.2 Python SDK 调用实战

Python 是 AI 开发中最主流的语言。GLM-5 推荐使用新的 zai-sdk 以获得最佳体验。

步骤一:安装 SDK

步骤二:基础调用示例

以下代码展示了如何向 GLM-5 发起一个带有“深度思考”功能的对话请求。

参数详解:

-

✦ model: 指定使用glm-5。 -

✦ thinking: GLM-5 的特色参数。启用后,模型会在生成回复前进行思维链推理,适合复杂任务。 -

✦ temperature: 设置为 1.0 有利于生成更具创造性的内容,若需严谨 factual 回答,可适当降低。

步骤三:流式调用

对于长文本生成任务,流式输出能极大提升用户体验,避免长时间等待。

注意:在流式调用中,代码分别处理了 reasoning_content(思考过程)和 content(最终回复),这允许开发者在界面上区分展示模型的推理过程与最终答案。

4.3 Java SDK 接入指南

对于企业级应用,Java 依然是主流选择。

依赖配置

基础调用代码

4.4 cURL 测试命令

如果您想快速测试 API 连通性,可以直接使用 cURL:

五、 性能基准:SOTA 级别的技术验证

本段核心问题:GLM-5 在客观评测中的表现如何证明其技术实力?

GLM-5 的宣传并非空穴来风,其在多个业内公认的基准测试中取得了开源模型的最高分。

5.1 编程能力对标

在 SWE-bench-Verified 和 Terminal Bench 2.0 等真实编程场景测试中,GLM-5 分别获得了 77.8 和 56.2 的高分。这一成绩不仅刷新了开源模型的记录,甚至在某些维度超过了 Gemini 3.0 Pro。

实战意义:这意味着 GLM-5 在处理真实世界的软件工程问题(如 Bug 修复、功能迭代)时,具备了接近顶尖闭源模型的能力。

5.2 Agent 能力评估

在 BrowseComp(联网检索)、MCP-Atlas(工具调用)和 τ²-Bench(复杂规划)测试中,GLM-5 均取得了开源第一的表现。

反思与见解:

Agent 能力与传统的文本生成能力有本质区别。Agent 任务要求模型不仅“懂”知识,还要会“做”事。在 MCP-Atlas 上的高分表明,GLM-5 在多步骤任务执行、资源管理和依赖处理上已经具备了成为“智能体大脑”的资格。这标志着大模型应用从“内容生成”向“系统构建”的转折点。

六、 实用摘要与操作清单

6.1 适用对象速查

-

✦ 应用开发者:适合构建需要调用外部 API 的智能助手。 -

✦ 数据分析师:适合处理长文档财报、自动生成分析报告。 -

✦ 软件工程师:适合辅助代码重构、长篇代码生成。

6.2 接入操作清单

-

获取 Key:注册智谱 AI 开放平台账号并创建 API Key。 -

选型:确认需求,若需深度推理,务必开启 thinking参数。 -

安装 SDK:Python 用户推荐 zai-sdk,Java 用户引入 Maven 依赖。 -

参数配置:注意 max_tokens最大支持 128K,根据任务复杂度调整temperature。 -

流式处理:对于耗时任务,务必实现流式接收逻辑以优化用户体验。

6.3 一页速览

-

✦ 模型:GLM-5(旗舰基座,面向 Agent) -

✦ 上下文:200K 输入 / 128K 输出 -

✦ 核心亮点:深度思考模式、MCP 工具支持、SOTA 编程与 Agent 能力 -

✦ 推荐场景:Agentic Coding、复杂数据提取、长程任务规划 -

✦ 接入方式:Python ( zai-sdk), Java, cURL

七、 常见问答(FAQ)

Q1:GLM-5 的最大上下文长度是多少?

A:GLM-5 支持 200K 的上下文窗口输入,最大输出 Tokens 达到了 128K,适合处理超长文档或生成完整的工程代码。

Q2:如何在 Python 中启用 GLM-5 的思考模式?

A:在调用 client.chat.completions.create 时,传入参数 thinking={"type": "enabled"} 即可开启深度思考模式。

Q3:GLM-5 支持哪些输入和输出模态?

A:目前 GLM-5 的主要输入和输出模态均为文本。

Q4:GLM-5 在编程能力上表现如何?

A:GLM-5 在 SWE-bench-Verified 等基准测试中取得了开源模型最高分,编程能力逼近 Claude Opus 4.5,能够胜任复杂系统工程任务。

Q5:什么是 MCP,GLM-5 支持吗?

A:MCP (Model Context Protocol) 是一种连接外部工具和数据源的协议。GLM-5 支持调用外部 MCP 工具,这极大地扩展了其作为智能体的应用边界。

Q6:使用 GLM-5 进行流式调用时,如何区分思考过程和最终回复?

A:在流式响应的数据块中,可以通过 delta.reasoning_content 获取思考过程内容,通过 delta.content 获取最终生成的回复内容。

Q7:GLM-5 适合做办公场景的自动化吗?

A:非常适合。GLM-5 具备强大的长程规划与记忆能力,能够稳定完成跨阶段、多步骤的复杂办公任务,如财报分析、PPT 大纲生成等。

Q8:旧版的 zhipuai SDK 还能用吗?

A:可以使用,官方文档提供了旧版 SDK 的调用示例,但建议新项目使用新的 zai-sdk 以获得更好的功能支持。