打造企业级 AI 助手:Moltbot AWS 部署、飞书集成与多模型接入实战指南

随着大模型技术的普及,越来越多的团队不再满足于在网页对话框里与 AI 交互,而是希望将 AI 能力深度嵌入到日常工作中。然而,从“玩票性质”的聊天机器人到“企业级”的 AI 助手,中间隔着安全审计、长期在线、多平台接入等诸多门槛。

本文将基于最新的技术实践,详细拆解如何利用亚马逊云科技一键部署方案,在 8 分钟内搭建属于您的 AI 助手 Moltbot(原 Clawdbot),并深入探讨如何接入飞书、配置 MiniMax 以及连接 Kimi K2.5 等多种模型能力,帮助您构建一个稳定、可控且高性价比的企业级 AI 解决方案。

一、 为什么选择 Moltbot 与亚马逊云科技官方方案?

本段核心问题:如何安全、快速地在企业环境中构建一个长期在线且可控的 AI 助手?

您所需要的不仅仅是一个又一个聊天机器人,而是一个能够 7×24 小时运行、可审计、能够深度接入企业协作工具的 AI 助手。Moltbot 正是为解决这一需求而生的开源项目,它能够连接 WhatsApp、Slack、Discord、Telegram 以及国内的飞书等平台,通过团队熟悉的聊天入口完成问答、信息处理、浏览器自动化操作等复杂任务。

在部署方式上,我们强烈推荐采用亚马逊云科技的官方一键部署方案,而非自行拼装服务器。许多团队在尝试自建时,往往会卡在“安全运行”这一关。官方方案的价值在于,它将企业可用的关键环节做成了默认能力,极大地降低了安全风险和维护成本。

1.1 企业级部署的核心优势

亚马逊云科技的标准化方案基于 Amazon EC2、IAM、CloudFormation 和 SSM 等核心服务构建,具有以下显著优势:

-

算力与安全底座:依托亚马逊云科技的全球基础设施,数据存储与计算更符合企业合规要求,且具备高可控性。 -

无需管理模型 API Key:通过 IAM 角色认证直接调用 Amazon Bedrock。这意味着您无需在代码或配置文件中硬编码敏感的 API Key,有效避免了密钥散落与泄露的风险。 -

安全访问机制:通过 SSM Session Manager 进行访问与端口转发,无需暴露公网端口。这种“零公网暴露”的访问方式更符合企业安全策略,减少了被攻击的面。 -

一键部署自动化:利用 CloudFormation 模板,自动创建和配置所有相关资源,部署链路清晰透明。 -

多模型灵活切换:无需修改代码即可在 Claude、Nova、DeepSeek 等 Bedrock 支持的模型间切换,方便根据业务场景选择最适合的模型。

1.2 适用场景:谁最需要先试点?

Moltbot 特别适合那些希望在一个小场景内快速验证 AI 价值的团队。通过在特定业务流中的试点,可以快速看到 ROI(投资回报率)。典型的试点场景包括:

-

市场与战略部门:用于竞品信息跟踪、行业动态日报简报的自动生成与推送。 -

销售与客服团队:作为高频问题的快速响应工具,协助检索资料并生成回复草稿,提升响应效率。 -

管理者助理:自动进行跨渠道信息汇总、会议准备工作以及待办事项的智能提醒。

作者的反思:

从工具属性进化到助理属性,最关键的差异在于“长期在线”和“环境独立性”。如果 AI 助手依赖个人电脑开机运行,它就只是一个工具;只有当它在云端 7×24 小时待命,随时响应企业协作平台的消息时,它才真正成为了团队的一员。

1.3 8 分钟快速部署实战

如果您希望先快速体验,只需按照以下三个步骤操作,即可在约 8 分钟内拥有一个运行在您自有 AWS 账号中的 Moltbot 工作站。

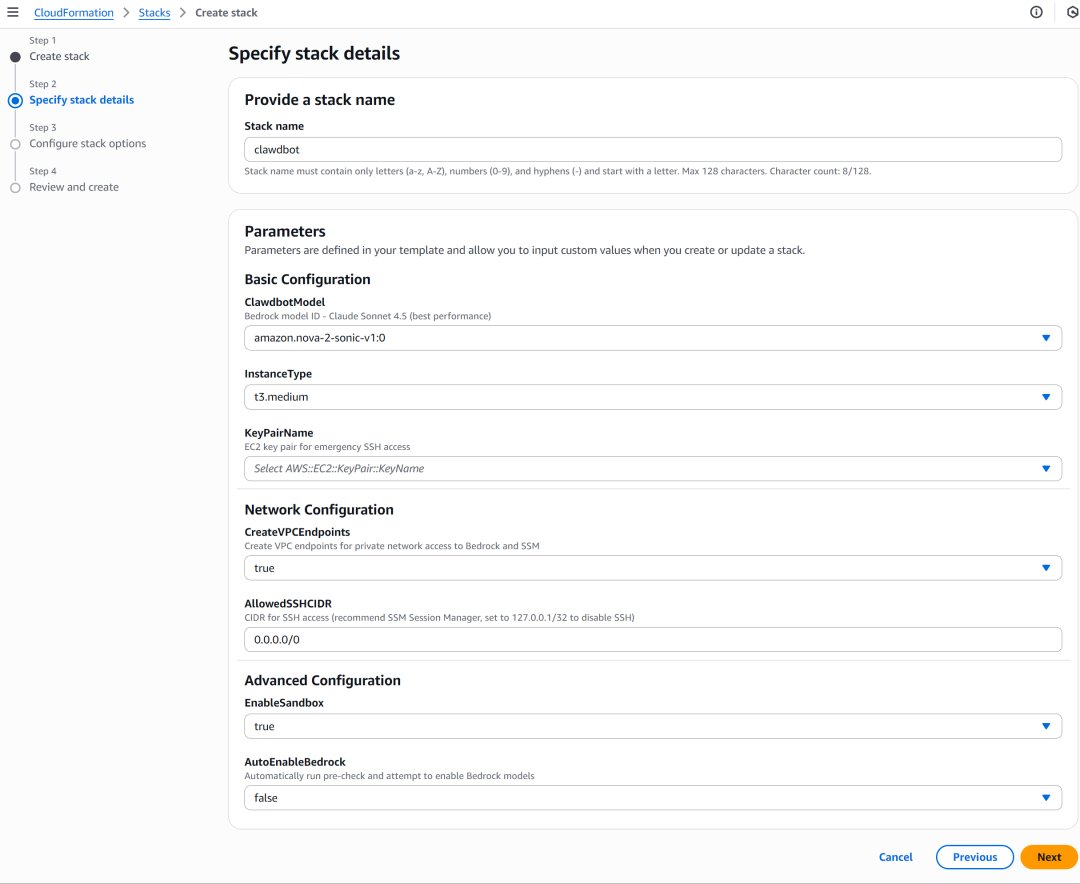

Step 1:一键启动 CloudFormation 部署

点击官方提供的部署按钮,直接进入 CloudFormation 页面。在配置表单中,您只需要选择一个用于连接 EC2 实例的 Key Pair(用于紧急情况下的运维登录),其余的所有资源创建(VPC、安全组、IAM 角色、EC2 实例等)均由模板自动完成。

Step 2:等待约 8 分钟并检查 Outputs

CloudFormation 栈的创建过程大约需要 8 分钟。创建完成后,请务必打开 CloudFormation 控制台的“Outputs”(输出)标签页。这里会显示后续访问和配置的关键指引信息,包括实例 ID 以及访问方式。

Step 3:通过 SSM 访问 Web UI

根据 Outputs 的指引,在您的本地终端安装 SSM Manager 插件,并执行提供的端口转发命令。这一步将本地浏览器的某个端口(如 8080)安全地映射到云端的 Moltbot 服务。之后,您只需在本地浏览器打开指定的 URL,即可进入 Moltbot 的 Web UI 界面开始配置与使用。

二、 深度集成:将 Moltbot 接入飞书(Feishu)协作流

本段核心问题:如何将云端 AI 助手无缝接入到团队日常使用的飞书工作台中?

部署完成后,为了让团队能在熟悉的工具里直接对话,我们通常会选择一个即时通讯入口进行接入。对于国内用户,飞书是首选。以下是如何打通 Moltbot 与飞书的详细步骤。

2.1 飞书侧:创建应用与机器人

首先,您需要在飞书开放平台上创建一个自建应用,并为其配置机器人能力。

-

创建自建应用:登录飞书开放后台,创建一个新的企业自建应用,获取

App ID和App Secret。图像 -

添加机器人能力:在应用的功能开通页面,启用“机器人”能力,这将允许该应用通过接收和发送消息来与用户交互。

图像 -

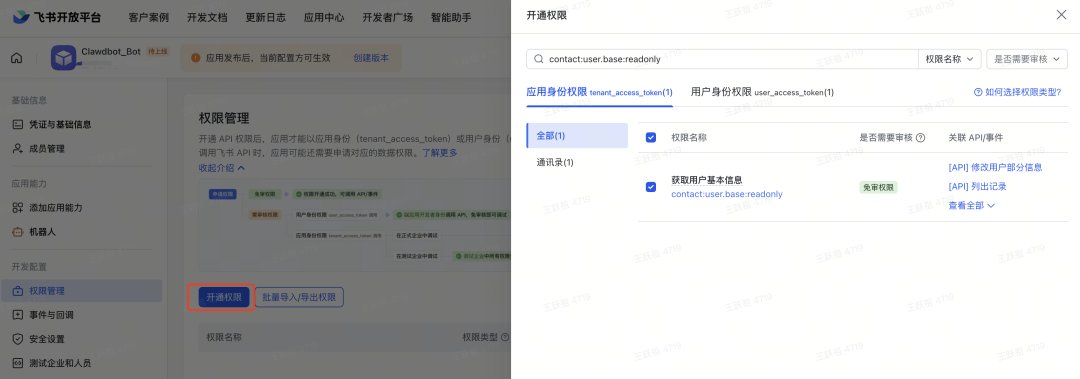

开通权限范围:根据实际使用需求,配置必要的 API 权限。例如,获取群组信息、发送消息接收消息等权限是基础配置。

图像

2.2 Moltbot 侧:配置 Feishu Channel

接下来,需要在 Moltbot 中填入飞书凭证并建立连接。

(1)获取并配置凭证

使用 clawdbot 命令行工具或直接修改配置文件,将飞书的凭证填入。关键配置包括 App ID、App Secret 以及开启启用状态。

# 设置飞书 App ID

clawdbot config set channels.feishu.appId "cli_xxxxx"

# 设置飞书 App Secret

clawdbot config set channels.feishu.appSecret "your_app_secret"

# 启用飞书通道

clawdbot config set channels.feishu.enabled true

(2)凭证获取与界面操作

在飞书后台完成凭证的复制后,将其粘贴到 Moltbot 的配置界面或文件中。这一步建立了 Moltbot 与飞书应用之间的信任关系。

2.3 消息事件接入与联调验证

最后一步是配置飞书的事件回调,使其能将用户的消息实时推送给 Moltbot。

-

事件订阅配置:在飞书应用的事件订阅/回调配置中,选择使用长连接方式接收回调。这种方式对于部署在私有子网或通过 SSM 访问的云端实例更为友好。

-

校验与发布:完成签名校验与重试逻辑配置后,即可发布应用。

图像 图像 -

联调验证:在飞书群聊中 @ 机器人,或发起私聊,测试其是否能正确响应。您也可以尝试发送卡片消息,测试富文本交互的效果。

图像

作者的反思:

在配置飞书接入的过程中,最大的技术难点往往不在于代码,而在于权限管理和回调地址的配置。特别是采用长连接模式时,需要确保云端实例能够主动发起连接。这种配置虽然初期略显繁琐,但一旦打通,用户体验极其流畅,完全屏蔽了后端的技术复杂度。

三、 模型进阶:配置 MiniMax 避免封号风险与降低成本

本段核心问题:在接入大模型时,如何规避个人订阅账号被封禁的风险并实现成本控制?

随着 Moltbot 的流行,很多用户开始尝试将其接入各类模型提供商。然而,直接使用 Claude 或 ChatGPT 的个人订阅 API Key 存在极大风险——已有大量案例表明,Anthropic 等厂商会对违反服务协议的企业调用进行封号处理。因此,选择一个合规、稳定且高性价比的 Provider(如 MiniMax)成为了许多团队的首选。

3.1 获取 API Key

MiniMax 分为国内版和海外版,两者均可接入 Moltbot,但注册地址和配置细节有所不同。

-

国内版:适合主要业务在国内的团队,访问速度快。 -

海外版:适合需要对接海外业务或特定模型的场景。

注册并选择合适的套餐支付后,在账户管理(Account)界面即可获取 API Key。请务必妥善保管此 Key。

3.2 配置 Moltbot 连接 MiniMax

根据您选择的版本,配置流程分为两种情况。

情况 A:使用海外版 API(标准流程)

这是最简单的配置方式,适用于使用官方标准接口的场景。

-

在终端输入配置命令启动向导: clawdbot configure -

进入 Model/auth菜单,选择MiniMax M2.1。 -

粘贴您获取的 API Key。 -

当提示选择 “Models in /model picker (multi-select)” 时,直接回车,系统会自动选中默认模型。 -

系统提示 “Updated ~/.clawdbot/clawdbot.json” 后,选择 Continue 即可完成设置。

情况 B:使用国内版 API

国内版 API 需要手动调整配置文件以适配特定的端点和认证头。

-

先生成基础配置:先按“情况 A”的操作走一遍,填入 Key 但不设为默认。这一步的目的是让系统自动生成基础的 JSON 结构,省去手写配置文件的麻烦。 -

修改配置文件:使用编辑器(如 nano)打开配置文件: nano ~/.clawdbot/moltbot.json -

手动修改地址:找到 baseUrl字段,将其修改为国内版 API 的服务地址,并增加"authHeader": true配置项以满足认证要求。 -

保存退出:按 Ctrl+O回车保存,Ctrl+X退出编辑器。

最后,重启服务以使配置生效:

clawdbot gateway restart

3.3 实战案例:2 分钟构建多时区小应用

配置完成后,我们可以通过一个实际任务来验证 MiniMax 的工具执行准确度。

场景:需要一个能够展示全球多时区时间的小型 Web 应用。

操作步骤:

-

询问方案:首先在聊天窗口询问 Moltbot 如何实现,它会建议使用 Nginx 部署静态页面的方案。

图像 -

执行部署:选择让 AI 自动执行 Nginx 的安装和代码编写。整个过程从安装 Nginx 到生成 HTML/CSS 任务仅耗时 2 分钟,且全程无报错。

图像 -

验证效果:直接在浏览器中访问生成的页面,查看不同时区的时间显示效果。

图像

这个案例展示了 Moltbot 结合 MiniMax 在日常任务处理中的高效性。相比昂贵的 Opus 或 GPT-4 模型,这种组合在做非生产级的 Demo 和小工具时具有极高的性价比。

作者的反思:

很多开发者担心国产模型的能力,但在具体的工具调用(Tool Use)场景下,MiniMax 的表现往往超出预期。特别是在编写代码、部署服务等结构化任务上,其准确性和速度完全能满足日常辅助开发的需求。这提醒我们,在选择模型时,不应只盯着基准测试分数,而应关注具体场景下的“够用”程度和成本效率。

四、 快速接入:将 Kimi K2.5 连接到 Moltbot

本段核心问题:如何利用 Kimi K2.5 的编码能力快速增强 Moltbot 的代码生成能力?

随着 Kimi K2.5 的热度攀升,许多用户希望将其强大的代码能力接入到 Moltbot 中。以下是详细的接入步骤,帮助您在几分钟内完成配置。

4.1 获取 Kimi Code 访问权限

-

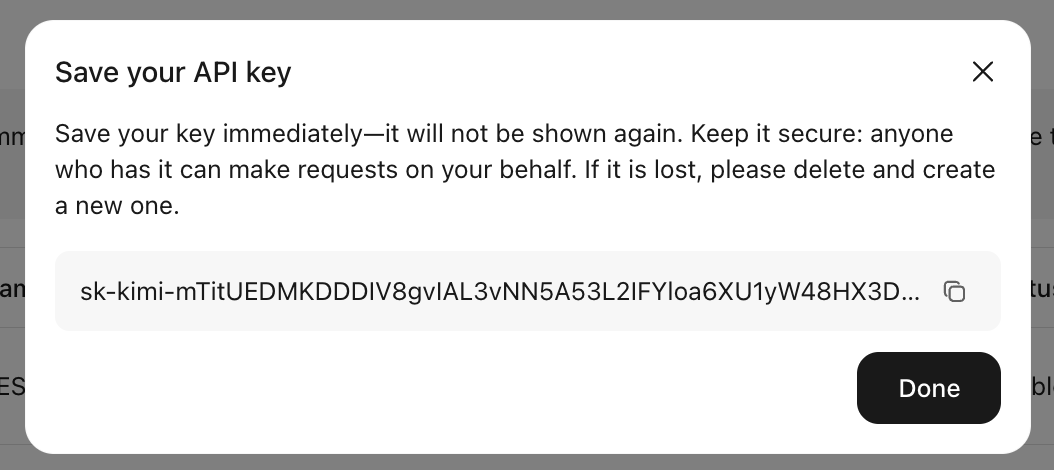

获取套餐:访问 Kimi Code 平台,注册并选择适合您的套餐计划。

图像 -

复制 API Key:在账户页面获取您的专属 API Key。请注意,Key 通常只显示一次,请务必立即复制保存。

图像 图像

4.2 安装与登录 Moltbot

如果您尚未安装 Moltbot,可以使用官方提供的快速启动脚本:

curl -fsSL https://molt.bot/install.sh | bash

执行该命令后,系统会自动下载并安装必要组件。

安装完成后,当屏幕出现配置向导时,您可以开始设置您的 Jarvis 代理。

4.3 配置 Kimi 模型与 Hooks

-

粘贴 API Key:在配置界面中,粘贴您从 Kimi Code 获取的 API Key。

图像 -

选择模型:在模型选择列表中,选择

kimi-code/kimi-for-coding。此时通道(Channel)选择为可选项目,您可以先跳过。图像 -

配置 Hooks:这一步允许您定制会话行为。

-

Inject markdown on startup:在会话开始时注入类似 README 的内容,用于设定上下文或规则。 -

Command/operation logging:记录会话期间执行的命令和操作,便于审计和回溯。 -

Context continuity:保存当前会话上下文的摘要,以便在新会话中无缝恢复。

根据您的需求勾选相应的 Hooks。

图像 -

-

重启服务:如果您本地已有运行中的 Gateway,建议重启服务以确保新配置生效:

clawdbot gateway restart图像 -

孵化 Bot:执行

clawdbot hatch或相应的启动命令,系统将自动跳转到 Bot 的聊天页面。图像

此时,您已成功连接 Kimi K2.5,可以开始享受高质量的代码生成与辅助服务。

作者的反思:

Moltbot 的设计哲学非常有意思,它用“Hatch(孵化)”这个词来形容 Bot 的启动过程,仿佛在创造一个有生命的数字助手。接入 Kimi K2.5 的过程之所以流畅,很大程度上归功于其标准化的 API 接口和清晰的配置向导。这再次印证了一个观点:好的工具应该让复杂的配置过程变得像填空题一样简单,让用户把精力集中在“怎么用”而不是“怎么装”上。

五、 落地服务:当团队需要“当天开箱即用”

本段核心问题:如果团队缺乏运维或开发人力,如何快速落地并验证 Moltbot 的价值?

虽然上述部署和配置过程在技术上是可行的,但对于非技术背景的业务团队或时间紧迫的项目,实际操作中往往会遇到各种细节问题。常见的痛点包括:模型权限设置复杂、端口转发依赖本地环境、各种 Channel 的回调配置调试困难,以及不知道该选什么场景进行试点。

针对这些痛点,专业技术服务商(如作为亚马逊云科技核心级合作伙伴的聚云科技)提供了“当天开箱即用”的技术服务包,帮助企业快速跨越技术鸿沟。

5.1 服务包 A:当天开箱即用(推荐)

这是最适合大多数团队的快速启动方案,旨在让客户当天就能看到效果。

-

代部署服务:专家团队直接在您的 AWS 账号(或托管账号)上执行一键部署。 -

代接入服务:帮助您接通 1 个消息入口(可在 Slack、Telegram、WhatsApp、Discord 中任选)。 -

代演示脚本:提供一份“试点场景 Demo”脚本,指导您如何在 15 分钟内向业务方演示 AI 助手的能力。 -

标准交付物:包括可访问的 URL、详细使用说明文档以及基础安全建议。

目标:当天可用、当天能演示、当天能开始试点。

5.2 服务包 B:企业试点增强(1-2 周)

对于有更高治理和扩展需求的团队,此服务包提供了更深度的支持。

-

多入口接入:接入更多消息平台,特别是企业内部协作工具(如飞书、钉钉等)。 -

基础治理:配置使用范围限制、群白名单管理、权限最小化原则实施。 -

运维托管(可选):提供日志监控、告警通知、版本升级窗口管理等运维服务。

5.3 试点建议:从“1 个场景”开始

无论您选择自建还是购买服务,建议试点初期只聚焦于一件事:

-

选准 1 个入口:团队最常用的沟通工具是什么?(如 Slack 或飞书)。 -

定死 1 个场景:解决一个具体的痛点(如“竞品雷达”或“销售客服提速”)。 -

快速验证:当天跑通、当天演示,并在 1-2 周内验证其 ROI。

只有在小范围内验证了价值,再考虑扩展到更多入口、应用到更多场景,才是理性的技术落地路径。

结论与实用摘要

Moltbot(原 Clawdbot)不仅仅是一个开源的 AI 聊天机器人,它是一个构建企业级 AI 助手的强大底座。通过亚马逊云科技的 CloudFormation 一键部署方案,我们解决了安全性和基础设施的难题;通过接入飞书等协作平台,我们实现了工作流的融合;通过灵活配置 MiniMax 和 Kimi K2.5 等多模型,我们平衡了性能、安全与成本。

对于技术团队,按照本文的步骤,您可以在 8 分钟内完成基础设施搭建,并逐步接入各类模型。对于业务团队,借助专业的技术服务,您可以当天就拥有一个可演示、可试点的 AI 助手。关键在于从小处着手,让 AI 真正成为团队生产力的一部分。

实用摘要 / 操作清单

-

部署准备:确保拥有 AWS 账号及 EC2 Key Pair。 -

基础设施:点击 CloudFormation 链接,等待 8 分钟栈创建完成,记录 Outputs 信息。 -

本地访问:安装 SSM Plugin,配置端口转发,打开本地 Web UI。 -

接入飞书:在飞书开放平台创建机器人应用,获取 App ID/Secret,在 Moltbot 中配置 channels.feishu,启用长连接回调。 -

配置 MiniMax:注册获取 Key,海外版直接 clawdbot configure,国内版需修改moltbot.json的baseUrl并增加authHeader。 -

配置 Kimi:注册 Kimi Code 获取 Key,执行安装脚本,选择 kimi-code/kimi-for-coding模型,配置所需 Hooks。 -

安全提示:优先使用 IAM 角色调用 Bedrock,避免暴露 API Key;生产环境务必配置权限白名单。

一页速览(One-page Summary)

| 组件/环节 | 推荐方案/工具 | 关键步骤/命令 | 核心价值 |

|---|---|---|---|

| 基础设施 | AWS CloudFormation | 点击部署 -> 选 Key Pair -> 等待 8 分钟 | 企业级安全底座,无需管理 API Key,无公网端口暴露 |

| 协作入口 | 飞书 | 创建自建应用 -> 配置机器人权限 -> Moltbot 填入凭证 -> 启用长连接 | 接入日常工作流,提升团队接受度 |

| 模型选择 (A) | MiniMax (海外) | clawdbot configure -> 选 MiniMax M2.1 -> 填 Key |

规避 Claude/ChatGPT 封号风险,性价比高 |

| 模型选择 (B) | MiniMax (国内) | 修改 ~/.clawdbot/moltbot.json -> 改 baseUrl -> 重启 |

国内访问优化,适配特定接口标准 |

| 模型选择 (C) | Kimi K2.5 | curl -fsSL https://molt.bot/install.sh -> 填 Key -> 选 kimi-code |

强大的代码生成能力,适合开发辅助场景 |

| 落地服务 | 聚云科技服务包 | 购买服务 A -> 提供账号信息 -> 等待交付 | 当天部署、接入、演示,快速验证 ROI |

常见问题(FAQ)

Q1:在 AWS 上部署 Moltbot 需要自己准备模型的 API Key 吗?

A:不需要。如果您使用亚马逊云科技官方推荐的 Bedrock 方案,系统通过 IAM 角色认证进行调用,完全避免了 API Key 管理和泄露的风险。

Q2:部署 Moltbot 是否需要开放服务器的公网端口?

A:不需要。官方推荐使用 SSM Session Manager 进行端口转发和访问,这种方式不需要在安全组中开放任何入站规则,极大提升了安全性。

Q3:从点击部署到 Moltbot 可用通常需要多长时间?

A:通常只需要约 8 分钟。CloudFormation 栈创建完成后,根据 Outputs 中的指引进行本地端口转发即可使用。

Q4:团队中没有运维或开发人员能够完成这些配置怎么办?

A:可以考虑购买“当天开箱即用”的技术服务。服务商可以提供代部署、代接入、代演示脚本等全流程服务,让您当天就能看到效果。

Q5:MiniMax 国内版和海外版在配置上有什么主要区别?

A:海外版可以直接通过命令行向导配置。国内版在生成基础配置后,需要手动编辑 moltbot.json 文件,将 baseUrl 修改为国内服务地址,并添加 authHeader: true 配置。

Q6:接入 Kimi K2.5 时,Hooks 的作用是什么?

A:Hooks 允许您定制会话行为。例如,“Inject markdown on startup” 可以预设提示词,“Command/operation logging” 可以记录操作日志,“Context continuity” 可以保持多会话间的上下文连贯性。

Q7:Moltbot 除了飞书,还能接入哪些平台?

A:Moltbot 原生支持 WhatsApp、Slack、Discord、Telegram 等多个主流平台,且配置逻辑与飞书类似,都基于 Channel 适配机制。

Q8:建议企业试点时从哪个场景开始?

A:建议“选一个入口,选一个场景”。例如,接入 Slack 或飞书,选择“竞品信息跟踪”或“客服快速回复”作为单一试点场景,先跑通流程并演示效果,再逐步扩展。