使用Llama Library在边缘设备上实现高效离线AI推理

什么是Llama Library?

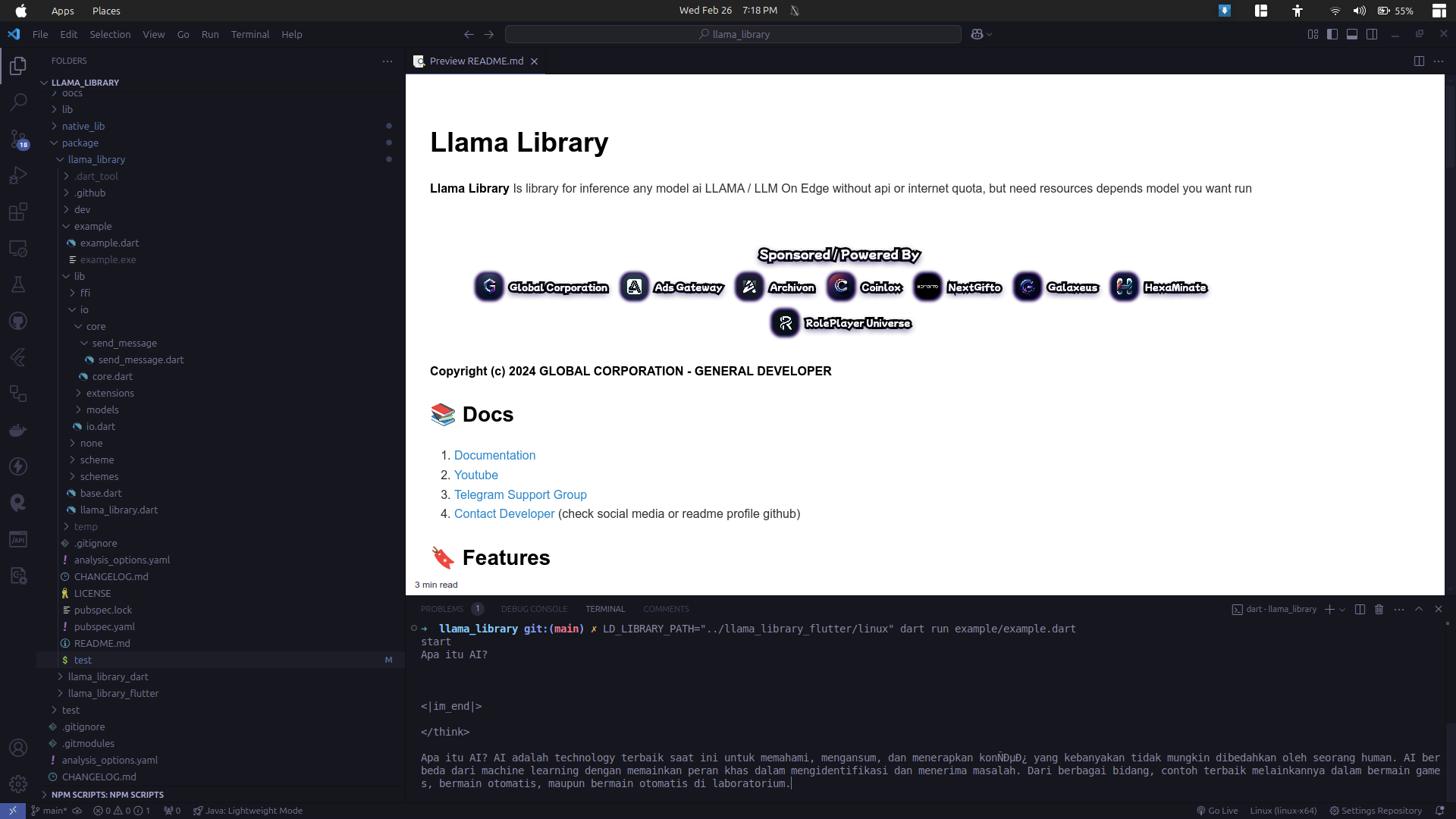

Llama Library 是一款专为边缘计算环境设计的AI推理库,支持本地化运行LLAMA及其他大语言模型(LLM)。通过完全离线的工作模式,开发者无需依赖API接口或消耗网络流量配额即可实现智能推理功能。该库已在多个实际应用场景(包括移动应用、服务端程序、聊天机器人等)中验证其稳定性和高效性。

核心技术优势解析

📱 全平台兼容支持

-

支持设备端原生应用开发 -

完美适配边缘无服务器架构(Edge Serverless) -

示例项目已验证Android/iOS/Windows/macOS/Linux全平台运行

📜 标准化开发规范

-

统一API接口设计规范 -

预置完善的错误处理机制 -

提供类型安全的Scheme数据结构

⌨️ 命令行工具集成

-

内置CLI辅助开发工具 -

支持项目脚手架快速生成 -

提供调试诊断命令集

🔥 多场景API支持

// 典型API调用示例

await llamaLibrary.invoke(

invokeParametersLlamaLibraryData: InvokeParametersLlamaLibraryData(

parameters: SendLlamaLibraryMessage.create(

text: text,

is_stream: false,

)

)

);

模型兼容与硬件要求

支持的模型格式

-

全面兼容llama.cpp生态模型 -

推荐使用GGUF量化格式(如Meta-Llama-3.1-8B-Q4_0) -

支持模型动态加载与热切换

硬件配置建议

| 设备类型 | 推荐配置 | 适用模型规模 |

|---|---|---|

| 移动设备 | 骁龙8系/苹果A15+ 神经网络引擎 | <3B参数量 |

| 桌面电脑 | NVIDIA RTX 3060+ | 7B-13B参数量 |

| 服务器 | 双路EPYC+多卡并行 | >20B参数量 |

开发环境配置指南

Dart环境安装

dart pub add llama_library

Flutter跨平台集成

flutter pub add llama_library_flutter ggml_library_flutter

依赖项管理

-

必须包含本地推理引擎 libllama.so -

推荐使用FFI进行本地库绑定 -

支持动态加载模型文件(.gguf)

实战开发示例

模型加载与初始化

File modelFile = File("deepseek-r1-distill-qwen-1.5b-q4_0.gguf");

final llamaLibrary = LlamaLibrary(

sharedLibraryPath: "libllama.so",

invokeParametersLlamaLibraryDataOptions: InvokeParametersLlamaLibraryDataOptions(

invokeTimeOut: Duration(minutes: 10)

);

实时流式响应处理

llamaLibrary.on(

eventType: llamaLibrary.eventUpdate,

onUpdate: (data) {

if (update.is_done == false) {

stdout.write(update.text); // 实时输出生成内容

}

}

);

交互式命令行应用

stdin.listen((e) async {

final text = utf8.decode(e).trim();

if (text == "exit") {

llamaLibrary.dispose(); // 安全释放资源

}

});

性能优化实践

内存管理技巧

-

使用 dispose()及时释放模型实例 -

配置 invokeTimeOut预防死锁 -

启用 isThrowOnError错误拦截

推理加速方案

-

量化模型优先选用Q4_0/Q5_K_M格式 -

启用Metal后端(iOS/macOS) -

使用CUDA加速(NVIDIA显卡)

成功案例参考

跨平台AI应用实例

-

支持语音输入转文本 -

实现多轮对话管理 -

内置知识截止时间控制

开发者资源汇总

学习资料

技术支持

版本演进路线

2025年发展规划

-

Q1 推出模型并行计算支持 -

Q2 增加WebAssembly运行时 -

Q3 实现自动模型量化工具 -

Q4 发布企业级管理控制台

常见问题解答

模型加载失败排查

-

验证模型文件完整性 -

检查文件读写权限 -

确认ggml版本兼容性

推理速度优化

-

启用 is_stream分块输出 -

调整 n_threads线程数 -

使用 n_batch控制批处理大小

开源协议声明

本项目采用GLOBAL CORPORATION通用商业授权,开发者可免费用于非商业用途。商业应用需联系授权团队获取正式许可。

– www.xugj520.cn –